Évaluer le confort thermique des ambiances froides

Effet du froid sur le corps humain

Travailler dans des températures froides comme en boucherie peut être dangereux pour la santé pouvant même, à l’extrême, entraîner la mort (au risque de faire sourire certain, rester bloqué dans une chambre de congélation pendant un temps prolongé peut être fatal). Le corps doit absolument maintenir sa température corporelle à 37 °C pour préserver la santé des personnes et aussi fournir l’énergie nécessaire aux activités physiques. Le métabolisme sert au corps humain à s’adapter aux conditions difficiles de travail dans des ambiances froides.

Afin de maintenir son équilibre thermique en zone froide, le corps dispose de mécanismes de régulation :

- Un mécanisme très complexe de régulation physiologique qui a pour but d’adapter le métabolisme et l’échange de chaleur au niveau de la peau et des poumons en fonction des conditions intra et extracorporelles. Pour demeurer actif dans une zone froide, le corps compense la perte constante de chaleur par la production équivalente de chaleur en « brûlant » le glycogène qui est notre carburant vital. Les frissons, par exemple, augmentent la production de chaleur de notre corps de l’ordre de 500 %. À ce niveau de consommation, notre corps s’épuise en quelques heures; raison pour laquelle le risque de s’endormir dans des ambiances froides est non négligeable.

- Des mécanismes comportementaux qui permettent à l’humain d’améliorer sa tolérance au froid. Il peut très bien adapter son alimentation, son hydratation, sa tenue vestimentaire, ses attitudes posturales et physiques.

Quels risques pour la santé ?

L’exposition aux basses températures se rencontre fréquemment dans la chaîne de froid alimentaire que ce soit au niveau du personnel que des clients. Les principaux effets sur la santé d’une exposition directe et prolongée au froid sont :

- l’hypothermie;

- l’engelure;

- un risque accru de troubles musculosquelettiques (TMS) en cas d’exposition prolongée;

Il faut être particulièrement vigilant dès que la température ambiante devient inférieure à 5 °C; ce qui se rencontre assez régulièrement dans les commerces (boucherie, poissonnerie, …)

Hypothermie

L’hypothermie est une des principales causes de mortalité liée à l’exposition directe au froid. Dans les commerces, ce risque est uniquement présent dans les chambres froides à 4 °C et – 18 °C. Pour cette raison, les portes des chambres froides sont toujours équipées de moyens d’ouverture des portes de l’intérieur.

Le tableau suivant montre les différents stades de l’hypothermie :

|

Manifestation clinique de l’hypothermie

|

|||

|

Niveau

|

Température corporelle |

Symptômes

|

|

|

Léger

|

35 – 32 °C

|

|

|

|

Modéré

|

< 32,2 – 28 °C

|

|

|

|

Sévère

|

< 28 °C

|

|

|

Engelure

C’est le premier degré de la gelure. Dans les zones froides des commerces, c’est surtout les extrémités et surtout les mains qui sont les plus exposées au froid lors des manutentions des denrées alimentaires congelées par exemple.

Douleurs

La sensation de froid suivie de douleurs dans les parties exposées du corps est l’un des signes de gelures ou d’une hypothermie légère.

Acrosyndrome et syndrome de Raynaud

Le syndrome de Raynaud est le résultat d’une diminution du diamètre des artérioles des mains et des orteils lors d’une exposition prolongée au froid. La diminution du diamètre entraîne une réduction de l’irrigation sanguine dans les extrémités et se traduit par l’apparition d’une pâleur de deux à trois doigts de chaque main.

Troubles musculosquelettiques

Des études ont mis en évidence une relation entre des troubles musculosquelettiques et les situations de travail dans le froid associées à des facteurs tels que :

- des mouvements répétitifs;

- des amplitudes articulaires importantes;

- des postures extrêmes;

- des vibrations;

- du temps de repos insuffisant;

- du stress;

- …

Quels facteurs de risque ?

Les risques dépendent de différents facteurs :

- climatiques ou ambiants tels que la température, l’humidité et la vitesse de l’air;

- liés au poste de travail ou à la tâche à exécuter;

- individuels.

Facteurs climatiques ou ambiants : la température

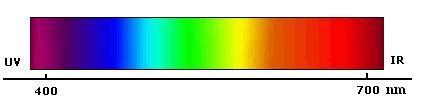

La température et l’humidité de l’air sont deux des 6 paramètres qui influencent la sensation de confort thermique. On retrouve en effet :

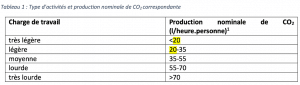

- Le métabolisme, qui est la production de chaleur interne au corps humain permettant de maintenir celui-ci autour de 36,7 °C. Un métabolisme de travail correspondant à une activité particulière s’ajoute au métabolisme de base du corps au repos.

- L’habillement, qui représente une résistance thermique aux échanges de chaleur entre la surface de la peau et l’environnement.

- La température ambiante de l’air Ta.

- La température moyenne des parois Tp.

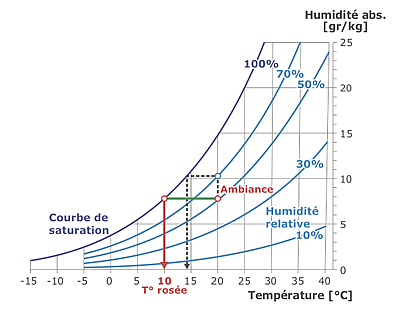

- L’humidité relative de l’air (HR), qui est le rapport exprimé en pourcentage entre la quantité d’eau contenue dans l’air à la température Ta et la quantité maximale d’eau contenue à la même température.

- La vitesse de l’air, qui influence les échanges de chaleur par convection.

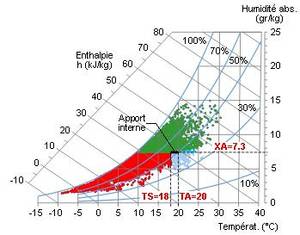

En général le couple température-humidité est indissociable dans des conditions climatiques normales sous nos latitudes.

Le problème des températures au niveau de la chaîne de froid alimentaire est conditionné par le respect des températures de conservation tout au long de la chaîne. Nécessairement, ces températures sont basses et n’entrent pas dans les températures de confort pour le corps humain.

À partir de températures inférieures à :

- 15 °C, notamment pour les postes statiques ou de pénibilité légère, l’inconfort a des fortes chances de se ressentir mais varie selon les individus;

- 5 °C et en particulier à des températures négatives, le risque pour la santé est immédiat comme dans le cas de travail dans les chambres froides de stockage positives ou négatives.

Clairement, les ambiances froides dans lesquelles évoluent les travailleurs sont inconfortables; elles sont dues principalement aux basses températures et à l’humidité.

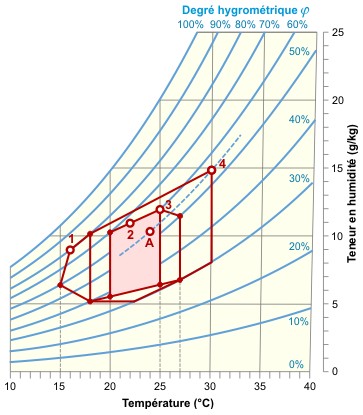

Par rapport à la plage de confort hygrothermique habituellement présentée (extrait de l’article de R. Fauconnier L’action de l’humidité de l’air sur la santé dans les bâtiments tertiaires paru dans le numéro 10/1992 de la revue Chauffage Ventilation Conditionnement), on voit tout de suite qu’au niveau de nombreux postes de travail l’inconfort est souvent présent :

-

dans les allées froides, les températures peuvent descendre sous les 16 °C, ce qui signifie qu’en été, par exemple, le choc thermique peut être important vu que les clients passent rapidement d’une ambiance chaude (rayon « no food »), voire surchauffée (boulangerie), à une ambiance réfrigérée;

-

dans les zones climatisées basses (12 °C) et en chambre froide (0 °C, 4 °C et -18 °C).

- Zone à éviter vis-à-vis des problèmes de sécheresse.

- et 3 : Zones à éviter vis-à-vis des développements de bactéries et de microchampignons.

- Zone à éviter vis-à-vis des développements d’acariens.

- Polygone de confort hygrothermique.

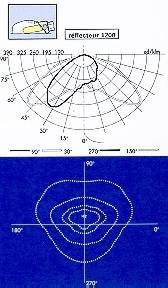

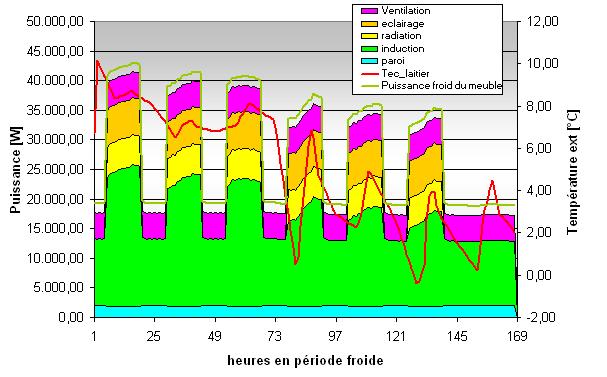

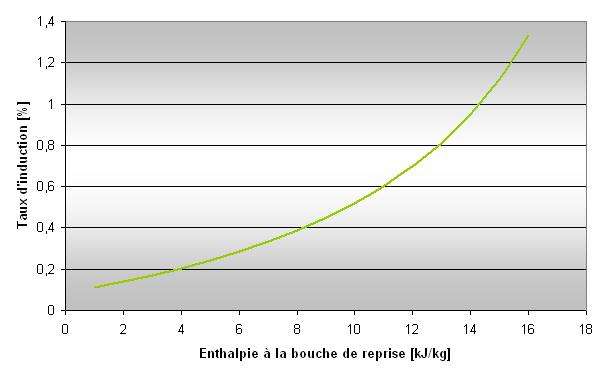

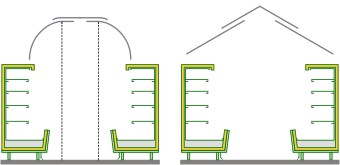

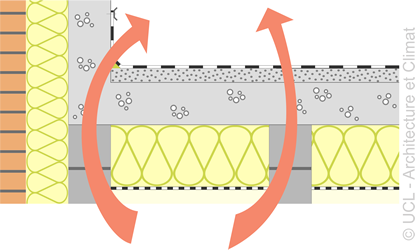

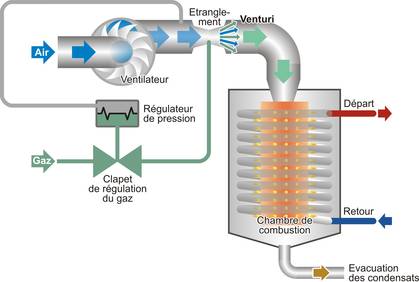

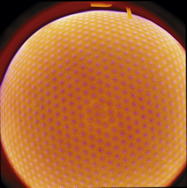

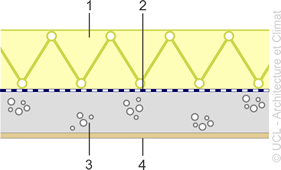

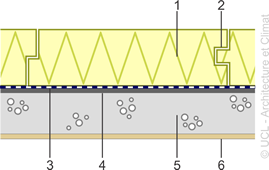

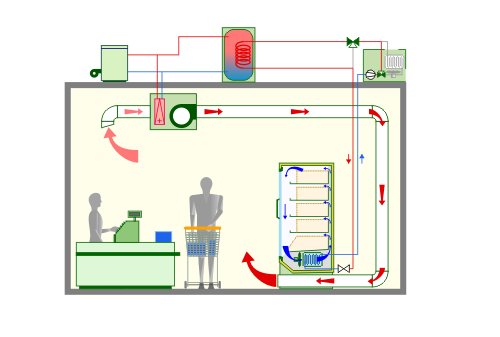

Le schéma suivant représente des polygones de fonctionnement classiques des meubles frigorifiques dans les zones de vente. Le polygone « rose » représente l’ambiance de la zone (température, hygrométrie) dans laquelle le meuble frigorifique fonctionne correctement. C’est aussi en grande partie la zone de confort des usagers. On voit tout de suite que l’inconfort se situe à l’extrême gauche du polygone de confort. En pratique, dans les allées froides, cette limite est souvent atteinte.

La zone hachurée correspond à la zone de confort.

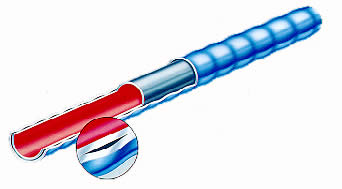

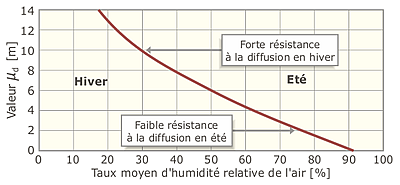

Facteurs climatiques ou ambiants : l’humidité

L’humidité relative influence le confort du corps humain dans le sens où la perte de chaleur du corps humain augmente dans des conditions humides. Cependant, le taux d’humidité présent aux températures basses de la chaîne de froid dépend de plus en plus :

- de l’échange hygrothermique qui s’opère avec l’ambiance extérieure;

- de l’occupation (respiration des personnes dans l’ambiance froide).

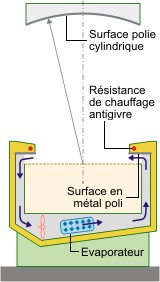

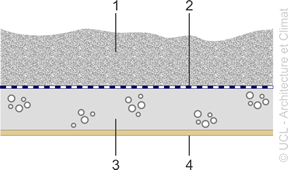

En effet, à part les fruits et les légumes, les denrées alimentaires sont souvent conditionnées dans des emballages qui réduisent ou évitent leur échange hygrométrique avec l’ambiance froide. De plus, l’humidité résiduelle présente dans l’ambiance froide va en grande partie se condenser et geler sur les ailettes de l’évaporateur qui agissent comme déshumidificateur. Il en résulte que l’humidité absolue dans les ambiances froides reste sensiblement basse. Toutefois, même dans une ambiance relativement froide avec une humidité absolue faible, l’inconfort peut aussi être présent pour des humidités relatives élevées.

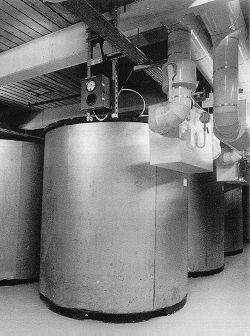

Accumulation de l’humidité ambiance sur les ailettes de l’évaporateur (« prise en glace »).

Facteurs climatiques ou ambiants : la vitesse

La vitesse de l’air est un facteur qui renforce la sensation d’inconfort. On parle souvent d’une vitesse de l’ordre de 0.2 m/s maximum pour ne pas augmenter l’inconfort dans les zones à basse température.

| Grille des températures ressenties en fonction de la vitesse du vent et niveau de danger d’une exposition au froid | ||||||||

| Indice de refroidissement éolien | ||||||||

|

Vitesse de l’air [m/s] |

La température réellement mesurée correspond à une vitesse de vent nulle [°C] | |||||||

|

0

|

5 | 0 |

-5 |

-10 |

-15 | -20 | -25 | -30 |

|

1,4

|

4 | -2 | -7 | -13 | -19 | -24 | -30 | -36 |

|

2,8

|

3 | -3 | -9 | -15 | -21 | -27 | -33 | -39 |

|

4,2

|

2 | -4 | -11 | -17 | -23 | -29 | -35 | -41 |

|

5,6

|

1 | -5 | -12 | -18 | -24 | -31 | -37 | -43 |

| 7 | 1 | -6 | -12 | -19 | -25 | -32 | -38 | -45 |

|

8,3

|

0 | -7 | -13 | -20 | -26 | -33 | -39 | -46 |

|

9,7

|

0 | -7 | -14 | -20 | -27 | -33 | -40 | -47 |

|

11,1 |

-1 | -7 | -14 | -21 | -27 | -34 | -41 | -48 |

|

12,5

|

-1 | -8 | -15 | -21 | -28 | -35 | -42 | -48 |

|

13,9

|

-1 | -8 | -15 | -22 | -29 | -35 | -42 | -49 |

| Risque faible. | Risque modéré. | Risque élevé. | ||||||

|

Risque faible.

|

|

|

Risque modéré.

|

|

|

Risque élevé.

|

|

Photo chambre froide.Source : Commission de la Santé et de la Sécurité au Travail (CSST/Canada) : Contrainte thermique : Le froid; Service Météorologique du Canada : le refroidissement éolien.

Facteurs inhérents au poste de travail ou à la tâche à exécuter

Il est clair que certains facteurs de condition de travail ou d’exposition au froid peuvent augmenter les risques. On pointera principalement :

- la prolongation de la durée d’exposition en continu au froid;

- L’absence de salle de repos chauffée;

- Exécution d’une tâche à des cadences ou d’un travail physique intense ou moyen mettant le sujet exposé en transpiration. La peau humide est plus sensible au froid et des vêtements humides sont inconfortables et isolent mal du froid;

- L’insuffisance des poses de récupération;

- Le port de vêtements non adapté au froid, ou ne procurant pas un niveau d’isolation thermique suffisant.

- La possibilité de contact direct de la peau nue avec des surfaces métalliques froides à des températures inférieures à -7 °C;

- L’utilisation de gants peu adaptés à la tâche à réaliser sachant que des gants épais réduisent la dextérité et augmentent l’effort à fournir.

Facteurs individuels

En général, la réaction au froid varie d’un individu à l’autre. Cependant, certaines caractéristiques individuelles contribuent à majorer les conséquences d’une exposition au froid comme :

- l’age : les personnes âgées sont plus sensibles;

- le sexe : la vitesse de refroidissement des pieds et des mains chez la femme (égalité avez-vous dit ?);

- la morphologie : rapport entre la surface de peau et le volume du corps;

- la condition physique : les personnes en bonne santé supportent mieux la sensation de froid;

- la présence de trouble de la circulation;

- la fatigue;

- les apports alimentaires et liquides insuffisants (contribuant à la production de chaleur par l’organisme et limitant la déshydratation).

Certains facteurs de risque peuvent favoriser la survenue de symptômes liés au froid comme par exemple :

- les médicaments comme l’insuline peuvent être responsable d’hypothermie;

- l’alcool est un vasodilatateur qui accroît la perte de chaleur du corps, réduit la régulation thermique interne et modifie le métabolisme du sucre dans le sang;

- lors de la grossesse, la femme est plus vulnérable;

- …

Acclimatation au froid

En fait, il n’y a pas vraiment d’acclimatation au froid. Cependant, certaines parties du corps comme les mains peuvent développer une certaine résistance au froid (cas des bouchers qui peuvent sans problème couper de la viande froide sans gants).

Conclusion

La conservation des denrées alimentaires fixant les températures qu’il doit régner dans les enceintes froides, impose au personnel de s’habiller en conséquence. Le temps de travail doit être aussi adapté sous peine de voir le risque d’accident augmenter et l’efficacité du travail diminuer rapidement.

Comment évaluer sa situation ?

Confort en ambiance froide

L’évaluation du confort dans des ambiances froides se révèle beaucoup plus difficile que dans les zones des commerces qui sont à température ambiante classique (de l’ordre de 20 °C). En effet, la plupart des études sur le confort se cantonnent dans des valeurs de température au dessus de 15 °C. Or les températures que l’on rencontre dans les commerces au niveau de la chaîne de froid alimentaire se trouvent plutôt dans la fourchette de – 20 °C à 12 °C avec comme cas particulier les températures comprises entre 10 et 12 °C pour des conditions de travail prolongé.

La notion du confort peut être exprimée par l’équilibre thermique du corps. En effet, placé dans une ambiance thermique froide le corps humain perd de sa chaleur. Si la production de la chaleur liée au métabolisme est égale aux pertes de chaleur à travers les vêtements et les extrémités non protégées, le bilan thermique est nul et l’occupant est en équilibre thermique.

L’évaluation du confort passe donc par l’élaboration d’une méthode de quantification de l’équilibre thermique du corps humain en fonction des contraintes externes et de l’habillement.

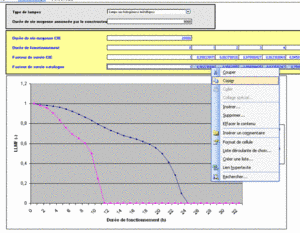

Indices d’isolation vestimentaire

Vu la nécessité de se vêtir correctement dans les ambiances froides, la notion de confort et de sécurité passe par un indice intéressant qui a été introduit dans un document de travail ISO (ISO/TR 11 079) portant sur l’évaluation des ambiances thermiques froides; c’est l’indice d’isolation vestimentaire IREQ (Required Clothing Insulation Index). Il permet de choisir des vêtements adaptés au froid en assurant au corps un bon équilibre thermique. Il est admis que cet indice doit être utilisé lorsque la température est inférieure à 10 °C.

Le port d’un vêtement dont l’isolement est inférieur à l’indice IREQ requis, implique qu’une durée d’exposition limite doit être calculée (DLE). Il en résulte que si la durée d’exposition est inférieure à la durée DLE calculée, il n’y a pas de risque d’hypothermie. Pour les travailleurs en chambre froide, l’indice IREQ est en général compris entre 2,5 et 4 [clo]. Actuellement, les meilleurs vêtements de protection contre le froid offrent une isolation thermique comprise entre 3 et 4 [clo].

Clo : c’est l’unité d’isolement thermique où 1 [clo] correspond à 1,155 [K.m²/W].

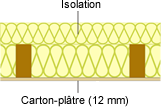

Pratiquement parlant, il est admis que plusieurs couches de vêtements valent mieux qu’un seul vêtement épais.

| Exemple

Une tenue vestimentaire composée :

permet d’atteindre un IREQ de l’ordre de 2,6. Attention que la couche la plus proche de la peau doit être isolante et éloigner l’humidité de la peau afin de la maintenir sèche. |

Attention qu’il ne faut pas oublier, lors d’un travail en ambiance froide, qu’il est nécessaire d’adapter l’isolement vestimentaire à la pénibilité de la charge de travail. Ainsi, la valeur de l’indice IREQ peut être réduite de l’ordre de :

- 10 % pour un travail léger;

- 20 % pour les travaux plus intenses.

Contrainte ou astreinte thermique

Les conditions climatiques de l’ambiance froide sont évaluées en mesurant différents paramètres physiques :

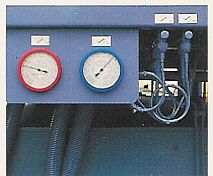

- la température de l’air avec un thermomètre. Les équipements faisant partie de la chaîne de froid (chambre froide, chambre climatisée, meuble frigorifique ouvert, …) sont souvent équipés de leur propre thermomètre ou même un enregistreur de température. L’évaluation n’est donc pas difficile en soi;

- la température de rayonnement avec par exemple un thermomètre de contact pour la température de paroi;

- l’humidité avec un hygromètre;

- la vitesse de l’air avec un anémomètre.

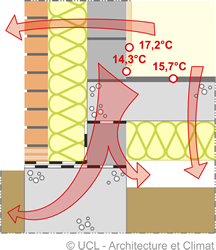

Une bonne image du confort thermique est donnée par la température opérative, moyenne arithmétique entre la température de l’air et la température des parois.

Topérative = (Tair + Tparois) / 2

- La mesure de la température de l’air se fait à l’aide d’un thermomètre protégé du rayonnement solaire et du rayonnement des parois du local.

- La température de surface d’une paroi se fait à l’aide d’une sonde de contact ou sonde à rayonnement infrarouge.

Malheureusement, la température de rayonnement des parois est celle ressentie par l’occupant à l’endroit où il se trouve. Elle doit en principe être « individualisée » sur base de la position de l’occupant et de sa relation avec l’ensemble des parois. Mais ne soyons pas plus catholiques que le pape.

Dépense énergétique

Pour produire 1 [Joule] de travail, l’organisme en produit entre 5 et 90 Joules de chaleur. Dans les ambiances froides, l’activité physique « protège » le corps humain en brûlant de l’énergie fournie entre autres par l’alimentation. À titre indicatif, la norme ISO 8996 [32] détaille les différentes méthodes d’évaluation de la dépense énergétique.

Température corporelle : température cutanée du dos de la main

Le travail prolongé au niveau de la chaîne alimentaire nécessite que l’on adapte les conditions de travail pour maintenir un confort relatif et surtout une sécurité optimale des occupants.

Dans des températures habituelles de travail, le refroidissement corporel et le risque d’hypothermie sont faibles. Il n’en est pas de même pour le refroidissement des extrémités. Dans la plupart des cas de condition d’ambiance froide dans le secteur des commerces, la température de peau des extrémités du corps constitue une bonne évaluation de l’impact des basses températures sur le confort et la sécurité. Plus particulièrement, la mesure de la température cutanée du dos de la main représente un critère de dextérité conservée.

En général, on associe la température du dos de la main à une durée d’exposition.

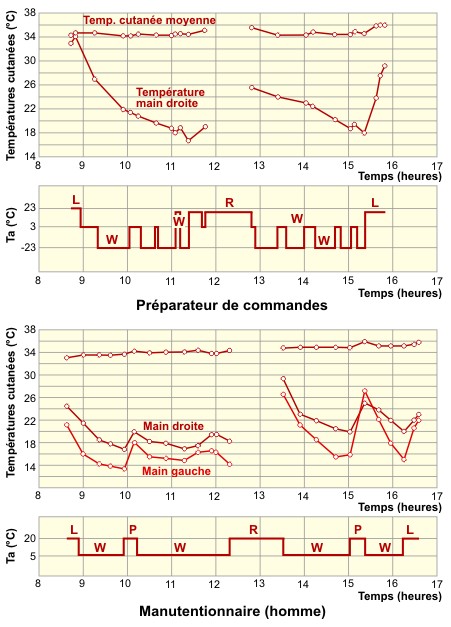

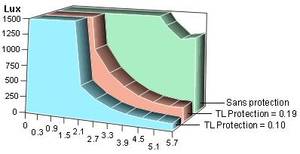

| L’INRS (Institut National de Recherche Scientifique : M. Aptel, Le travail au froid artificiel dans l’industrie alimentaire : description des astreintes et des recommandations, Cahier des notes documentaires n°126, 1er trimestre 1987) a montré l’influence de la température cutanée du dos de la main, du temps d’exposition au froid et de la répartition des alternances chaud/froid sur la dextérité des mains.

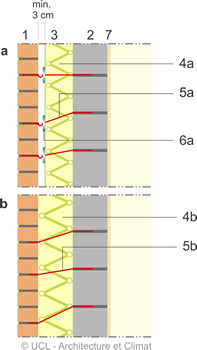

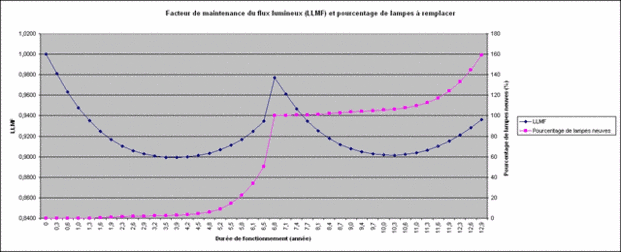

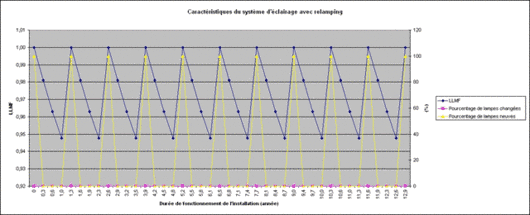

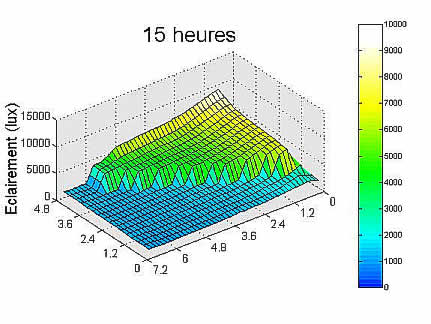

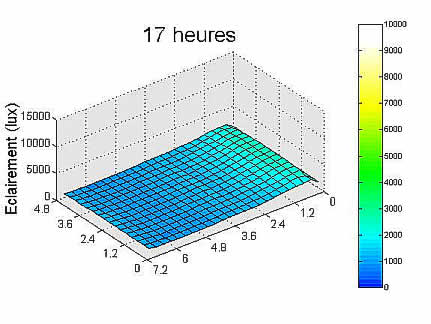

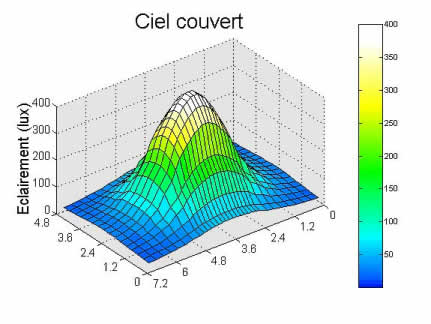

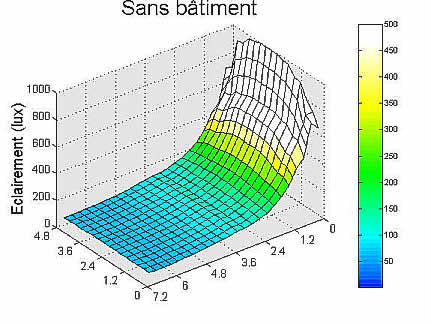

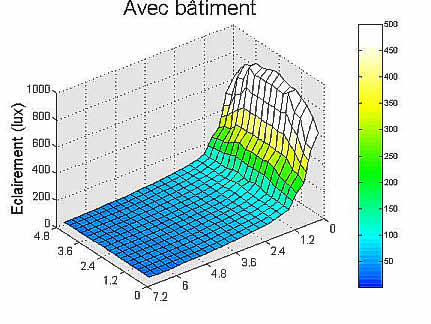

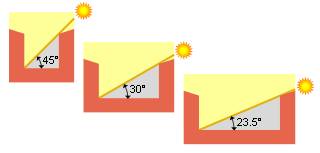

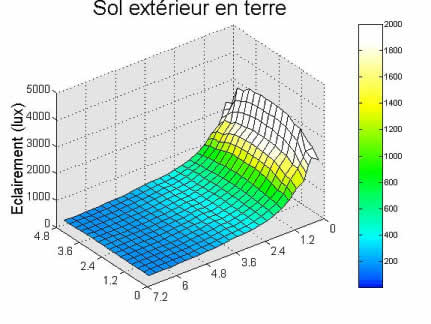

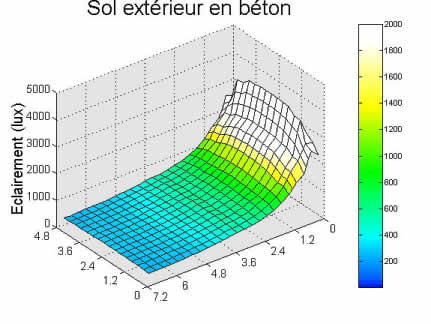

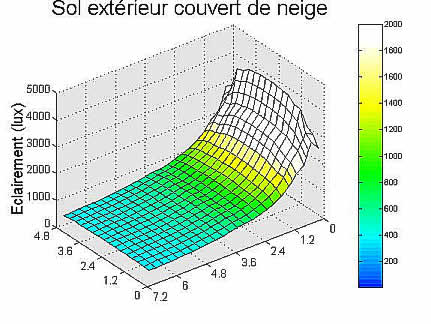

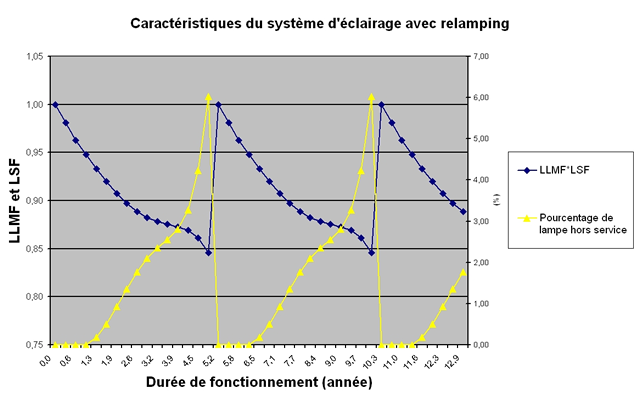

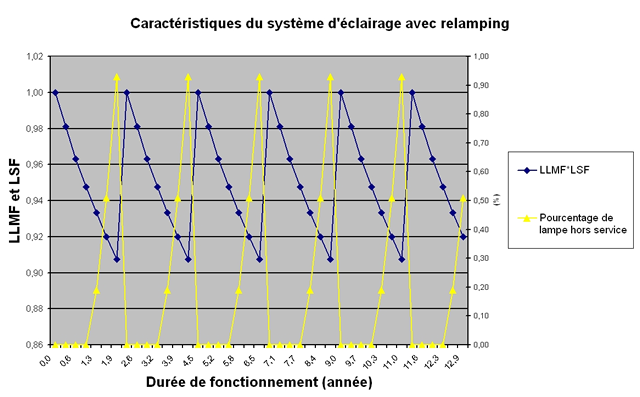

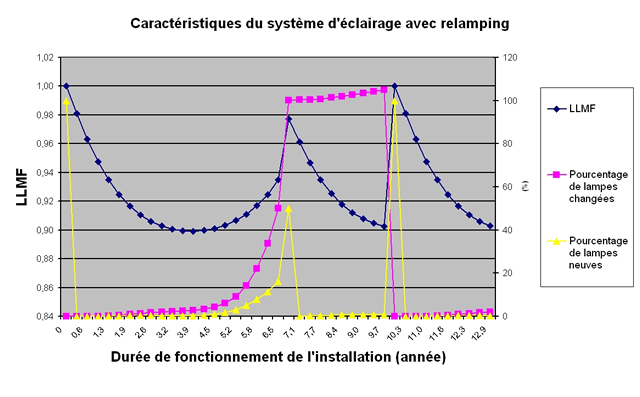

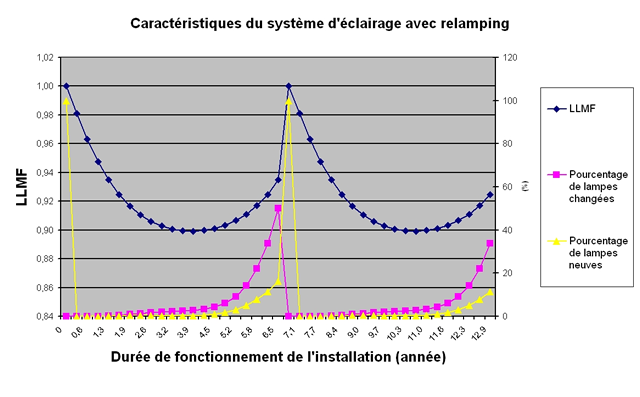

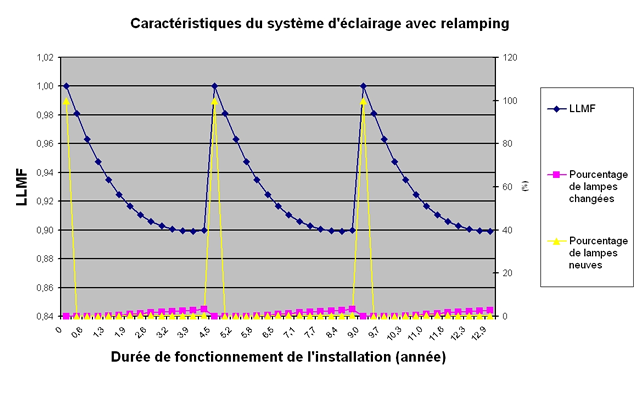

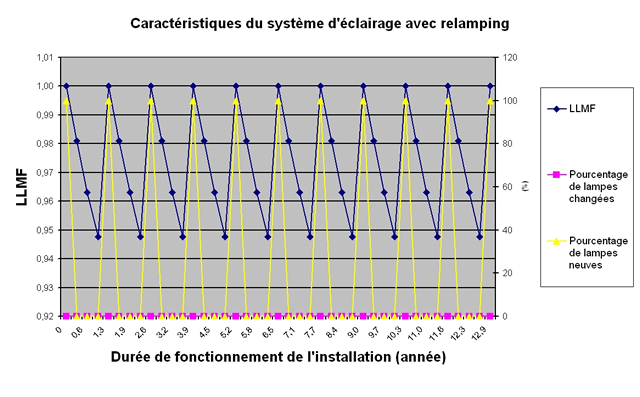

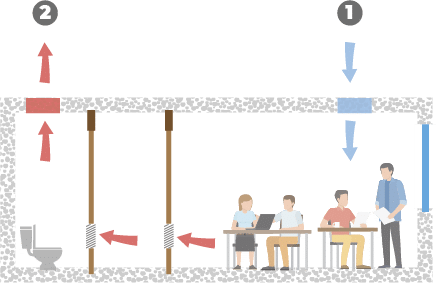

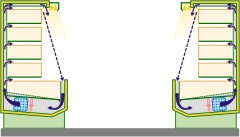

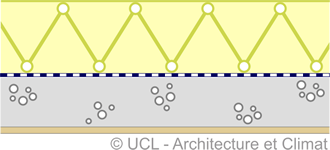

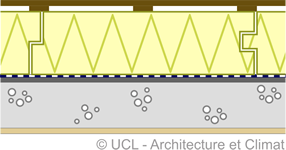

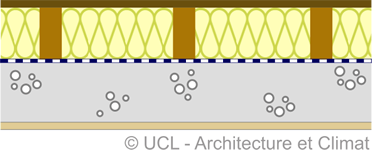

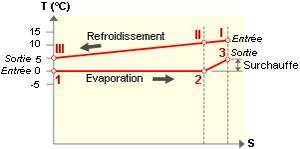

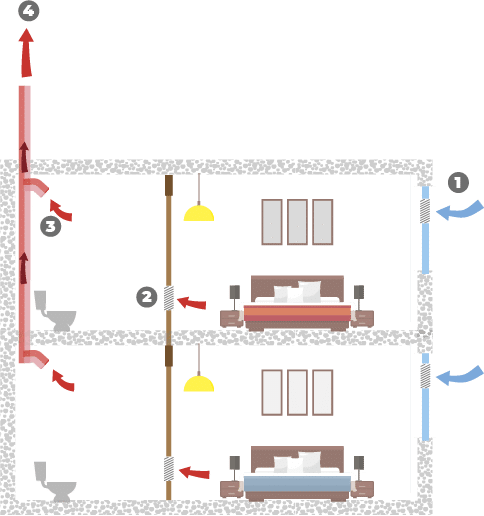

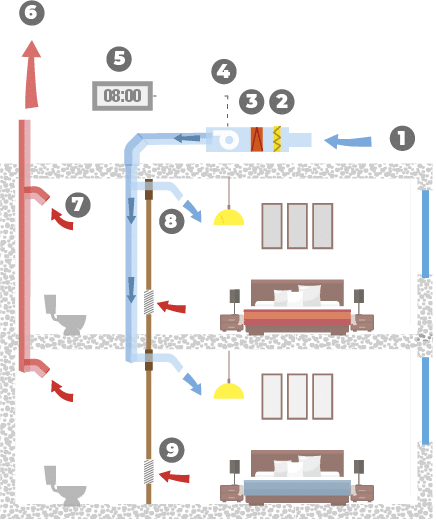

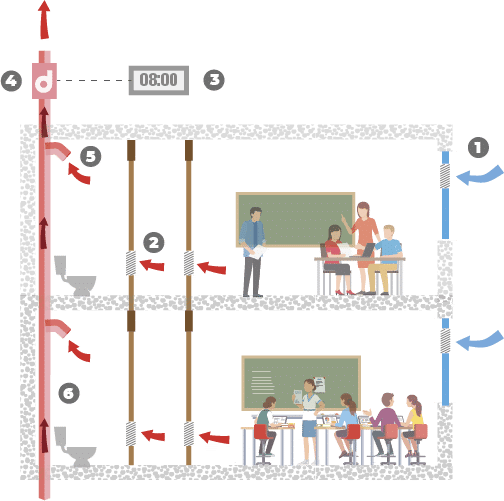

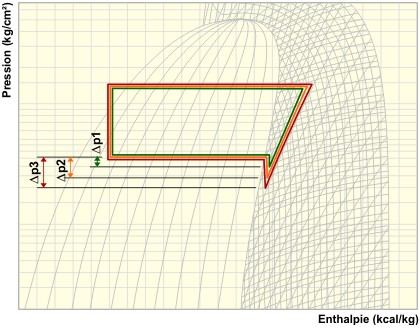

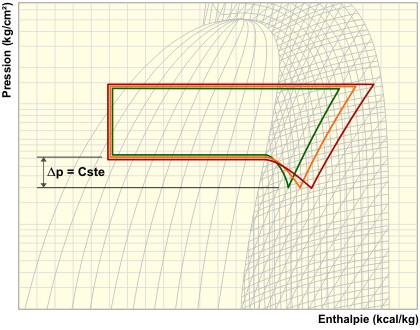

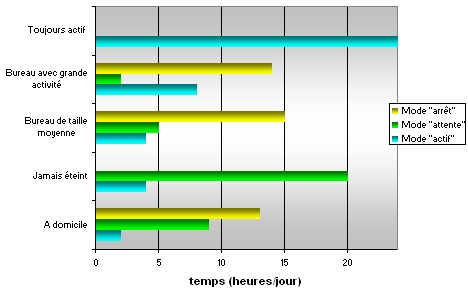

Les schémas ci-dessous montrent l’évolution de la contrainte thermique cutanée en fonction des répartitions des périodes d’exposition au froid au cours d’une journée de travail entre chambre froide (- 23°C) et en chambre climatisée (5°C).

Les expériences menées à l’INRS ont montré plusieurs choses :

|

La mesure de la température cutanée du dos de la main est la méthode qui semble la plus intéressante pour les conditions de travail en ambiance froide, mais elle ne constitue pas un indice permettant de prévoir le refroidissement des travailleurs à partir des mesures des paramètres physiques des conditions climatiques des zones froides. Cependant, cet indicateur est le plus facilement exploitable car :

- spontanément les occupants adaptent leur tenue vestimentaire en fonction de la sévérité des conditions d’ambiance; ce qui simplifie l’évaluation de l’impact du froid sur la personne;

- lorsque la température cutanée de la main descend sous 23-24 °C , la dextérité diminue;

- la perception du refroidissement des extrémités varie d’un individu à l’autre. Seul un indicateur d’astreinte peut la prendre en compte;

- enfin, il peut être mesuré facilement.

Recommandations, normes et règlements

Les recommandations et normes se concentrent essentiellement sur la protection des travailleurs exposés au froid. La notion de confort est moins perceptible par rapport à la sécurité, mais est néanmoins bien présente puisqu’elle influence l’efficacité du travail et, par conséquent, le bien-être et la sécurité.

Les vêtements de protection

Les vêtements de protection contre le froid sont considérés comme des équipements de protection individuelle (EPI).

Les vêtements contre le froid offrent une barrière entre la peau et le milieu ambiant, modifiant aussi bien les échanges de chaleur convectifs et radiatifs, que ceux par évaporation. Il se crée autour de la peau couverte, un microclimat caractérisé par une température d’air et par une pression partielle de vapeur d’eau. La température de rayonnement caractéristique du microclimat est celle de la face interne du vêtement. L’influence du vêtement sur les échanges de chaleur, comme on l’a vu ci-dessus est très complexe.

Le port d’un vêtement de protection freine les échanges thermiques, ce qui est bénéfique en ambiance froide.

Classes des vêtements de protection

La majorité des vêtements contre le froid appartiennent à la classe II. Mais les vêtements, les accessoires (détachables ou non) et tous les équipements destinés à la protection de tout ou d’une partie du visage, du pied, de la jambe, de la main, du bras et conçus pour permettre l’intervention dans les ambiances froides dont les effets sont comparables à ceux d’une température d’air inférieure ou égale à -50°C appartiennent à la classe III. Quant aux vêtements et aux accessoires (détachables ou non) qui sont conçus pour protéger contre les conditions atmosphériques qui ne sont ni exceptionnelles ni extrêmes et à usage professionnel, ils appartiennent à la classe I.

La norme EN 511

La norme EN 511 définit les exigences et les méthodes d’essai des gants de protection contre le froid, d’origine climatique ou artificielle, transmis par convection ou par conduction jusqu’à -50 °C.

Les principaux sujets traités sont repris dans le tableau suivant :

| Sujet | Définition |

| Froid convectif |

TR [°C.m²/W] représente la résistance à la perte de chaleur sèche de la main.

|

| Niveau d’isolement thermique |

R en m² °C/W) |

| Froid de contact |

est fondée sur la résistance thermique du matériau composant le gant lorsqu’il est en contact avec un objet froid

|

| Imperméabilité à l’eau |

facteur de pénétration du gant par l’eau

|

La norme prEN 342

Le prEN 342 spécifie les exigences et les méthodes d’essais de performance des vêtements de protection contre le froid à des températures inférieures à -5 °C.

L’isolation thermique du vêtement de protection est évaluée en combinaison avec les sous-vêtements standards :

- maillot à manches longues;

- caleçons longs;

- chaussettes;

- pantoufles en feutre;

- gilet isolant;

- caleçons isolants;

- gants tricotés;

- passe-montagne.

L’isolation thermique d’un ensemble de vêtements (vêtements de protection et sous-vêtements) est classée en fonction de la valeur de l’isolation de base résultante mesurée (Iclr).

La performance d’un ensemble vestimentaire, en termes de maintien de l’équilibre thermique du corps à la température normale, dépend de la production de chaleur métabolique interne. C’est pourquoi la valeur de protection d’un ensemble vestimentaire est évaluée en comparant sa valeur d’isolation mesurée et la valeur d’isolation requise calculée (IREQ) comme montré dans le tableau ci-dessous :

| Icl. r. |

Activité

|

||||||

| très légère : 90 W/m² | légère : 115 W/m² | modérée 170 W/m² | |||||

| temps d’exposition [heures] | |||||||

| [m².°C/W] | clo |

8

|

1

|

8

|

1 |

8

|

1 |

|

0,15

|

1,0

|

–

|

–

|

–

|

-3

|

3

|

-5

|

|

0,23

|

1,5

|

–

|

4

|

8

|

-13

|

-7

|

-18

|

|

0,31

|

2,0

|

10

|

-4

|

1

|

-23

|

-18

|

-31

|

|

0,38

|

2,5

|

4

|

-12

|

-6

|

-33

|

-29

|

-44

|

|

0,46

|

3,0

|

-1

|

-21

|

-13

|

-43

|

-39

|

-57

|

|

0,54

|

3,5

|

-7

|

-30

|

-20

|

-53

|

-49

|

-70

|

|

0,62

|

4,0

|

-13

|

-39

|

-28

|

-63

|

-60

|

–

|

|

0,70

|

4,5

|

-19

|

-48

|

-35

|

–

|

–

|

–

|

- Les valeurs Icl. r. sont seulement valables avec des gants, chaussures et couvre-chef adéquats et une vitesse d’air compris entre 0,3 m/s et 0,5 m/s;

- Des vitesses d’air plus élevées augmenteront les températures indiquées dans le tableau à cause de l’effet de refroidissement par le vent (WCI). Un niveau adapté de l’isolation de tout le corps peut ne pas être suffisant pour éviter le refroidissement des parties sensibles du corps (par exemple les mains, les pieds, le visage) et le risque concomitant de gelures.

Le projet de norme ISO/TR 11079

Le projet de norme ISO /TR 11079 Évaluation des ambiances froides – Détermination de l’isolement requis des vêtements (IREQ) décrit la procédure d’évaluation des ambiances froides et de détermination de l’isolement requis des vêtements à mettre à la disposition des travailleurs.

Par ailleurs, en ce qui concerne les autres vêtements de protection contre le froid, les chaussures de protection utilisées dans les enceintes froides, en plus des protections générales contre les chutes d’objets, les coupures, l’humidité, …, doivent également assurer une isolation contre le froid (indiquée par le symbole CL).

Quant aux sous-vêtements isolants, ils sont également soumis au marquage CE.

Pour plus d’informations : Le travail dans le froid artificiel, Ministère fédéral de l’Emploi et du Travail, 1998, 35 p.

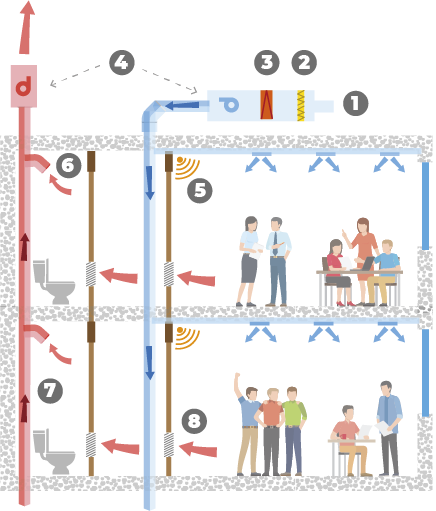

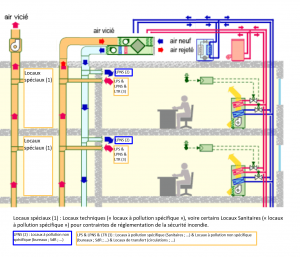

L’inconfort des bouches de pulsion d’air

Zone tempérée

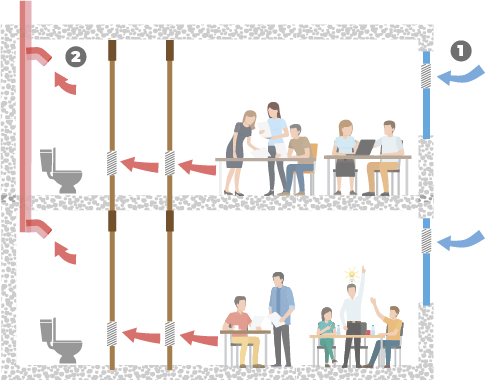

En climatisation classique, la source d’inconfort est principalement liée :

- à l’emplacement de la bouche dans le local considéré;

- la température de pulsion;

- le débit de pulsion;

- …

Lorsque l’air pulsé entre dans la zone d’occupation du local et que la différence de température entre cet air et l’air ambiant dépasse encore 1°C en pulsion froide, on risque de ressentir une sensation de « masse d’air » lorsque l’on se déplace dans le local.

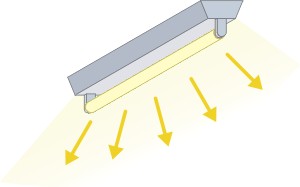

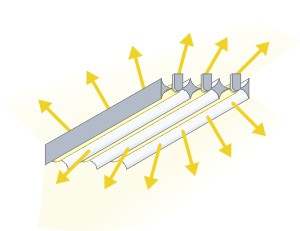

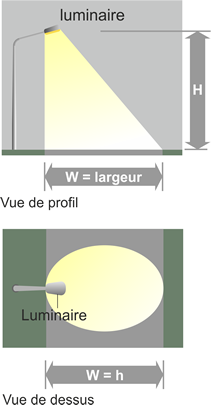

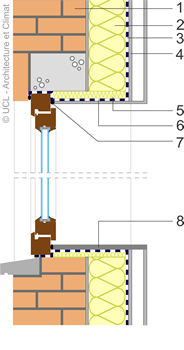

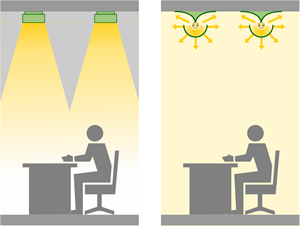

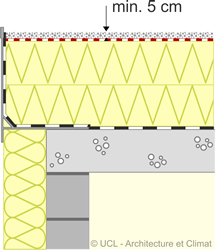

La zone d’occupation est souvent représentée par la surface du local de laquelle on a soustrait une bande de 50 cm le long des murs intérieurs et de 1 m le long des murs extérieurs, et ce sur une hauteur de 1,8 m. Dans cette zone, la vitesse de l’air ne peut dépasser 0,2 m/s (0,28 dans les locaux de passage) et le long des murs, à 1,8 m, elle ne peut dépasser 0,4 m/s :

L’inconfort éventuel est lié au choix des bouches de pulsion ou à la température de pulsion :

- diffuseurs trop proches l’un de l’autre entraînant une retombée rapide du jet d’air vers le sol, avant son brassage correct avec l’air ambiant,

- diffuseurs ne présentant pas assez d’induction par rapport à la hauteur du local (pas assez de brassage avec l’air ambiant),

- différence entre la température de consigne de l’air pulsé et la température ambiante trop grande.

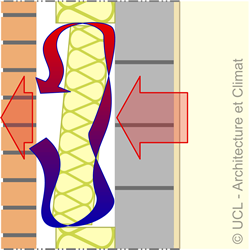

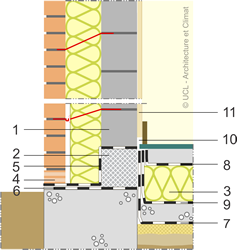

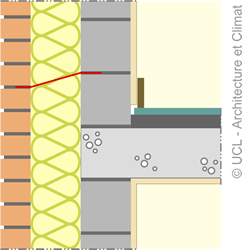

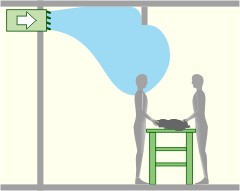

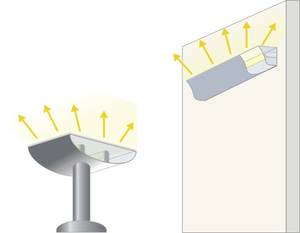

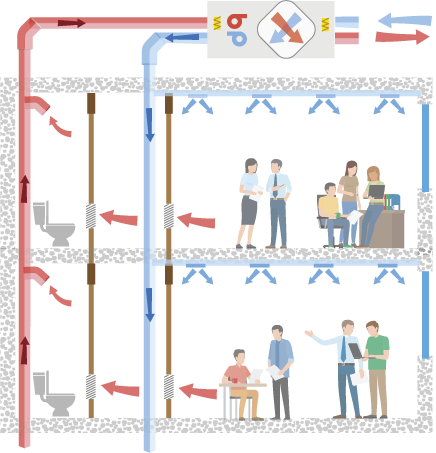

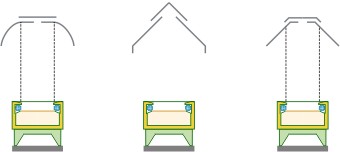

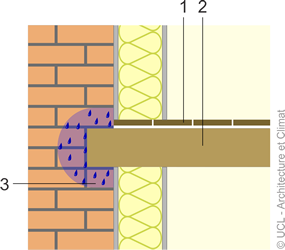

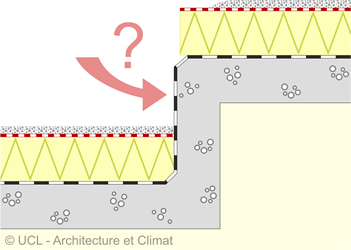

Inconfort par effet Coanda rompu

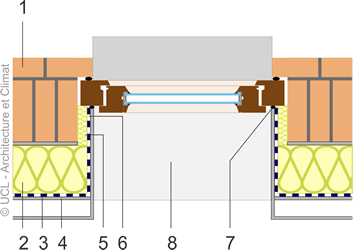

Lorsque l’air est soufflé à proximité d’une surface (ex : soufflage horizontal à proximité du plafond), il se produit un effet d’adhérence du jet à la paroi : c’est l’effet « COANDA ».

L’effet Coanda est très utile quand on pulse de l’air froid, car il facilite la bonne pénétration du jet dans le local (augmentation de 30 % de la portée).

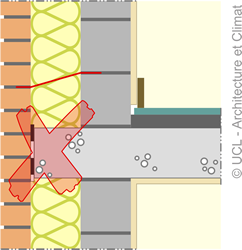

Problème 1

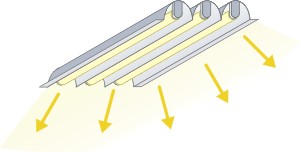

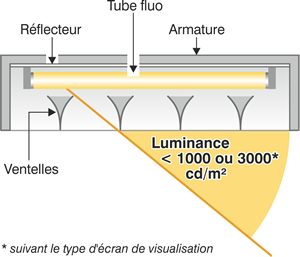

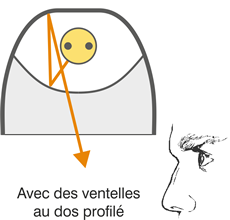

La présence d’un obstacle perpendiculaire au jet d’air (poutre, luminaire) peut faire dévier prématurément le jet vers la zone occupée et engendrer un courant d’air désagréable.

En conséquence :

- Il faut souffler soit à partir de l’obstacle, soit parallèlement à celui-ci et diviser le local en zones correspondantes.

- L’éclairage au plafond doit être soit encastré, soit suspendu avec une longueur de suspension de 0,3 m minimum.

- On tiendra compte de la présence éventuelle de colonnes qui ne pourront se situer dans la trajectoire du jet.

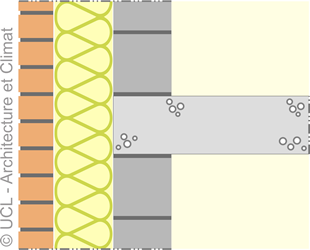

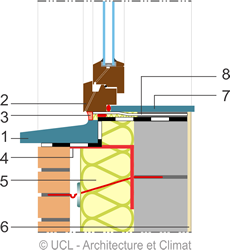

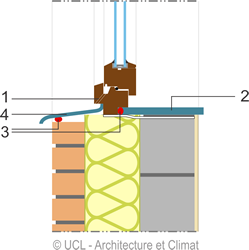

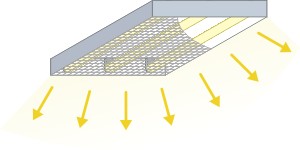

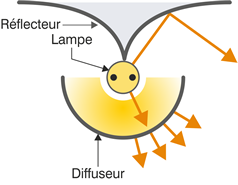

Problème 2

Lorsqu’une bouche plafonnière pulsant de l’air froid est surdimensionnée, la vitesse de sortie de l’air risque d’être trop faible (< 2 m/s) pour créer un effet Coanda. Le jet d’air tombera alors directement vers le sol, risquant de provoquer un courant d’air froid sous la bouche. Paradoxalement, pour éviter le courant d’air, il faudra augmenter la vitesse de l’air en réduisant la taille du diffuseur.

Problème 3

Les diffuseurs utilisent dans les systèmes de climatisation à débit d’air variable (VAV ou climatiseurs à plusieurs vitesses) doivent être spécifiquement dimensionnés pour conserver l’effet Coanda même aux faibles débits.

| Pour plus d’infos : choix des bouches de pulsion et d’extraction en climatisation. |

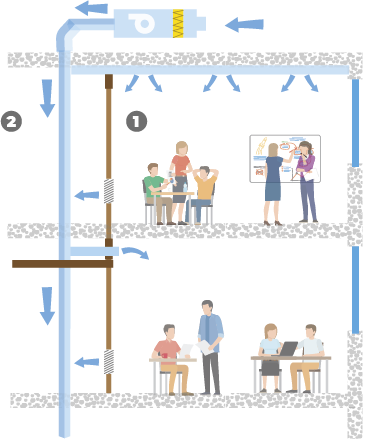

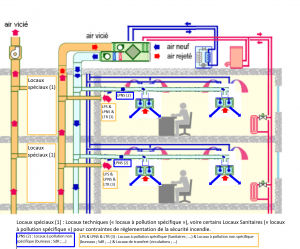

Zone de froid alimentaire

Dans les zones où il est nécessaire de maintenir des températures de conservation de l’ordre de quelques degrés au dessus de 0 °C en application positive voire franchement sous les 0 °C en froid négatif (congélation), outre l’inconfort dû à la température, les débits d’air sont souvent importants; l’inconfort est par conséquent accru.

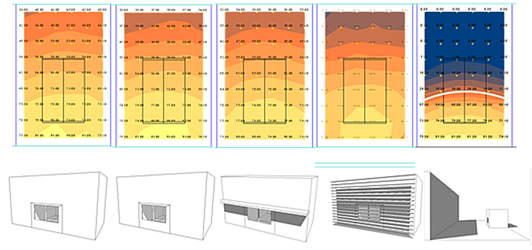

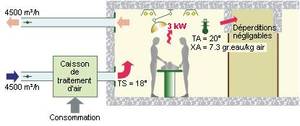

Pour les zones de travail telles que les ateliers de boucherie, par exemple, l’évaluation de l’inconfort dû aux bouches de pulsion se complexifie de par l’augmentation des débits d’air pour atteindre des températures de l’ordre de 12 °C. La limitation des vitesses de déplacement d’air plus froid doit être inférieure à 0,4 m/s.

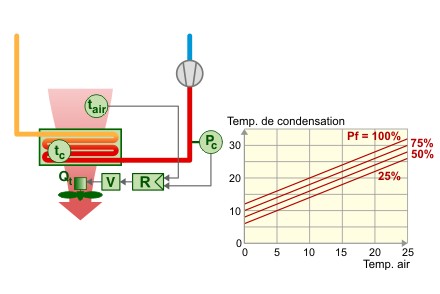

Attention que plus l’air est froid moins l’effet « COANDA » est présent vu que la densité de l’air augmente et nécessairement l’alourdit.

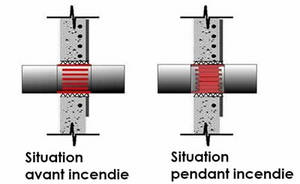

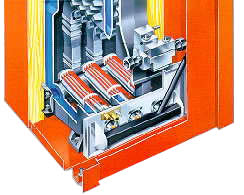

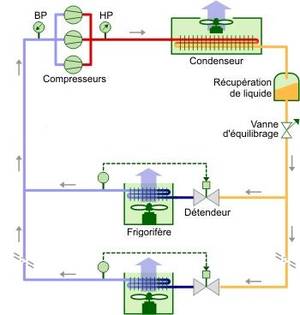

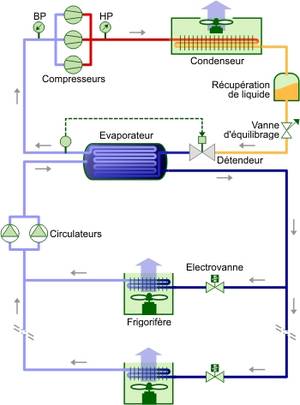

Cas particulier des chambres froides

Les chambres froides sont des locaux de stockage dans les commerces. L’ambiance à l’intérieur des chambres est refroidie dans une gamme de températures classiques variant de -30 à +4 °C. Nécessairement, l’inconfort règne et exige que les travailleurs y pénétrant soit habillés de manière appropriée. En général, c’est le genre de local où l’on s’attarde peu.

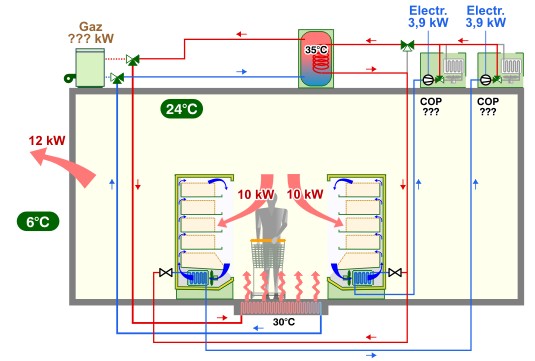

Cas particulier des ateliers

Les zones climatisées sont les espaces où l’on procède à la transformation des produits (préparation de sous-produits du poulet pour le traiteur par exemple). Les ateliers de boucherie, de poissonnerie, … sont les plus couramment rencontrés au niveau des commerces que ce soit de détail ou en grande surface. Les ateliers ne sont qu’une étape de transformation des produits qui interviennent entre le stockage et la distribution et se caractérisent par la nécessité de maintenir les températures de la chaîne du froid en dessous de 12 °C. De plus, ces zones climatisées, contrairement à la chambre de stockage, abritent une activité humaine importante et souvent longue.

L’évaluation du confort pour ces zones est donc primordiale et nécessite de déterminer, en fonction principalement de la température ambiante et de la vitesse de l’air :

-

le type d’habillement;

-

le temps de travail des personnes exposées;

-

leur temps de pose entre leurs périodes de travail.

Une attention toute particulière sera prise par rapport à la vitesse de l’air dans ces zones qui peut générer très vite un inconfort au niveau des extrémités découvertes du corps (la tête et les mains par exemple).

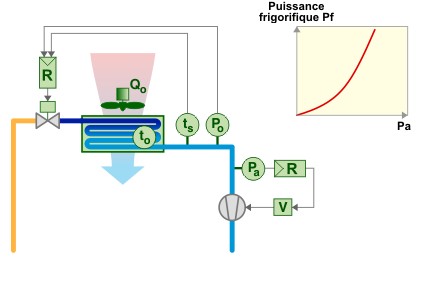

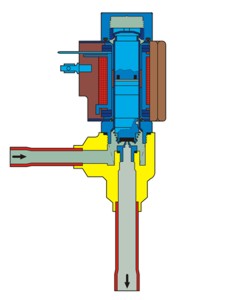

Afin de créer le froid nécessaire, des ventilo convecteurs sont couramment utilisés. Ils ont des débits importants qui peuvent induire, s’ils sont mal positionnés, des vitesses d’air supérieures à 0,2 m/s à 1,8 m de hauteur par rapport au sol. Une manière d’évaluer la vitesse de l’air est d’utiliser un anémomètre en différents endroits du local dans différentes directions notamment au niveau des postes de travail.

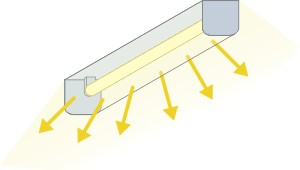

À noter d’emblée que les manchettes ou chaussettes, … à air sont des moyens de diffuser des débits d’air froid importants en garantissant des vitesses d’air faibles tout assurant les températures voulues.

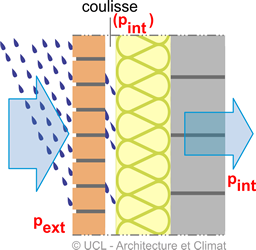

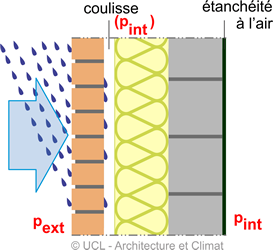

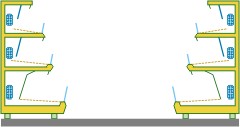

Cas particulier des allées froides

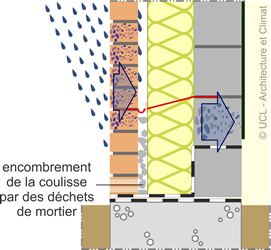

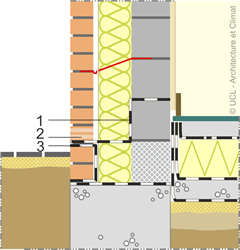

Marché oblige, les meubles frigorifiques ouverts, et principalement les meubles frigorifiques verticaux « MFV », sont de plus en plus nombreux dans les commerces. Dans un souci commercial et énergétique, ces meubles sont régulièrement placés en vis à vis créant ainsi des « allées froides » totalement inconfortables au point que les responsables techniques sont tentés de réchauffer par n’importe quel moyen le centre des allées. L’évaluation du problème s’effectue au moyen d’un thermomètre et d’un hygromètre en différents endroits de l’allée.

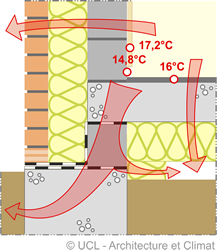

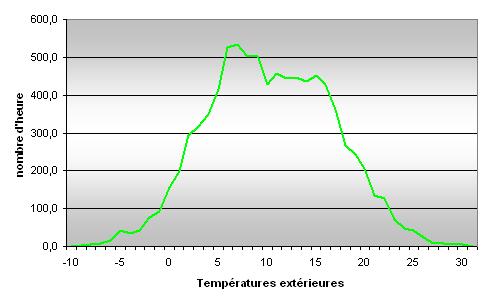

Des mesures de température et d’humidité ont été réalisées dans plusieurs commerces de grande surface. En moyenne, les températures relevées ne dépassaient pas les 16 °C avec une humidité relative de l’ordre de 35 %.

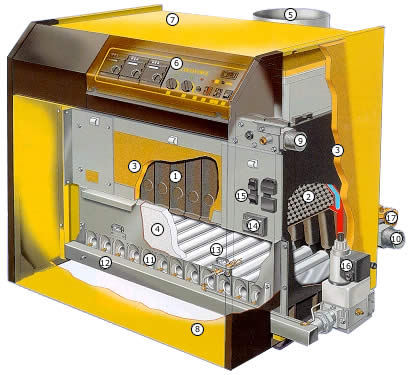

![Circulateurs [ECS] Circulateurs [ECS]](https://energieplus-lesite.be/wp-content/uploads/2019/03/RTEmagicC_circulateurss1.jpg.jpg)

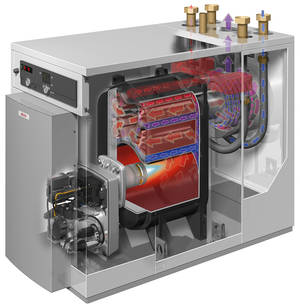

![Chaudières à condensation [ECS] Chaudières à condensation [ECS]](https://energieplus-lesite.be/wp-content/uploads/2019/03/RTEmagicC_Condensation.jpg.jpg)

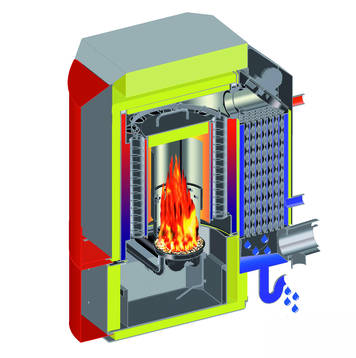

![Chaudières traditionnelles [ECS] Chaudières traditionnelles [ECS]](https://energieplus-lesite.be/wp-content/uploads/2007/09/chaudiere-2-bon-800x533.jpg)

![Choisir entre les différentes caractéristiques influençant le programme de maintenance [Eclairage] Choisir entre les différentes caractéristiques influençant le programme de maintenance [Eclairage]](https://energieplus-lesite.be/wp-content/uploads/2007/10/eclairage-maintenance-bon-800x420.jpg)

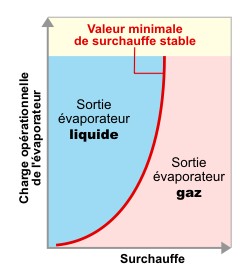

![Détendeurs [Climatisation] Détendeurs [Climatisation]](https://energieplus-lesite.be/wp-content/uploads/2019/03/detendeur.gif)

![Détendeurs [Froid alimentaire] Détendeurs [Froid alimentaire]](https://energieplus-lesite.be/wp-content/uploads/2019/03/RTEmagicC_detendeur.gif.gif)

![Diminuer le niveau sonore [Climatisation] Diminuer le niveau sonore [Climatisation]](https://energieplus-lesite.be/wp-content/uploads/2007/09/bene046-800x346.jpg)

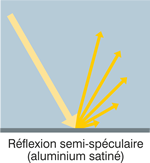

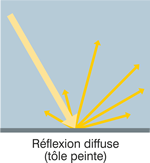

![Evaluer la qualité des parois [éclairage] Evaluer la qualité des parois [éclairage]](https://energieplus-lesite.be/wp-content/uploads/2007/09/bureaux-coefficient-reflexion-parois-bon-1024x538.jpg)

T est élevé, plus il faudra assurer un débit surfacique faible.

T est élevé, plus il faudra assurer un débit surfacique faible.

l’étanchéité à l’eau,

l’étanchéité à l’eau,