Voici une liste (non exhaustive) d’outils permettant la simulation de l’éclairage à l’intérieur d’un local :

DAYSIM

DAYSIM est un software d’analyse de l’éclairage naturel basé sur le logiciel RADIANCE qui modélise la quantité annuelle d’éclairage dans et autour des bâtiments. DAYSIM permet la modélisation de systèmes de façade statiques et dynamiques. L’utilisateur peut spécifier un système de contrôle de l’éclairage électrique du type d’un interrupteur on/off manuel, un détecteur de présence ou une cellule de gradation de la lumière en fonction des disponibilités de lumière naturelle.

DAYSIM est utilisé par les concepteurs, les architectes et les ingénieurs. Cependant, comme DAYSIM est basé sur RADIANCE, une connaissance minimale de RADIANCE est nécessaire de manière à choisir correctement les paramètres de simulations.

Les résultats de simulation sont les métriques dynamiques basées sur le climat telles que l’autonomie dynamique et l’UDI (Useful Daylight Illuminance), l’éblouissement annuel ainsi que les consommations annuelles d’éclairage électrique, sur base de la puissance électrique installée. DAYSIM permet aussi une définition des horaires d’occupation, des charges internes et du statut des protections solaires qui peuvent être couplées directement avec des engins de simulation thermique tels qu’EnergyPlus, eQuest et TRNSYS.

Daysim ne fournit aucun outil de rendu.

DIALUX

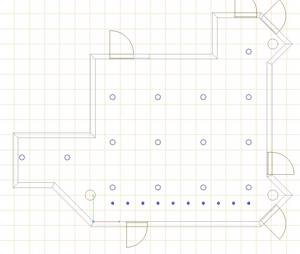

DIALUX permet de calculer l’éclairement naturel, pour trois types de ciel, parmi lequel le ciel couvert CIE.

DIALUX peut être utilisé à toutes les étapes du projet mais comme il n’inclut qu’un outil de modélisation géométrique simple, il est mieux adapté au stade de l’avant-projet. DIALUX est principalement dédié aux concepteurs d’éclairage mais peut être également utilisé par des architectes.

Le modèle géométrique est réalisé dans le software mais on peut importer des fichiers .dwg ou .dxf pour servir de base au dessin.

Site internet de référence : www.dial.de

DIALUX Evo

DIALUX Evo est le nouveau software qui a été introduit en parallèle avec le software DIALUX et qui remplacera ce dernier dans le futur. DIALUX Evo est avant tout dédié au bâtiment.

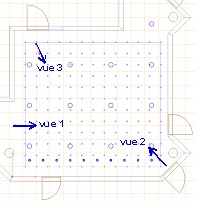

L’utilisateur crée sa géométrie dans un espace virtuel. Ce peut être une simple pièce, un étage entier ou même un bâtiment entier ou plusieurs bâtiments situés dans un contexte urbain. Si un concepteur conçoit l’éclairage pour un bâtiment entier, il peut se positionner n’importe où dans ce bâtiment et voir le résultat de son plan.

DIALUX Evo permet des calculs d’éclairage électrique et d’éclairage naturel. On peut y modéliser un ciel clair, moyen et couvert. Les valeurs d’éclairement ainsi que le facteur de lumière du jour peuvent être calculées.

DIALUX Evo est moins intuitif que DIALUX et est probablement plus destiné aux concepteurs d’éclairage qu’aux architectes.

Site internet de référence : www.dial.de

DIAL+ Lighting

DIAL+ permet de soit lancer des simulations d’éclairage (RADIANCE) ou de calculer les charges de chauffage et de refroidissement à l’échelle d’un local.

Le module permet de produire des rapports qui incluent les résultats suivants :

- Facteurs de lumière du jour

- Autonomie dynamique diffuse (% et heures)

- Autonomie pour Minergie-Éco (Suisse)

- Valeurs d’éclairement en éclairage électrique

- Consommation annuelle d’électricité d’éclairage (SIA 380/4, Minergie)

- Diagramme solaire incluant les obstructions extérieures.

- Etudes d’ombrage (facteur d’ensoleillement, fraction de ciel vu)

- Le module de refroidissement donne accès aux modules suivants : Charges de refroidissement et de chauffage (EN 15251 EN 15255, EN 15265 and ISO 13791, SIA 382/1 SIA 382/2)

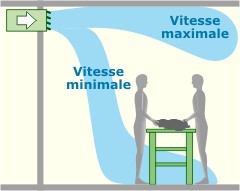

- Débits d’air dus à la ventilation naturelle (Modèle de Cockroft)

Grâce à sa rapidité de simulation et sa simplicité, DIAL+ est particulièrement adapté à la réalisation d’études paramétriques, ce qui est très intéressant au stade de l’avant-projet. DIAL+ permet de prendre des décisions précoces à l’échelle du local et de les appliquer au reste du bâtiment. DIAL+ est une interface très intuitive qui traite de l’optimisation des charges énergétiques, à l’échelle du local.

L’interface a été conçue de manière à permettre à un utilisateur non expert de décrire facilement les paramètres des locaux. Il peut donc être utilisé par des architectes et des ingénieurs. Il est aussi bien adapté à des objectifs pédagogiques. Cependant, l’utilisation de toutes ses caractéristiques (éclairage et thermique) suppose que l’utilisateur a une connaissance minimale du comportement d’un bâtiment.

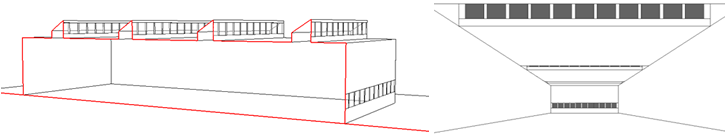

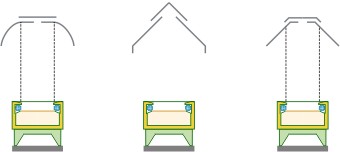

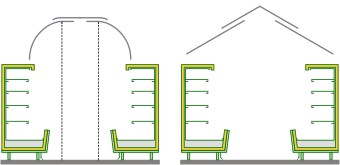

DIAL+ contient un modeler 3D simplifié qui permet de modéliser des locaux rectangulaires, en forme de L ou de trapèzes, ayant un toit plat, à simple ou double versant. Des objets opaques ou transparents peuvent être ajoutés à l’intérieur des locaux traités. Le temps moyen requis pour décrire tous les paramètres d’un local classique est de moins de 10 minutes.

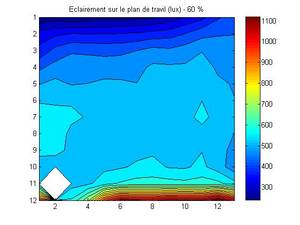

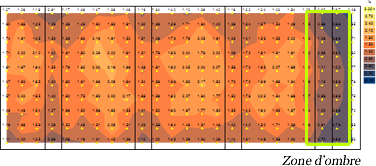

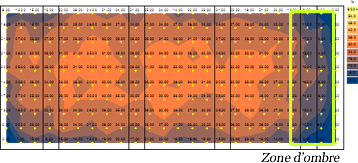

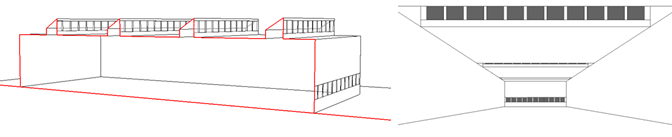

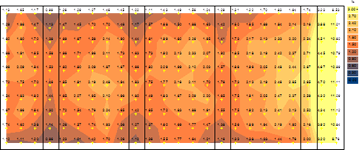

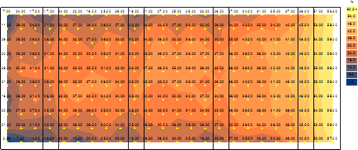

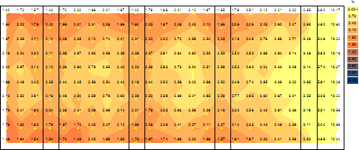

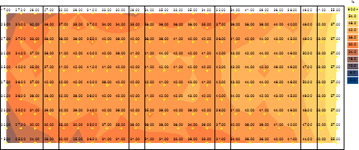

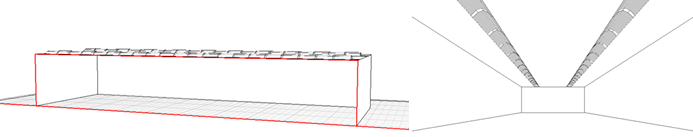

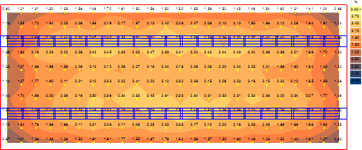

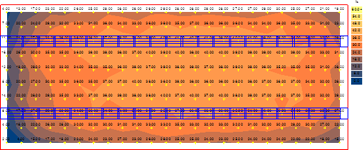

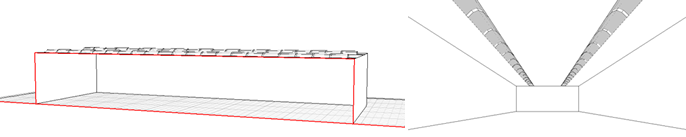

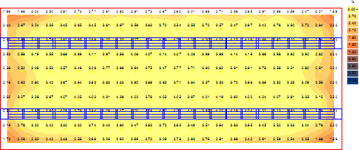

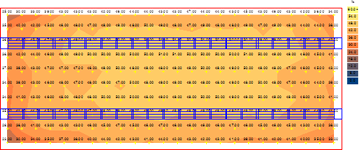

Les résultats de simulation sont affichés sous forme de plans 2D et de graphes (FLJ, autonomie, éclairement, etc.) sur le plan de travail ou sur les murs.

Site internet de référence : www.diaplus.ch

DIVA-for-Rhino

DIVA pour Rhino permet à ses utilisateurs de réaliser une série d’évaluation de performance environnementale de bâtiments individuels ou de paysages urbains incluant des cartes de rayonnement solaire, des rendus photoréalistes, des métriques dynamiques en éclairage naturel, des analyses d’éblouissement ponctuel et annuel ainsi que des analyses des charges thermiques de modèles unizones.

Cet outil est destiné aux professionnels du secteur de la construction, tels que les architectes et les concepteurs “lumière” familiers avec les outils de conception par ordinateur. Les données sont principalement introduites grâce à l’interface de modélisation 3D Rhinoceros. Une connaissance de ce logiciel est donc essentielle. Un fichier climatique doit être introduit dans le logiciel et l’analyse de l’éclairage naturel peut ensuite être réalisée, selon une grille de mesures définie par l’utilisateur. Le calcul des différentes métriques ainsi que les rendus visuels peuvent alors être facilement réalisés au travers de l’interface DIVA. Il est cependant utile d’avoir des connaissances avancées de simulations en éclairage naturel car il est nécessaire de modéliser les surfaces de manières à ce qu’elles pointent dans la bonne direction, leur donner les propriété photométriques précises (facteur de réflexion, de transmission, etc), modéliser l’environnement (bâtiments et obstacles) qui affecterons les résultats, et sélectionner les bons paramètres de calcul pour Radiance.

FENER

Fener est utilisé pour comparer des scenarios en termes de climat, géométrie et systèmes de fenêtres, calculant des métriques dynamiques d’énergie, d’éclairage naturel et d’éblouissement. Les fonctions principales de l’outil sont les suivantes :

- Interface conviviale : l’outil guide l’utilisateur dans son introduction de toutes les données requises pour faire tourner FENER. Trois modes différents sont possibles :

- Rapide : données prédéfinies de géométrie et conditions frontières.

- Avancé : permet une flexibilité dans la définition de la géométrie et des conditions frontières

- Expert : permet d’uploader des fichiers de configuration

- Base de données : l’outil inclut une base de données à partir de laquelle des données de caractérisation (BSDF et donnée calorimétriques) relatives aux systèmes de fenêtres peuvent être sélectionnées. Des nouveaux systèmes peuvent être uploadés.

- Stratégie de contrôle : permet à l’utilisateur de définir des stratégies de contrôle. L’utilisateur peut spécifier une matrice d’états de contrôle dépendant de l’occupation, de l’éclairement, de l’indice d’éblouissement, de la température et du rayonnement.

Autres caractéristiques

- Fener peut être utilisé à partir de différents appareils portables

- Il inclut une possibilité de visualisation interactive 3D de la géométrie.

L’objectif de cet outil est double :

- Faciliter le développement de nouveaux produits de façade par les fabricants de composants de façade.

- Quantifier les avantages de choisir l’un ou l’autre système de fenêtre par les architectes et les concepteurs de bâtiment dans les premières étapes de leurs projets.

L’outil n’inclut pas de possibilité de rendu d’éclairement intérieur.

GERONIMO

Geronimo est un software convivial pour les architectes et les concepteurs « lumière » conçu pour réaliser des simulations d’éclairage naturel pour des ciels clairs et couverts. Il permet aussi de visualiser l’impact de l’utilisation de systèmes de fenêtre complexes (CFS) sur l’éclairage naturel des bâtiments.

Le logiciel est destiné aux professionnels du secteur de la construction, tels que les architectes et les concepteurs « lumière » familiers avec les outils de conception par ordinateur. Trois modes d’analyse sont possibles dans GERONIMO : base, moyen, avancé. Le mode de base permet à tout utilisateur de produire un rendu et le mode avancé permet à un utilisateur spécialisé de contrôler les paramètres RADIANCE.

GERONIMO n’inclut pas de fonctionnalité de modélisation 3D; à la place, il fournit 6 typologies de bureau qui sont représentatives des configurations classiques.

Il est possible de travailler avec des modèles 3D personnalisés dans GERONIMO à condition de savoir comment créer un fichier de modélisation RADIANCE, qui peut ensuite être introduit dans GERONIMO.

GERONIMO ne réalise que des simulations d’éclairage naturel ; l’éclairage électrique n’est pas pris en compte.

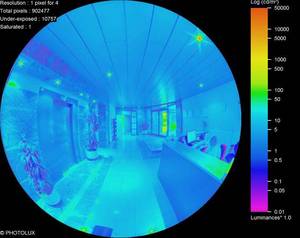

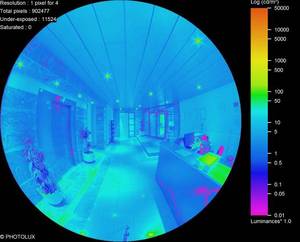

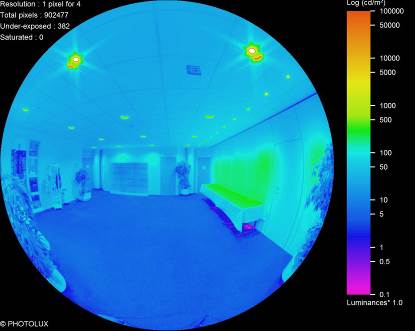

GERONIMO permet des réaliser des rendus en « fausse couleur » de l’éclairement et de valeurs d’éclairement pondérées selon son impact circadien. Il permet de calculer le facteur de lumière du jour et affiche les résultats en niveaux de gris, en utilisant une échelle linéaire ou logarithmique. Il peut calculer les risques d’éblouissement et peut afficher différents indices d’éblouissement. Il contient un module de calcul de l’autonomie diffuse en éclairage naturel réalisé à partir d’un rendu simple sous un ciel couvert.

Site internet de référence : leso.epfl.ch

IES VE

« Virtual Environment » est une suite intégrée d’applications liées par une interface commune et un modèle simple d’intégration de données (IDM). Cela signifie que les données utilisées pour une des applications peuvent être utilisées par d’autres.

Les modèles proposés sont par exemple « ApacheSim » pour la simulation thermique, « Radiance » pour l’éclairage naturel et « SunCast » pour l’analyse des ombrages. L’application de modélisation géométrique 3D est « ModelIT ».

ModelIT permet à l’utilisateur de créer les modèles 3D requis par les autres composants au sein de la « Virtual environment ». ModelIT est conçu pour permettre d’intégrer les niveaux de complexité appropriés au modèle global.

A l’étape de pré-design ou lors de l’étude de faisabilité, des modèles basiques peuvent être générés à partir de croquis en utilisant une variété d’outils de modélisation simples, de manière à mener des évaluations préliminaires ou des études comparatives.

Similairement, en fin de processus de conception, les fichiers .dxf représentant précisément le bâtiment peuvent être importés dans ModelIT, de manière à servir de base pour une représentation 3D des espaces.

Le module d’interface pour RADIANCE, RadianceIES, est intégré dans « Virtual Environment ». Il existe deux types d’images créées par Radiance ; les rendus de luminances et d’éclairements. Un rendu d’éclairement peut être utilisé afin de regarder les valeurs en lux et de générer des iso contours en lux ou en Facteur de Lumière du Jour. Un rendu en luminance est utilisé pour évaluer des indices d’éblouissement ou en tant qu’image photo-réalistes. L’interface est conçue de manière à rendre la création d’images la plus facile possible, en se basant sur des hypothèses par défaut quand c’est possible.

Site internet de référence : www.iesve.com

Lightsolve

L’approche générale de Lightsolve est d’apporter une aide en éclairage naturel, dès le stade de l’avant-projet, au travers d’une visualisation interactive et pro-active, de manière à améliorer la performance du design en termes de performances annuelles. Les métriques évaluées dans Ligthsolve diffèrent de celles évaluées dans la plupart des outils de simulation en éclairage naturel de deux manières : elles sont orientées « objectif » et elles placent leur accent sur la variation de la performance de l’éclairage naturel au cours de l’année en utilisant les cartes temporelles.

Actuellement, 5 différents aspects peuvent être évalués dans Lightsolve :

- Analyse d’éclairement sur base temporelle

- Analyse de l’éblouissement sur base temporelle en fonction de la position de vision (basée sur le DGP)

- Analyse perceptuelle du contraste

- Analyse de variabilité (contraste au cours du temps)

- Évaluation des effets non visuels (santé).

Un calcul de facteur de lumière du jour est également implémenté.

Lightsolve, actuellement sous forme de beta version, a été dévelopé par le LIPID (EPFL) à destination des académiques et pour des raisons de recherche. L’application est disponible gratuitement dans sa version actuelle et sans garantie pour les étudiants, les chercheurs et les praticiens intéressés par l’outil. Comme il n’a pas encore été totalement validé, il est principalement destiné à un usage académique, de manière à collecter le feedback des utilisateurs.

Lightsolve ne fournit pas de fonctionalité de modélisation 3D mais permet d’importer des fichiers waverfront et des fichiers SketchUp.

Grâce à son rendu rapide, il est possible de l’utilisateur pour naviguer librement dans le modèles 3D et d’avoir un premier feedkback visuel des conditions d’éclairage à différents moments du jour et de l’année.

RADIANCE

RADIANCE est un outil sophistiqué d’analyse et de visualisation de la lumière.

À partir de modèles géométriques 3D, il calcule des résultats corrects physiquement et des rendus de haute qualité (luminance / éclairement sous forme de valeurs et d’images). Des représentations en « fausses-couleurs » ou sous forme d’iso-lignes permettent un affichage compréhensible des résultats.

RADIANCE est le programme de référence pour le calcul de la l’éclairage naturel. Les simulations peuvent être réalisées pour différents types de ciel (clair, uniforme ou couvert) ou pour un ciel quelconque défini en utilisant le modèle de Perez. Un plugin additionnel permet de modéliser les 15 nouveaux types de ciel CIE. Le modèle de Perez sert aussi de base pour les calculs annuels de l’éclairage naturel basé sur les données climatiques du lieu considéré.

Des outils supplémentaires permettant de calculer, par exemple, les indices d’éblouissement, sont également disponibles.

RADIANCE est utilisé par les concepteurs, architectes et ingénieurs pour prédire le niveau d’éclairement et l’apparence d’un espace, éclairés avec différents systèmes d’éclairage électrique et naturel, avant la construction. Les chercheurs l’utilisent aussi afin d’évaluer les nouveaux produits d’éclairage. Le software peut être utilisé à toute étape de la conception d’un bâtiment. Il permet de modéliser une grande variété de géométries spatiales et de conditions d’éclairage.

ReluxPro

ReluxPro propose une interface conviviale qui fournit des possibilités d’importation puissantes des plans d’architecture 2D ou de modèles 3D. ReluxPro possède une base de données de luminaires importante, permet de définir précisément la position des luminaires dans le bâtiment et donne rapidement des résultats sous forme de rendus.

ReluxPro permet aussi de calculer des niveaux d’éclairement. Pour chaque zone d’un bâtiment, les niveaux d’éclairement et les valeurs d’uniformité g1 et g2 peuvent être obtenus. Il est dès lors possible d’obtenir un facteur de lumière du jour dans les locaux d’un bâtiment et de prédire la distribution de lumière naturelle dans le local modélisé. Des valeurs de luminance peuvent aussi être calculées.

Il est destiné au secteur des professionnels de la construction, tels que les architectes et les concepteurs d’éclairage familiarisés avec les outils de conception informatique.

ReluxPro inclut des fonctionnalités de modélisation 3D très faciles d’utilisation. Il est possible de modéliser les meubles et les luminaires, à partir d’une vaste base de données. Les ouvertures de fenêtre ainsi que d’autres éléments tels que des portes, peuvent être ensuite définies dans les murs.

Site internet de référence : www.relux.com

VELUX Daylight Visualizer

VELUX Daylight Visualizer est un outil de simulation professionnel destiné à l’analyse et la visualisation des conditions d’éclairage naturel dans les bâtiments de toute échelle, en incluant le résidentiel, les bâtiments commerciaux, les bâtiments industriels et institutionnels. Il est capable de calculer l’éclairement et la luminance pour les 15 types de ciel définis par la CIE. Il peut aussi calculer le facteur de lumière du jour.

L’interface est intuitive ce qui rend le programme accessible aux utilisateurs débutants ainsi qu’à ceux qui sont plus expérimentés à l’usage des outils de calcul de l’éclairage naturel. Le temps de calcul nécessaire pour réaliser une étude d’éclairage naturel est aussi assez retreint.

Les résultats de simulation sont soit des images photo-réalistes qui peuvent être converties en fausse-couleur ou superposées par des iso-lignes soit des valeurs numériques. En plus des images fixes, le programme peut être utilisé pour créer des animations basées sur la course du soleil.

VELUX Daylight Visualizer est utilisé par les architectes et les ingénieurs pour prédire les niveaux d’éclairement et évaluer l’apparence d’un espace durant la conception d’un bâtiment.

Le programme peut être utilisé au tout début de la conception d’un bâtiment de manière à évaluer la disponibilité et à valider la performance du design final. VELUX Daylight Visualizer est aussi utilisé dans plusieurs écoles et universités pour enseigner l’éclairage naturel.

Site internet de référence : viz.VELUX.com

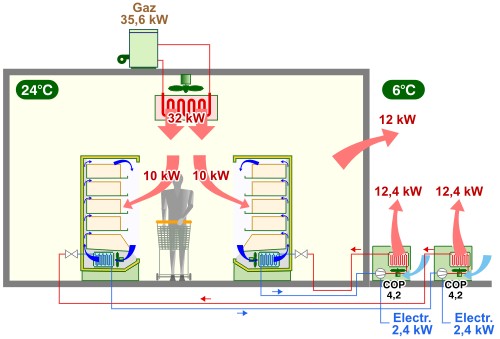

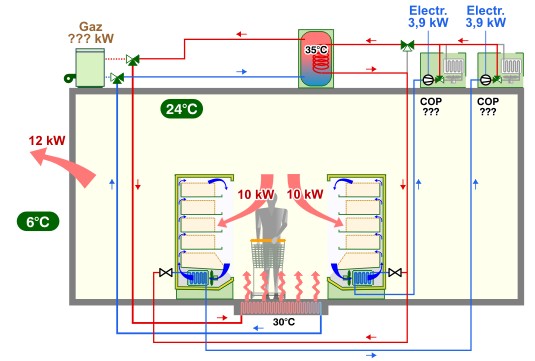

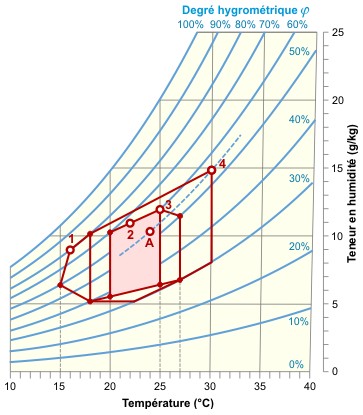

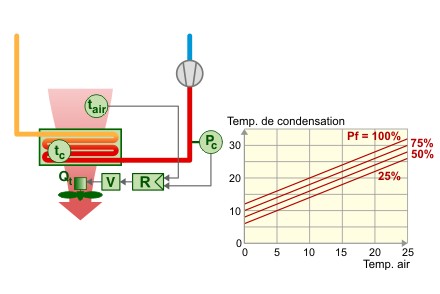

![]() EUROVENT, à savoir généralement pour une classe d’ambiance 3 (25°C, 60 % HR) :

EUROVENT, à savoir généralement pour une classe d’ambiance 3 (25°C, 60 % HR) :

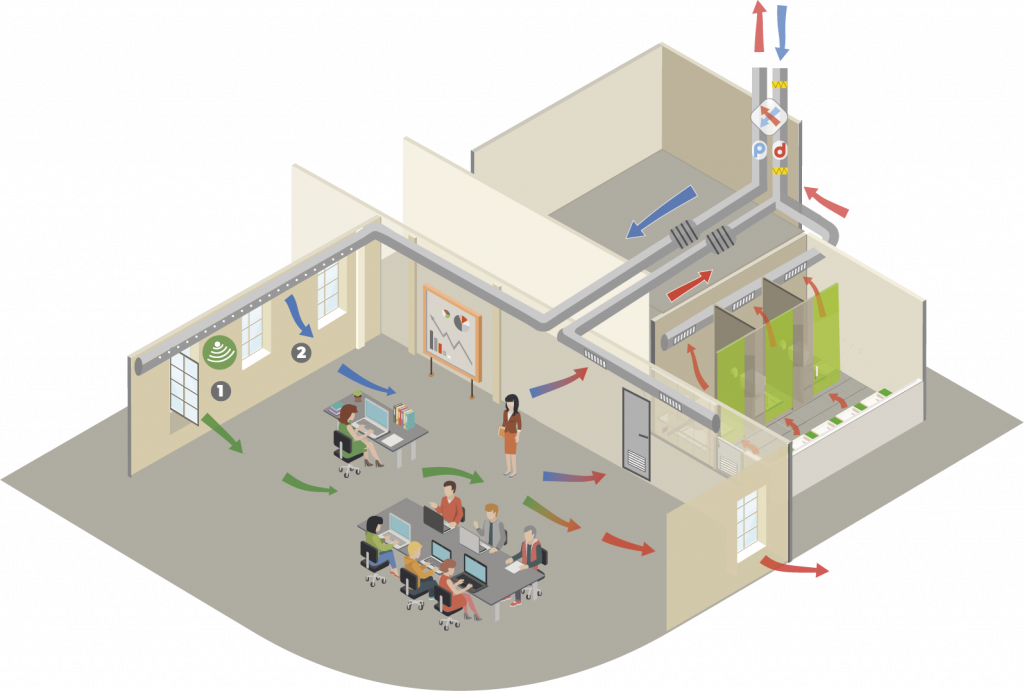

![Régler les débits de ventilation [gérer - ventilation] Régler les débits de ventilation [gérer - ventilation]](https://energieplus-lesite.be/wp-content/uploads/2020/02/ventilation-debit-bon-1024x538.jpg)

![Détecteur de mouvement et de présence/absence [Ventilation] Détecteur de mouvement et de présence/absence [Ventilation]](https://energieplus-lesite.be/wp-content/uploads/2015/03/mouvement-bon-800x420.jpg)

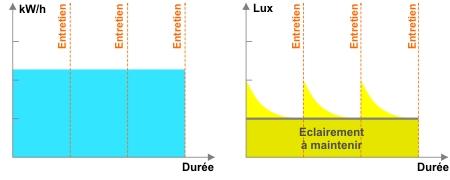

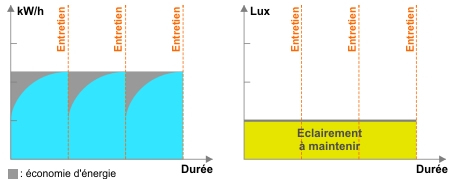

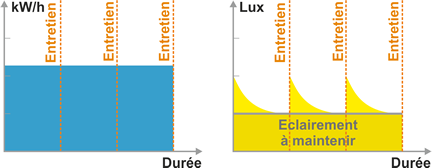

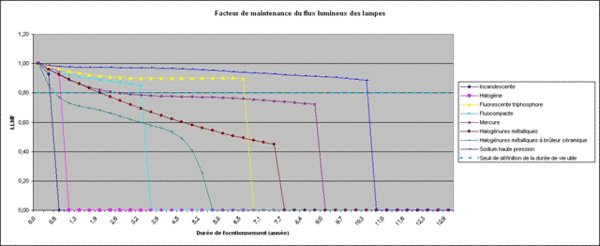

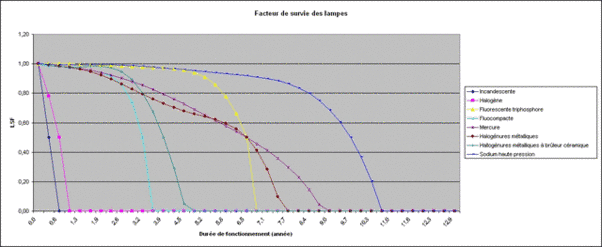

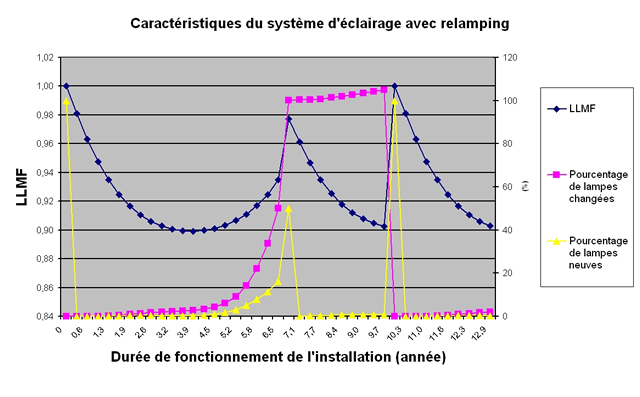

![Choisir entre les différentes caractéristiques influençant le programme de maintenance [Eclairage] Choisir entre les différentes caractéristiques influençant le programme de maintenance [Eclairage]](https://energieplus-lesite.be/wp-content/uploads/2007/10/eclairage-maintenance-bon-800x420.jpg)

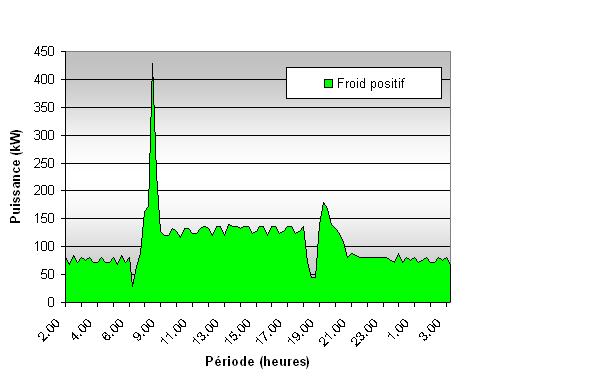

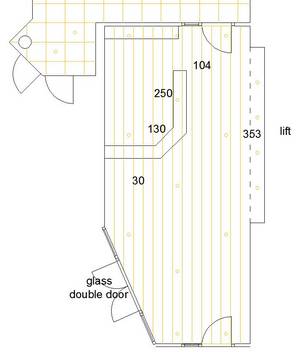

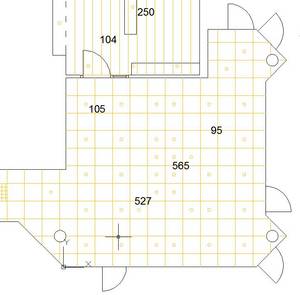

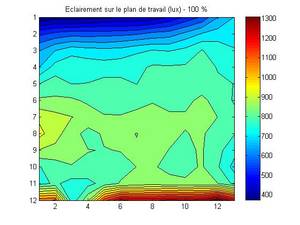

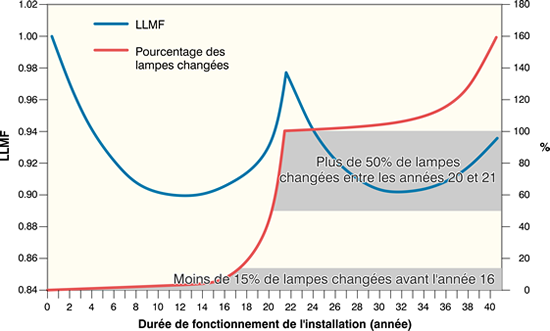

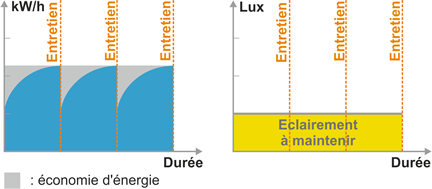

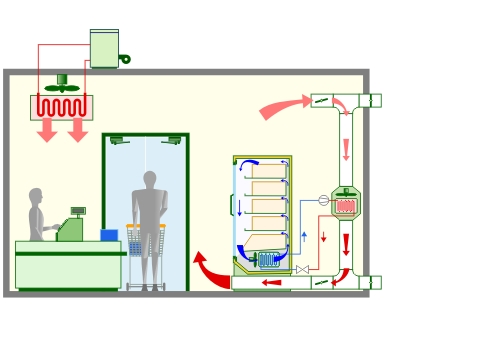

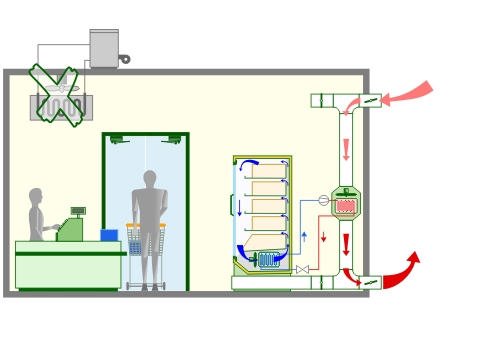

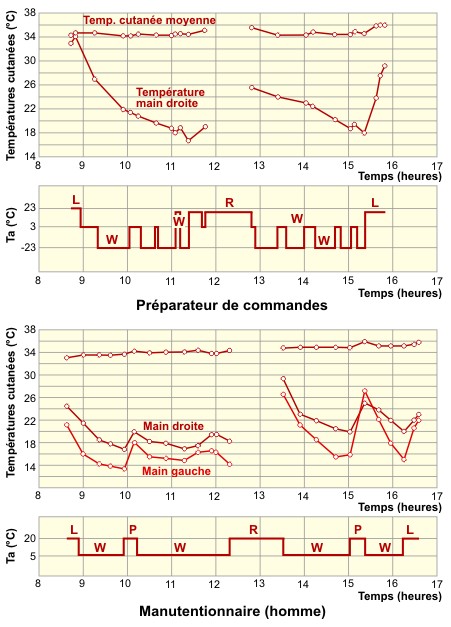

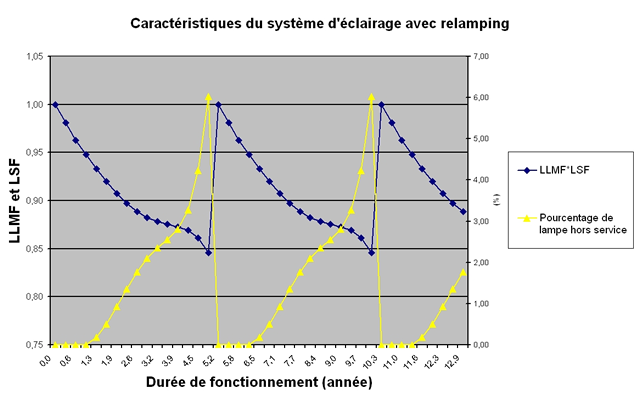

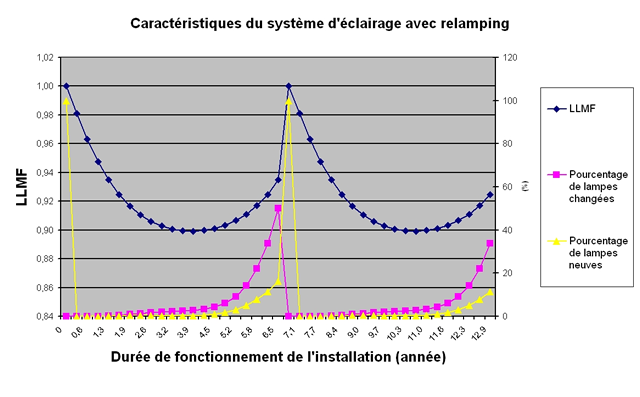

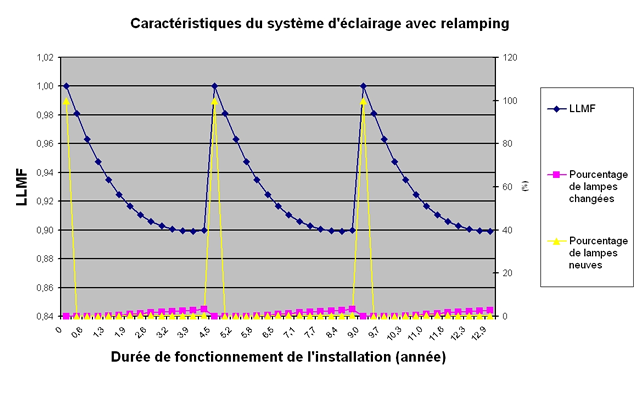

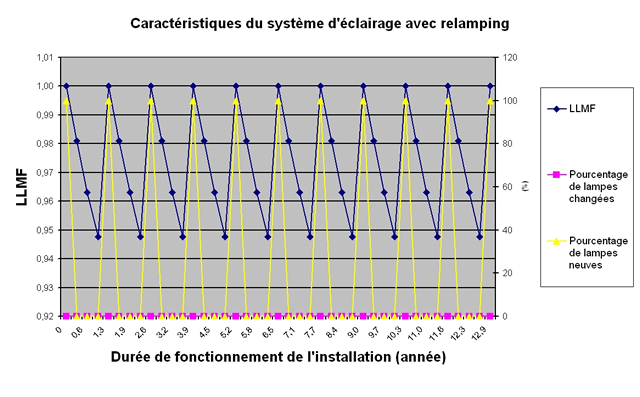

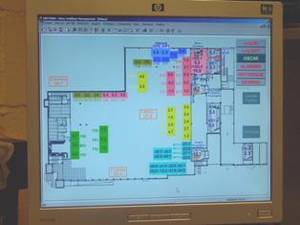

Exemple.

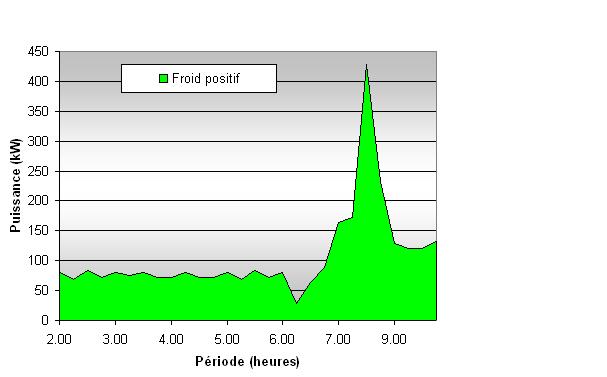

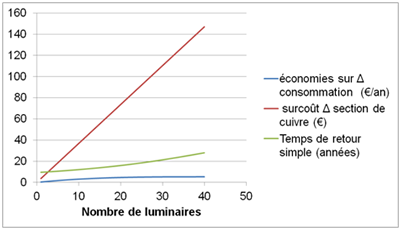

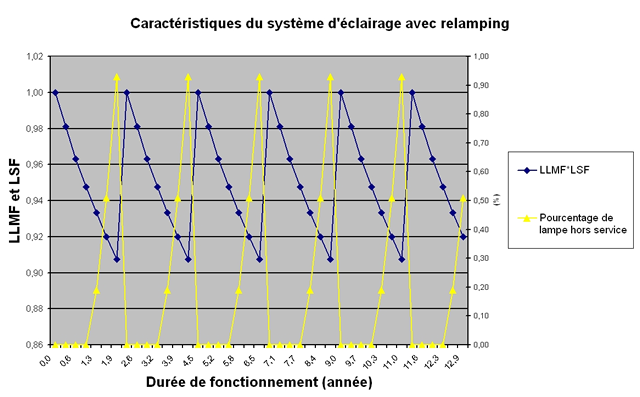

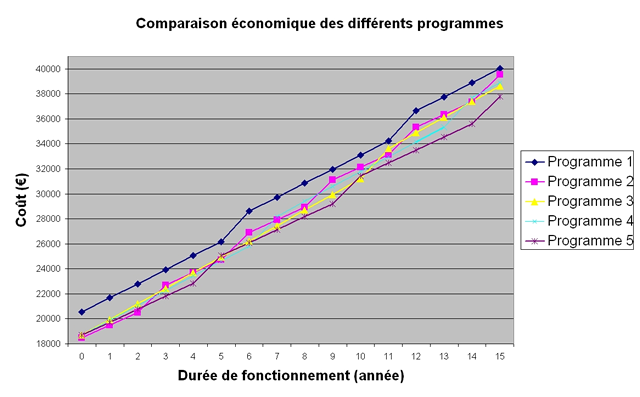

Exemple.

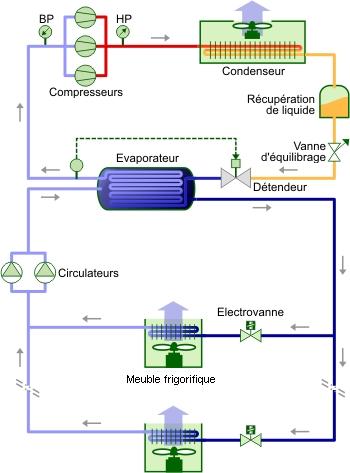

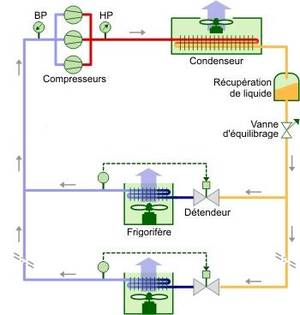

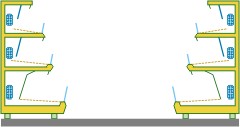

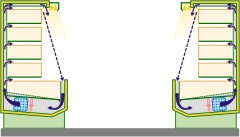

![Détendeurs [Climatisation] Détendeurs [Climatisation]](https://energieplus-lesite.be/wp-content/uploads/2019/03/detendeur.gif)

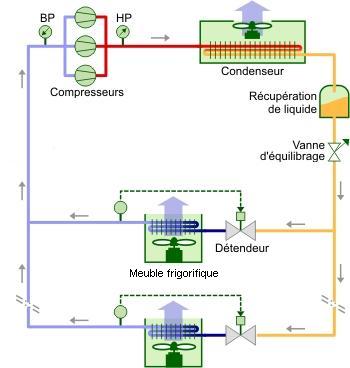

![Détendeurs [Froid alimentaire] Détendeurs [Froid alimentaire]](https://energieplus-lesite.be/wp-content/uploads/2019/03/RTEmagicC_detendeur.gif.gif)