Score agrégé de performance environnementale

La multiplicité des scores d’impact environnemental lorsqu’ils sont pris de manière individuelle constitue rarement une bonne base pour la prise de décision. C’est pourquoi, TOTEM permet de visualiser le profil environnemental d’un élément ou du bâtiment à l’aide d’un score agrégé. L’agrégation de tous les impacts environnementaux en un score unique s’inscrit dans cette logique « decision- making » et permet aux utilisateurs d’effectuer une sélection orientée vers la prise de décision quant aux solutions de construction.

Pondération selon la méthode PEF

Au sein du logiciel TOTEM, il est donc possible de calculer un score unique pour l’ensemble des dix-neuf indicateurs environnementaux. Dans la suite logique de la mise à jour de la norme EN 15804 + A2 en juillet 2021 sur laquelle TOTEM s’aligne, il a été décidé d’abandonner l’ancienne approche de monétisation et d’appliquer l’approche de pondération PEF (Performence Environmental Footprint). La méthodologie PEF calcule, sur base des indicateurs environnementaux caractérisés, un score unique au moyen d’une étape de normalisation suivie d’une étape de pondération.

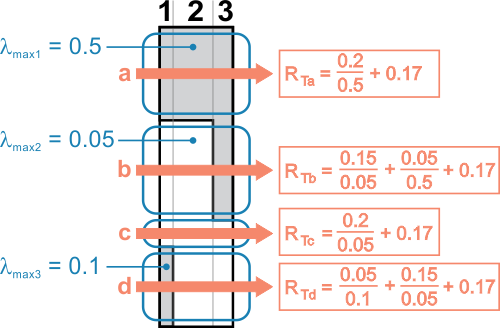

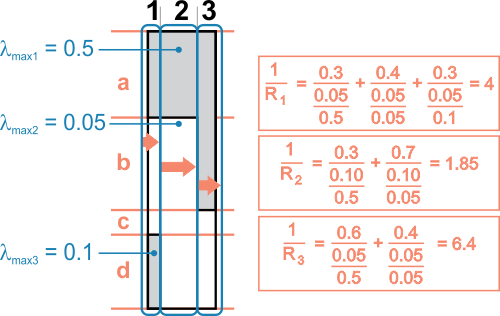

L’approche de la pondération PEF comprend deux étapes : normalisation et pondération, qui sont ensuite regroupée dans une agrégation.

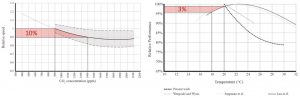

Normalisation

La normalisation vise à calculer l’ampleur du phénomène de l’indicateur de catégorie par rapport à un système de référence. Pour chaque indicateur environnemental, les valeurs caractérisées sont divisées par leurs facteurs de normalisation respectifs, exprimés en impact global annuel par habitant (sur la base d’une valeur globale pour l’année de référence 2010). Les résultats normalisés sont donc logiquement sans dimension.

TOTEM applique les facteurs de normalisation proposés par la plateforme européenne sur l’analyse du cycle de vie (EPLCA 2019). Par exemple, le facteur de normalisation pour le changement climatique est de 8,1 X 10³ kg CO2 eq./personne par an. L’ensemble des facteurs de normalisation utilisé dans la méthode PEF a été élaboré à partir de données statistiques sur les émissions et les ressources utilisées dans le monde pendant un an par habitant.

Pondération

Dans un deuxième temps, les valeurs normalisées sont pondérées en les multipliant par des facteurs de pondération afin de refléter l’importance relative perçue des catégories d’impact environnemental considérées. Par exemple, le facteur de pondération pour le changement climatique est de 21,06 %.

Les facteurs de pondération proposés sont calculés sur la base d’une combinaison d’ensembles de pondération :

- un ensemble de pondérations provenant d’une enquête publique (25 %)

- un ensemble de pondérations dérivé d’une enquête menée auprès d’experts en ACV (25 %), et

- une approche hybride combinant des critères fondés sur des preuves (par exemple, l’étendue, la durée, la réversibilité des impacts…) et un jugement d’expert (50 %). Pour tenir compte de la robustesse des indicateurs d’impact, un facteur de correction (sur une échelle de 0,1 à 1) est appliqué aux facteurs de pondération afin de réduire l’importance des catégories d’impact dont la robustesse est faible (degré d’incertitude trop grande, données peu représentatives,…).

Agrégation

Après pondération, les résultats des différents indicateurs environnementaux peuvent être additionnés pour obtenir une note globale unique (exprimée en millipoints dans TOTEM). Le tableau ci-dessus un aperçu des facteurs de normalisation et de pondération.

Après normalisation et pondération, les scores peuvent être agrégés en un seul score. Dans les tableaux de résultats de Totem, un « facteur d’agrégation » par indicateur d’impact est donné sur la base de la combinaison des facteurs de normalisation et de pondération du PEF. Ces facteurs d’agrégation sont calculés en multipliant l’inverse de chaque facteur de normalisation avec son facteur de pondération correspondant et puis en multipliant par 1000 pour la conversion de Pt en millipoints.

Si vous voulez en savoir plus sur le score environnemental unique de Totem, nous vous recommandons la video ci-dessous :

Ventilation des résultats

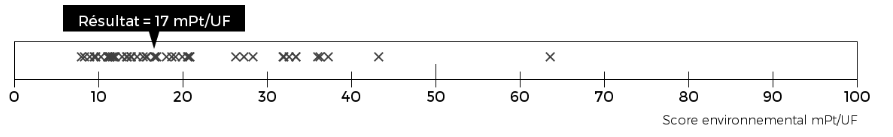

Disposer d’un score unique permet de combiner des impacts différent, mais ne bride pas toute capacité d’analyse plus fouillée. Totem propose différentes décompositions des résultats, par indicateurs, composant, ou étape du cycle de vie.

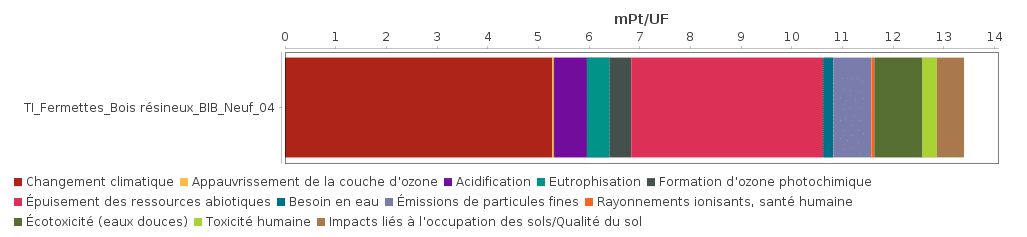

Impact par indicateur

La figure ci-illustre la décomposition de l’impact environnemental d’un élément choisi en exemple est issu de la bibliothèque de TOTEM. Il s’agit d’un élément correspondant à la description suivante: Élément de toiture en pente / Recouvrement en ardoise_Fibre-ciment | Poutres_Bois résineux (172 mm – entraxe 400 mm) | Matelas_Laine de roche (170 mm) | Panneau_Plâtre.

Cette figure permet d’identifier facilement les impacts les plus impactant dans le score global de cet élément : dans ce cas, il s’agit de la contribution u changement climatique, de l’épuisement des ressources abiotiques et des émissions de particules fines.

Si vous voulez en savoir plus sur les différents indicateurs environnementaux utilisés dans TOTEM, nous vous recommandons la video ci-dessous :

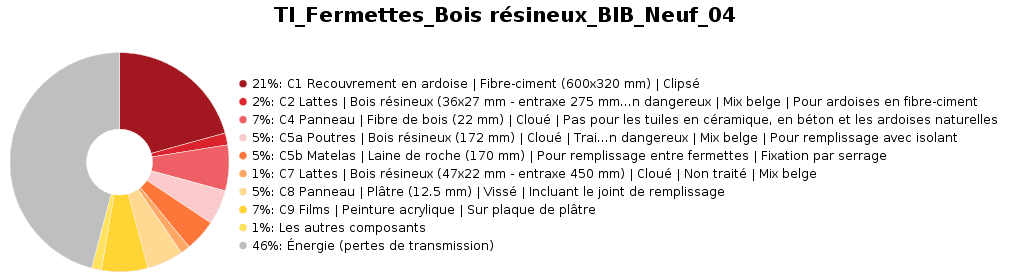

Impact par composant

Le même exemple peut être analysé par composant :

On voit ici que 46% de l’impact est lié aux pertes de chaleur par transmission associée à cette paroi, et que le deuxième élément le plus impactant est lié au recouvrement en ardoise, ce qui suggère de mettre en question ce choix de recouvrement avant d’autres composants, tels que le matériau isolant (5% de l’impact uniquement dans ce cas).

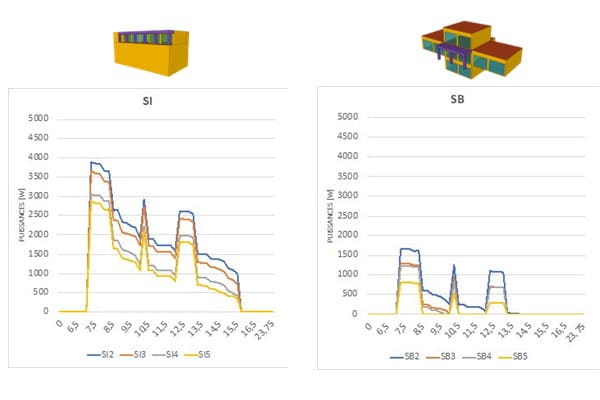

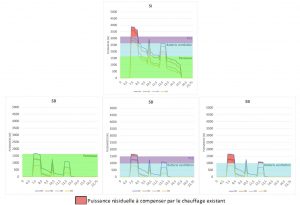

Impact par étape du cycle de vie

Cette troisième visualisation permet de voir que la phase B6, représentant l’énergie de chauffage associée à l’élément, est de loin dominante. Deux autres phases se détachent : A1-A3, qui couvre la production des éléments, et B4, qui représente le remplacement de certains éléments durant le cycle de vie. Les étapes de transport et de fin de vie pèsent par contre peu, ce qui relativise les incertitudes pesant sur les scénarios de réemploi, recyclage ou traitement en fin de vie.

![Adoucisseur d'eau [ECS] Adoucisseur d'eau [ECS]](https://energieplus-lesite.be/wp-content/uploads/2007/09/eau-01-bon-800x420.jpg)