Tout au LED

Actuellement, en termes d’éclairage, on s’oriente en majorité vers la technologie LED. Celle-ci est en plein essor et ne cesse de s’améliorer au fil des années. Les arguments les plus souvent énoncés en faveur des LED sont leur grande efficacité lumineuse, leur durée de vie extrêmement longue et leur faible consommation électrique.

Technologie miracle ? Pas tout à fait…. Autant les LEDs paraissent meilleurs que la concurrence sur le plan performanciel et énergétique, il n’est pas de même en termes de confort visuel et d’impact sur la santé.

Le LED aujourd’hui

Aujourd’hui, les lampes à LED sont particulièrement performantes et beaucoup plus économes en énergie que les technologies classiques.

À titre d’exemple, le tableau comparatif ci-dessous provient d’une étude scientifique((L.T. Doulos et al. Minimizing energy consumption for artificial lighting in a typical classroom of a Hellenic public school aiming for near Zero Energy Building using LED DC luminaires and daylight harvesting systems, Energy and Buildings, Volume 194, 2019, Pages 201-217)) et met en évidence les dernières avancées en termes de LED par rapport à un luminaire classique à tube fluorescent. Les résultats peuvent évidemment dépendre selon les produits testés.

| LED (AC supply) | LED (DC supply) | T5 2x35W | |

| Puissance (W) | 41.0 | 50.5 | 76.0 |

| Efficacité lumineuse (lm/W) | 116.1 | 107.6 | 62.0 |

| Puissance spécifique (W/m2) | 3.16 | 3.90 | 5.86 |

| Nombres de luminaires utilisés | 4 | 4 | 4 |

| Puissance totale installée (W) | 164 | 202 | 304 |

| Consommation annuelle (kWh) | 255.8 | 315.1 | 474.2 |

| Eclairement (lx) | 302 | 322 | 308 |

On remarque que les luminaires LED sont aujourd’hui largement plus efficaces en termes de consommation électrique, à niveau d’éclairement similaire.Il est donc très intéressant de se tourner vers des solutions 100% LED dans des projets de rénovation visant le zéro-carbone, d’autant plus que l’efficacité lumineuse retenue pour les luminaires ci-dessus n’est pas le plein potentiel de la technologie.

Effets sanitaires

Face à la constante amélioration de la technologie LED, l’ANSES (Agence nationale de sécurité sanitaire de l’alimentation, de l’environnement et du travail) a récemment publié un nouveau rapport étudiant les effets sanitaires de ces systèmes sur la population. Les LED sont caractérisées par un spectre de lumière plus riche en lumière bleue et plus pauvre en lumière rouge que d’autres sources lumineuses, créant un déséquilibre spectral particulièrement nocif pour nos yeux. De plus, “les lumières à LED peuvent être plus éblouissantes que les lumières émises par d’autres technologies (incandescence, fluo-compactes, halogènes, etc.)” (ANSES, p.355). “Enfin, les LED sont très réactives aux fluctuations de leur courant d’alimentation. De ce fait, selon la qualité du courant injecté, des variations de lumière peuvent apparaître, suivant la fréquence et le niveau de ces variations.” (ANSES, p.355)

Le rapport étudie donc différents effets sanitaires :

- les effets de la lumière bleue sur les rythmes circadiens (perturbation de l’horloge circadienne) ;

- les effets de la lumière bleue sur le sommeil et sur la vigilance (retard de sommeil et altération de la quantité et qualité du sommeil) ;

- les effets de la lumière bleue et des différents types de LED sur l’œil (phototoxicité, sécheresse oculaire, myopisation) ;

- les effets de la lumière bleue sur la peau ;

- les effets de la modulation temporelle de la lumière sur la santé ;

- les effets liés à l’éblouissement.”((Source: https://www.anses.fr/fr/system/files/AP2014SA0253Ra.pdf – p.356))

Afin de protéger la population de tous ces effets sanitaires, l’ANSES émet une série de recommandations liées à l’utilisation de lumières à LED. Certaines sont de l’ordre de futures recherches à mener ou de suggestions d’évolutions réglementaires tandis que d’autres sont de l’ordre de bonnes pratiques à prendre en compte directement dans des projets de relighting. On retiendra les deux principales :

- Limiter au plus possible l’exposition à des lumières froides (> 4000 K)

- Exclure les lampes LED nues du champ de vision

Toutefois, les difficultés des LED ciblées dans l’étude sont surtout liées au lien entre lumière bleue et endormissement. Elles sont donc peu pertinentes dans les écoles.

Pour plus d’informations, celles-ci sont reprises dans le document « Effets sur la santé humaine et sur l’environnement (faune et flore) des diodes électroluminescentes (LED) » en page 363 : https://www.anses.fr/fr/system/files/AP2014SA0253Ra.pdf

Le LED en rénovation

Avant de se lancer dans un projet de rénovation de l’éclairage de l’école, il faut impérativement passer par l’étape d’analyse et de diagnostic de la situation existante. Pour cela, il est préférable de faire appel à un bureau spécialisé en éclairage. Cependant, il existe quelques outils sur le site de Rénover mon école qui vous permettront de réaliser un rapide diagnostic de l’installation lumineuse de vos salles de classe. Les pages suivantes sur Energie+ peuvent également être utiles :

- Evaluer l’efficacité énergétique des équipements

- Auditer rapidement l’éclairage

- Evaluer l’efficacité énergétique de la gestion de l’éclairage

Le site internet de Rénover mon école regroupe une grande partie des questions générales à se poser lors de la rénovation de l’éclairage. Attention que les informations mentionnées en termes d’objectifs et de techniques ne sont plus de toute fraîcheur… En plus de cela, elles ne visent pas l’objectif zéro-carbone qui nous intéresse dans ce dossier.

Pour plus d’infos concernant le passage au LED, consultez la page suivante.

Que faire donc dans notre cas ?

Procéder à un relighting de l’école dans une démarche zéro carbone nécessite de faire attention à deux points principaux :

- Viser une puissance faible

- Avoir une gestion efficace

En termes de puissance...

Comme vu plus haut, le LED offre de faibles puissances et donc a fortiori de meilleures performances énergétiques. C’est donc principalement vers cette technologie qu’il faut se tourner lorsqu’on envisage le relighting d’un bâtiment scolaire.

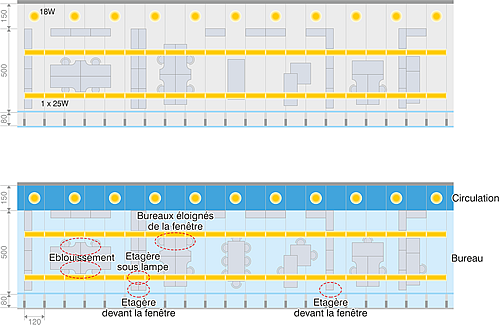

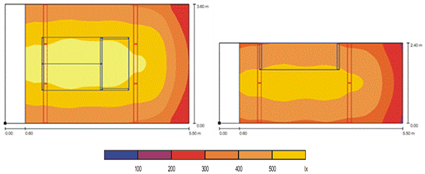

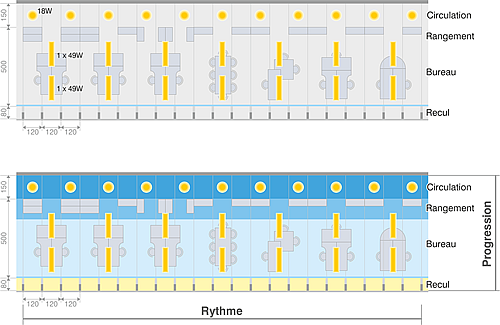

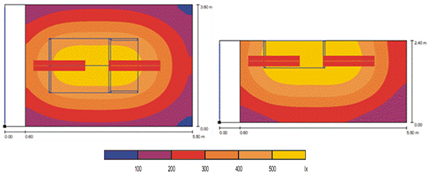

L’emplacement des luminaires dans le local a toute son importance en termes de puissance. Un moins grand nombre de luminaires, mais bien situés afin de garantir une uniformité de l’éclairement, permettra de réduire la puissance totale et donc la consommation en carbone.

La question de la gestion….

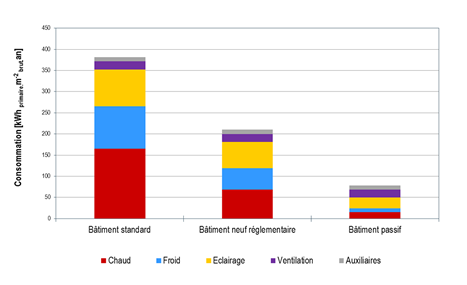

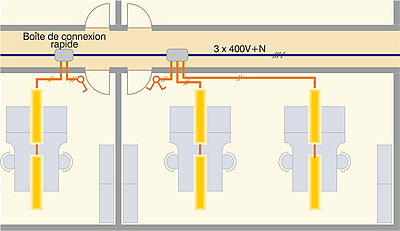

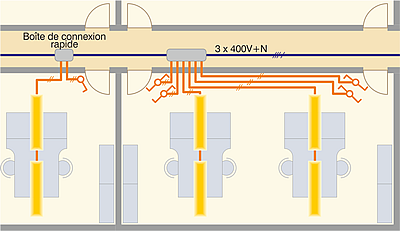

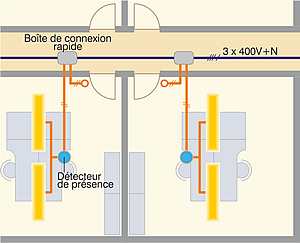

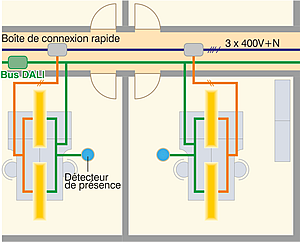

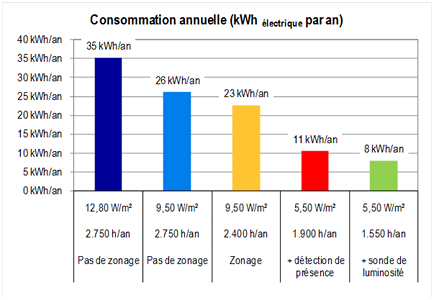

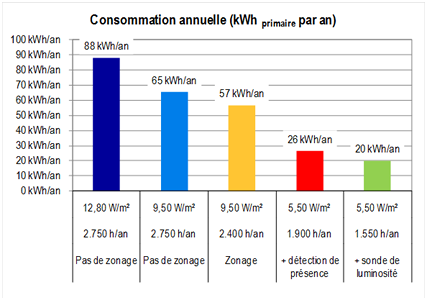

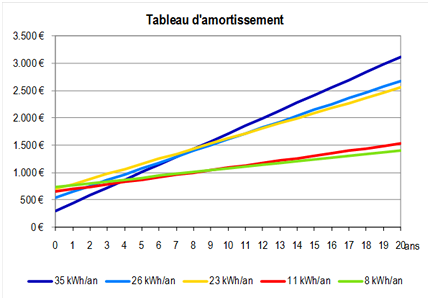

C’est principalement sur ce point qu’il est utile d’insister lorsque l’on conçoit un relighting d’une école. 35% de la facture énergétique des écoles correspond à l’électricité consommée par l’éclairage. Bien souvent, cela est dû à une mauvaise gestion du système d’éclairage. Il est impératif de rendre les occupants des locaux conscients de leurs décisions en limitant au maximum l’allumage automatique de lampes par exemple. L’extinction automatique, le zonage ou encore le dimming des lampes sont autant de principes qu’il est nécessaire de prendre en compte dans une démarche zéro-carbone. Pour plus d’informations sur ces techniques, consultez les pages suivantes :

De plus, une attention particulière doit être portée sur le programme de maintenance afin de garantir la pérennité du projet de relighting.

Rénover pour consommer…plus ?

Il est nécessaire de pointer la faiblesse actuelle en termes de niveaux d’éclairage dans les écoles. Les installations vétustes et inconfortables ne respectent souvent pas les normes visées lors de projets de relighting ou de constructions neuves. Dès lors, il se peut qu’après rénovation, le système d’éclairage consomme plus qu’auparavant. Cependant, au profit d’un meilleur confort visuel, qui s’avère bénéfique en de nombreux points pour tous.

Réemploi des systèmes existants

Lors de nouvelles constructions, il est facile et logique de concevoir l’ensemble de l’éclairage sur un système électrique approprié à la technologie LED. Mais est-il aussi simple d’adapter un système d’éclairage existant à la technologie LED? Dans un souci d’économie financière, est-il possible dans un projet de rénovation scolaire de garder les luminaires existants en y changeant simplement les tubes ?

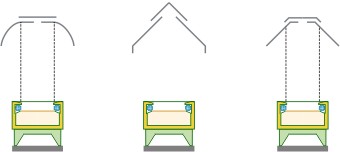

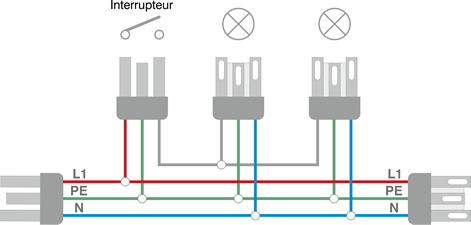

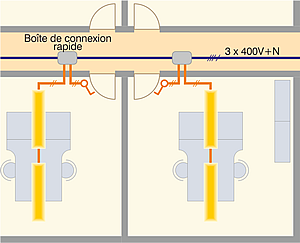

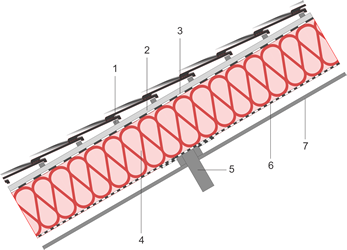

Les luminaires existants de type tube T5 ou T8 sont toujours équipés de ballasts électroniques ou ferromagnétiques. Dans les deux cas, il est possible, moyennant certaines manipulations (voir article G0W), de passer d’une technologie de tube fluorescent vers des tubes LED. Il est donc tout à fait envisageable de maintenir les luminaires existants lors d’un projet de relighting au LED. Cependant, les lampes LED ayant des niveaux de luminance élevés, il est impératif d’utiliser des mécanismes optiques adaptés. On favorisera donc des mécanismes de réfraction ou de transmission à la place de mécanismes de réflexion.

À proscrire : mécanismes de réflexion

À recommander : mécanismes de réfraction

Recommandations

Les situations de relighting sont très différentes en fonction de l’usage des espaces à rénover. La disposition des luminaires, le type de luminaire, la température de lumière ou encore le mode de gestion de l’éclairage sont autant de paramètres qui varient en fonction de l’utilisation de l’espace.

Le site de Rénover mon école reprend, sur les deux pages suivantes, les grandes recommandations à prendre en compte pour des classes, des espaces de circulations, des bureaux ou encore des réfectoires :