Choisir la fenêtre comme capteur de lumière naturelle [Les fenêtres]

Favoriser l’éclairage naturel extérieur

Dans une démarche de construction ou de rénovation lourde, on privilégiera l’utilisation de la lumière naturelle à la place de l’éclairage artificiel. La qualité « spectrale » de la lumière naturelle ainsi que sa variabilité et ses nuances offrent une perception optimale des formes et des couleurs. L’éclairage artificiel devrait donc être considéré comme un complément à la lumière naturelle. Aussi, d’un point de vue énergétique, l’utilisation de l’éclairage naturel comme « source » lumineuse est gratuite ; ce qui signifie que la facture en électricité sera d’autant plus réduite que l’éclairage naturel exploité.

Dans bien des projets de conception ou de rénovation de bâtiments tertiaires, en confort lumineux, l’objectif premier est de privilégier l’ouverture des espaces de travail vers la lumière naturelle tout en sachant qu’une trop grande ouverture des façades est souvent synonyme d’éblouissement, de surchauffe et déperditions thermiques au travers des baies vitrées. Le compromis reste de rigueur !

Bien des paramètres viennent influencer de manière plus ou moins significative la pénétration de la lumière dans les espaces de travail :

- L’orientation des façades ;

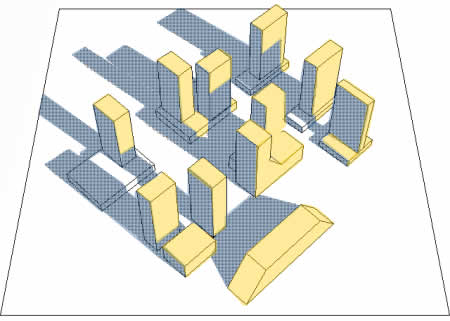

- La présence d’ombres reportées (bâtiments ou autres façades du bâtiment étudié faisant de l’ombre) ;

- La taille, la forme et la position des baies vitrées dans les façades ;

- La forme et les dimensions des trumeaux ;

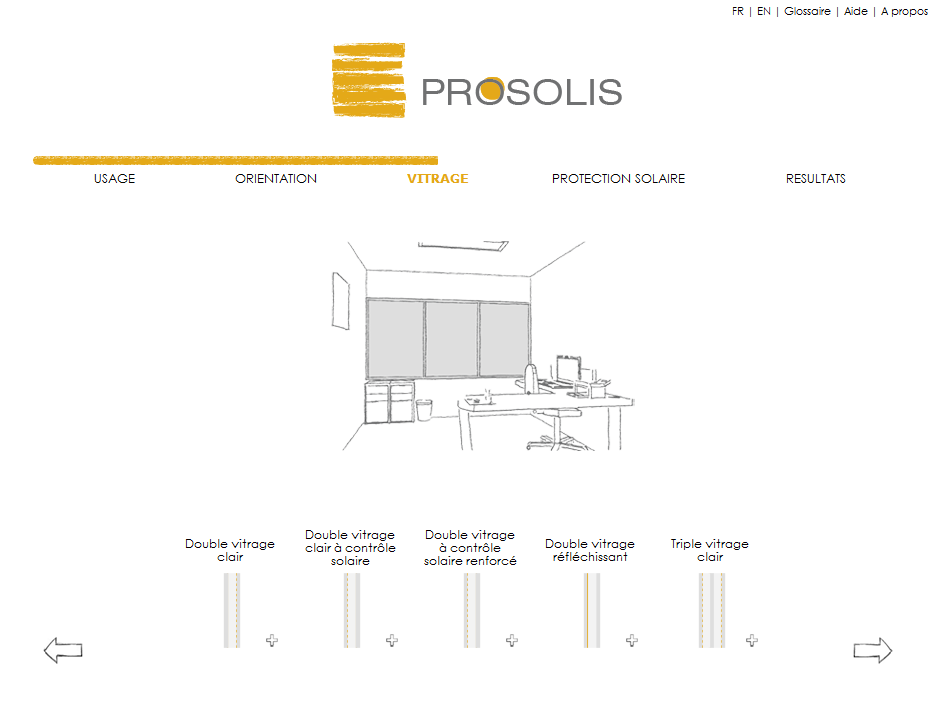

- Les caractéristiques des vitrages ;

- La présence de protection solaire (fixe, mobile, …) ;

- …

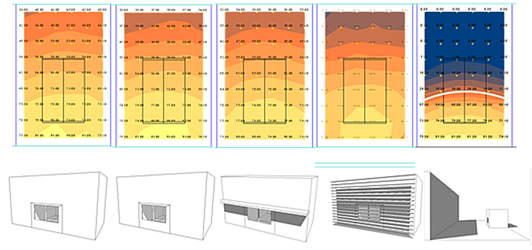

Vitrage clair. Vitrage sélectif. Auvent. Lamelles. Ombre reportée.

Pour un projet de taille importante, une étude par un bureau spécialisé est toujours intéressante sachant qu’il est possible d’optimiser conjointement les conforts lumineux et thermiques par des simulations dynamiques tenant compte de l’ensoleillement et du climat à tout moment de l’année disponible sous forme de bases de données type « météonorm » par exemple.

L’éclairage naturel extérieur n’est pas uniforme

L’intensité de la lumière naturelle varie fortement en fonction du type de ciel, du moment de l’année, de l’heure dans la journée, de l’orientation de l’ouverture, de son inclinaison et de son environnement.

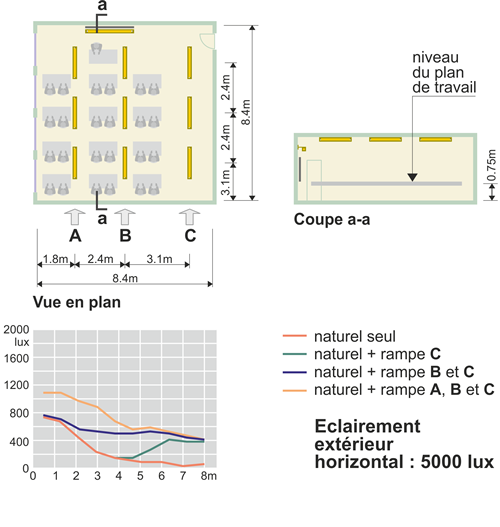

Les études d’éclairage naturel des locaux sont basées, conventionnellement, sur un ciel couvert donnant un niveau d’éclairement de 5 000 lux sur une surface horizontale en site dégagé (Commission Internationale de l’Énergie).

Or, en Belgique, un tel éclairement est dépassé 80 % du temps entre 8h00 et 16h00, par ciel couvert. Et ce ciel couvert ne se présente que 36 % du temps de l’année.

À l’extrême, en juin, à midi et par ciel serein, l’éclairement dépasse 100 000 lux! (Franchement, de quoi se plaint-on ?!)

Lumière solaire directe ou lumière solaire diffuse ?

La lumière solaire directe dispense un flux considérable, facile à capter et à diriger. Elle présente une dynamique intéressante (création de reliefs dans le bâtiment) et peut être utilisée en tant qu’énergie thermique. Par contre, le rayonnement solaire direct est souvent une source d’éblouissement et parfois de surchauffe du bâtiment. De plus, sa disponibilité est épisodique et dépend de l’orientation des ouvertures.

La lumière diffuse du ciel est disponible dans toutes les directions. Elle suscite peu d’éblouissement, ne provoque pas de surchauffe, mais elle peut être insuffisante dans de nombreux cas. En outre, elle crée peu d’ombres et de très faibles contrastes. Une lumière diffuse est donc idéale pour des locaux de travail où il est important d’avoir un éclairage constant, sans source d’éblouissement. La lumière du nord est assurément une lumière diffuse (depuis toujours exploitée dans les ateliers d’artistes). Mais il est possible de valoriser également la lumière directe venant des autres orientations, pour autant qu’une protection masque le disque solaire ou qu’un rideau intérieur diffuse la lumière incidente.

L’influence de l’environnement

Lors de la conception d’un bâtiment, il est donc important de mesurer l’impact de l’environnement existant sur le nouvel édifice afin de profiter au mieux des possibilités offertes par le terrain pour capter la lumière.

Le relief du terrain, les constructions voisines, … peuvent modifier fortement l’apport.

L’effet de rue est caractérisé par le masque solaire que créent les bâtiments situés de l’autre côté de la rue. Il dépend de la hauteur de ces constructions et de la distance qui sépare les deux côtés de la rue.

Des surfaces réfléchissantes placées au sol telles qu’un dallage brillant ou un plan d’eau peuvent contribuer à capter davantage de lumière. Ainsi, l’eau, en réfléchissant le ciel et l’environnement, intensifie l’impression lumineuse d’un lieu.

Mais la présence d’un bâtiment voisin équipé de vitrages réfléchissants, précisément pour se protéger de l’ensoleillement, risque de provoquer un éblouissement excessif des occupants.

Des éléments liés au bâtiment lui-même, tel que des murs de refends, des surplombs, des light shelves, … peuvent aussi provoquer un ombrage en fonction de leur taille, de leur réflectivité et de leur orientation.

La végétation se distingue des autres écrans parce qu’elle peut être saisonnière, ce qui est le cas des arbres à feuilles caduques, et que par ailleurs elle ne possède qu’une opacité partielle. Elle se contente de filtrer la radiation lumineuse plutôt que de l’arrêter.

Sélectionner la fenêtre comme espace capteur de lumière

Pour quels locaux ?

A priori, tous les locaux devraient disposer d’un éclairage naturel (sauf archives et locaux techniques). On peut parler de nécessité pour les « locaux de vie » (où les occupants séjournent plusieurs heures par jour) et de souhait pour les sanitaires et les circulations (où les occupants ne font que passer).

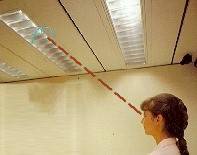

Voici deux couloirs du même bâtiment, avec les mêmes orientations.

Dans le premier cas, l’architecte a introduit une dissymétrie dans la distribution des locaux, et des ouvertures vers l’extérieur pour introduire de la lumière naturelle.

Faut-il préciser que la première mise en œuvre est plus chère ?..

On parle ici de qualité de l’ambiance intérieure dans un lieu de travail.

Ouverture latérale ou zénithale ?

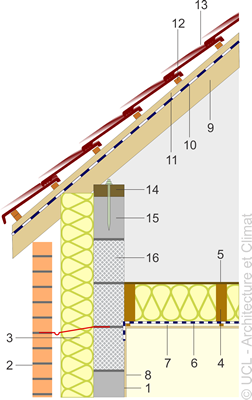

Ouverture latérale et ouverture zénithale.

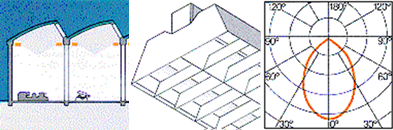

Au niveau de l’apport de lumière naturelle, une ouverture zénithale s’ouvre sur la totalité de la voûte céleste. Elle induit une meilleure pénétration de lumière, particulièrement par temps nuageux. La distribution lumineuse obtenue par une ouverture zénithale est aussi beaucoup plus homogène que celle produite par une fenêtre latérale. De plus, la lumière entre dans les locaux par le plafond, ce qui limite a priori les phénomènes d’éblouissement. L’éclairage zénithal convient spécialement à la pénétration de la lumière naturelle dans les bâtiments bas et profonds.

Distribution de lumière très homogène,

mais défavorable à la perception du relief.

Mise en évidence du relief par l’éclairage latéral,

malgré un couloir rectiligne.

Par contre, la lumière latérale est favorable à la perception du relief. L’entretien est également plus facile que pour une ouverture zénithale. De plus, le bilan thermique est en faveur d’une ouverture verticale. En été, les apports peuvent être limités (particulièrement au sud, via une « casquette » architecturale).

Tandis que les apports d’été sont toujours excédentaires au niveau d’une ouverture en toiture.

Seule solution : la décapotable ! Si la coupole ou la verrière peut être largement ouverte en été, le problème peut être résolu. Reste la gestion de la pluie et du vent…

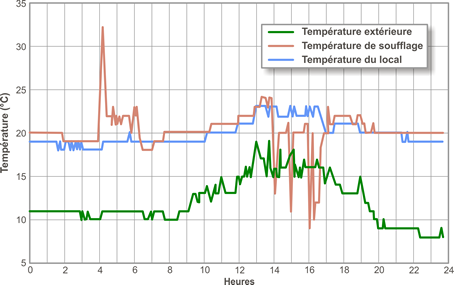

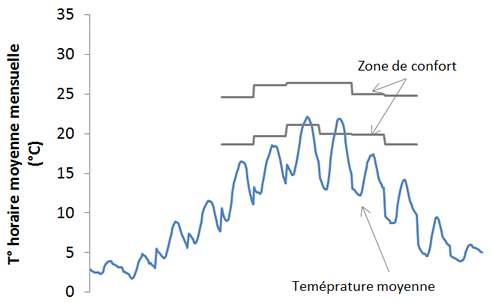

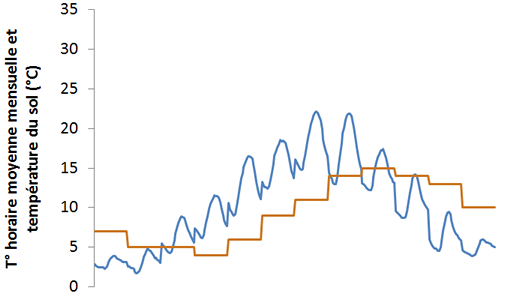

Quelle orientation de la fenêtre latérale ?

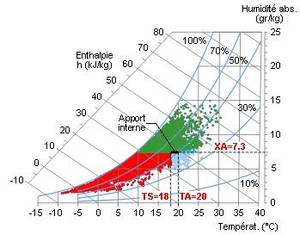

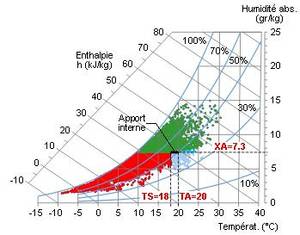

Les pièces orientées au nord bénéficient toute l’année d’une lumière égale et du rayonnement solaire diffus. Il est judicieux de placer des ouvertures vers le nord lorsque le local nécessite une lumière homogène, peu variable ou diffuse, et lorsque les apports internes sont élevés.

Les pièces orientées à l’est profitent du soleil le matin, mais le rayonnement solaire est alors difficile à maîtriser, car les rayons sont bas sur l’horizon. L’exposition solaire y est faible en hiver, mais elle permet d’apporter des gains solaires au moment où le bâtiment en a le plus besoin. Par contre, en été, l’orientation est présente une exposition solaire supérieure à l’orientation sud, ce qui est peu intéressant.

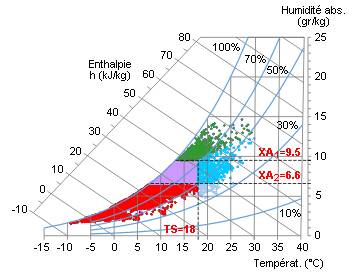

Une orientation ouest présente un risque réel d’éblouissement et les gains solaires ont tendance à induire des surchauffes. En effet, les vitrages tournés vers l’ouest apportent des gains solaires l’après-midi, au moment où le bâtiment est depuis longtemps en régime.

Une orientation sud entraîne un éclairement important. De plus, les pièces orientées au sud bénéficient d’une lumière plus facile à contrôler. En effet, en hiver, le soleil bas (environ 17°) pénètre profondément dans le bâtiment, tandis qu’en été, la hauteur solaire est plus élevée (60°) et la pénétration du soleil est donc moins profonde. En été, les apports solaires sur une surface verticale sont également nettement inférieurs au sud qu’à l’est ou à l’ouest, car ils sont diminués par un facteur égal au cosinus de l’angle d’incidence.

Les dimensions de l’ouverture

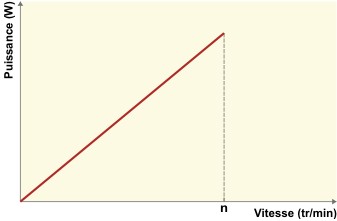

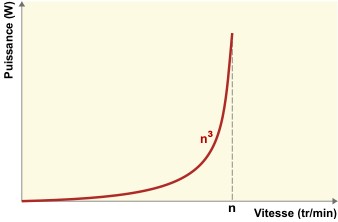

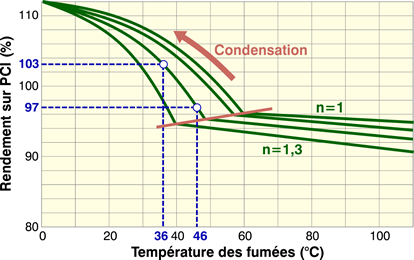

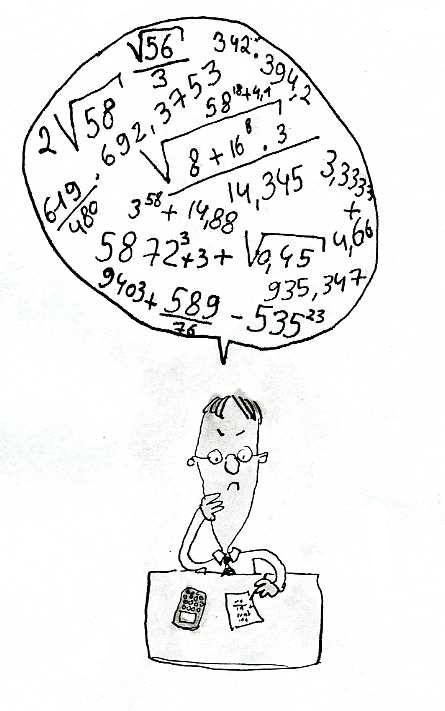

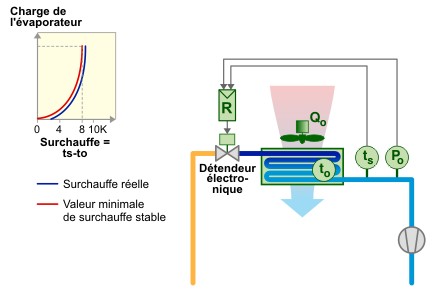

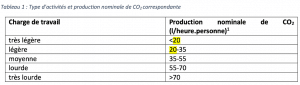

On peut quantifier l’apport de lumière naturelle dans un local par le facteur de lumière du jour (FLJ). Exprimé en %, il exprime le rapport entre l’éclairement intérieur sur le plan de travail dans le local, et l’éclairement extérieur sur le plan horizontal, en site dégagé, par ciel couvert.

Plus le facteur de lumière du jour est élevé, plus le temps d’utilisation des locaux avec la lumière naturelle est élevé, limitant ainsi la consommation d’éclairage artificiel.

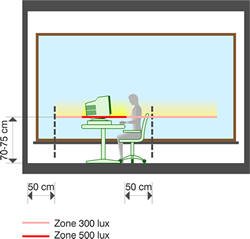

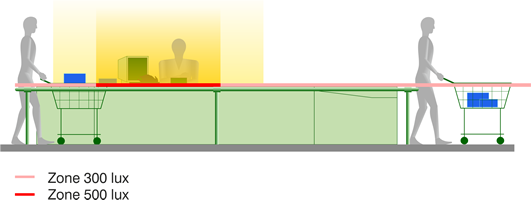

Un objectif raisonnable est d’arriver à un temps d’utilisation de l’éclairage naturel d’au moins 60 %. Ceci entraîne un facteur de lumière du jour de 2,5 (exigence de 300 lux) à 4 % (exigence de 500 lux) dans les locaux de vie, et de 1,5 % dans les circulations et sanitaires (exigence de 100 lux).

Une méthode approchée permet d’évaluer le Facteur de Lumière du Jour moyen d’un local donné, en fonction de sa surface vitrée.

L’emplacement de l’ouverture

Bien sûr, plus la surface est importante, plus l’éclairage naturel est élevé. Mais on sait que les apports solaires augmenteront eux aussi et donc le risque de surchauffe du local. Il nous faut donc optimiser l’efficacité lumineuse de la fenêtre.

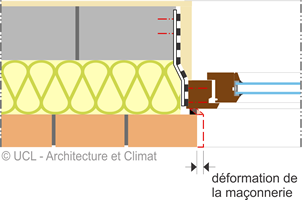

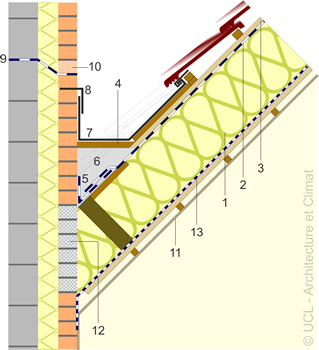

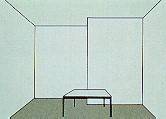

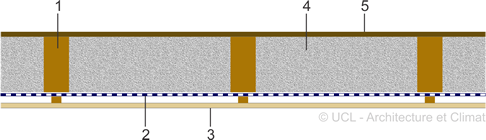

Pour évaluer l’influence de l’emplacement de la fenêtre sur la répartition de la lumière dans un local, nous comparons trois fenêtres identiques, situées à 3 hauteurs différentes.

Plus la fenêtre est élevée, mieux le fond du local est éclairé et plus la zone éclairée naturellement est profonde. Si le fond du local (situé à 7 m de la façade dans notre test) reçoit une valeur de référence 100 pour la fenêtre basse, il recevra 128 pour la fenêtre à mi-hauteur et 143 pour la fenêtre haute.

A surface égale, l’efficacité lumineuse d’une fenêtre est donc maximale au niveau d’un bandeau horizontal, situé en partie supérieure de la paroi.

Une telle fenêtre en hauteur procure les avantages suivants :

- Une répartition très uniforme de la lumière dans l’espace ainsi qu’un bon éclairage du fond du local.

- Une source de lumière au-dessus de la ligne de vision, ce qui réduit les risques d’éblouissement direct.

Cependant, le seuil se trouve au-dessus du niveau de l’oeil, la vue sur l’extérieur est impossible. La fenêtre ne peut jouer son rôle de lien entre un local et son environnement. De plus, une zone d’ombre est formée à proximité du mur de fenêtre. En général, il est préférable de coupler une telle fenêtre avec une fenêtre classique, équipée de protections solaires.

Pour maximiser les apports de lumière naturelle, on peut également interrompre un faux plafond à proximité de la fenêtre pour favoriser la pénétration de la lumière naturelle par cette ouverture. Ce procédé est connu sous le nom de « plafond biaisé ».

De cette étude, on peut déduire une autre conclusion très intéressante : c’est la zone inférieure d’une fenêtre qui est la moins efficace en matière d’éclairage naturel. La présence d’une allège opaque est donc thermiquement préférable (présence d’une isolation pour diminuer les pertes en hiver et opacité vis-à-vis des apports solaires).

La forme de la fenêtre

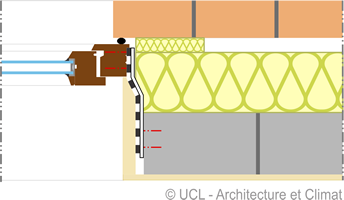

Analysons l’influence de la forme de la fenêtre en comparant la répartition lumineuse fournie par trois fenêtres de proportions différentes, pour une surface vitrée identique et une hauteur de l’allège constante.

Lorsque la largeur de la fenêtre diminue, la répartition devient moins uniforme, bien que l’éclairement moyen soit pratiquement le même dans les trois cas étudiés. Par contre, l’éclairement du fond du local augmente avec la hauteur de la fenêtre. Pour une même surface vitrée, une fenêtre haute éclaire davantage en profondeur. L’idéal réside donc dans une fenêtre horizontale, mais dont le linteau est élevé. En première approximation, une pièce est convenablement éclairée jusqu’à une profondeur de 2 à 2,5 fois la hauteur du linteau de la fenêtre par rapport au plancher.

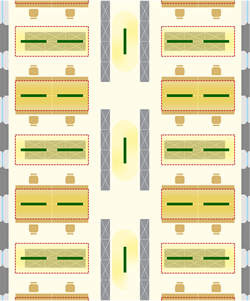

Analysons l’influence de la répartition des ouvertures dans une façade : comparons la grande fenêtre centrée et deux fenêtres plus petites, placées symétriquement.

Dans les deux cas, les fenêtres ont une superficie vitrée totale identique et la même hauteur; leur allège est située au même niveau par rapport au sol. La moyenne des éclairements varie peu, mais la répartition de la lumière dans la partie du local avoisinant les fenêtres est différente. Dans le cas de deux fenêtres séparées, une zone d’ombre apparaît entre celles-ci, ce qui peut créer des problèmes de confort visuel pour les occupants.

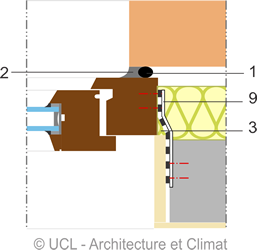

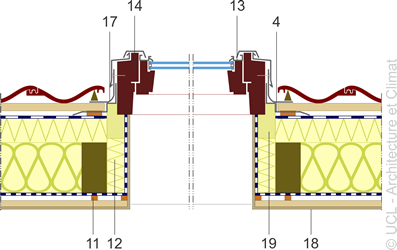

Le type de châssis

Le type et la taille du châssis modifient la vue vers l’extérieur et la quantité de lumière admise dans un édifice.

Le châssis fixe sera sans conteste le plus mince mais il empêche le plaisir du contact direct avec l’air extérieur…

Le matériau utilisé pour le châssis détermine également son encombrement : en général, un châssis en bois est plus mince qu’un cadre en aluminium à coupure thermique. Les châssis en PVC sont les plus larges.

Mais les innovations récentes permettent de plus en plus de diminuer l’impact visuel des châssis et d’augmenter ainsi la quantité de lumière captée.

Cafétéria dans un lycée.

Valoriser l’éclairage naturel capté

Les dimensions du local

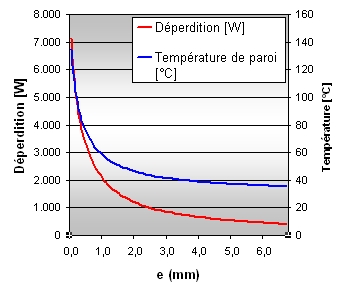

La profondeur du local ne devra pas dépasser le double de la hauteur du linteau de la fenêtre, puisque l’intensité de la lumière naturelle décroît très rapidement en fonction de l’éloignement de la fenêtre.

Ainsi, la profondeur des bureaux devrait être limitée à 6 mètres.

À noter qu’une variation de la hauteur sous plafond (pour une même baie vitrée et une surface de plancher identique) induit une très faible différence dans la répartition lumineuse du local. Le niveau d’éclairement est cependant un petit peu plus élevé dans les pièces ayant un plafond plus bas.

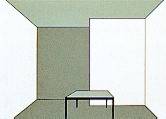

La réflexion sur les parois

La nature et la couleur des surfaces intérieures influencent directement l’éclairage naturel dû aux réflexions intérieures. Une bonne distribution de la lumière nécessite des parois et du mobilier de couleurs claires.

L’importance de la clarté des surfaces est due à un double effet

- les facteurs de réflexion plus élevés permettent à la lumière d’être davantage réfléchie.

- l’œil humain analyse des niveaux de luminance : sous les mêmes conditions d’éclairage, une surface claire est donc subjectivement perçue comme mieux éclairée qu’une surface foncée.

On peut dire que si le facteur de réflexion moyen des murs d’un volume quelconque est inférieur à 50 %, la lumière pénétrera difficilement en profondeur dans cet espace. Or la plupart des matériaux architecturaux ont de faibles facteurs de réflexion. Un plancher clair peut avoir un facteur de réflexion de 30 %, mais pas beaucoup plus, ce qui est nettement plus bas que les murs (~ 50 % ) et que les plafonds (~ 70 %).

Dès lors, pour favoriser la pénétration de la lumière dans un local, on adoptera un revêtement du sol et du mobilier relativement clair, possédant donc un facteur de réflexion élevé. De plus, la clarté des tables de travail s’avère un élément favorable au confort visuel dans la mesure où la réduction du contraste entre le papier et le support de la table induit une diminution des efforts d’accommodation que l’œil doit effectuer à chacun de ses mouvements.

En revanche, les sols sont souvent de couleur relativement sombre afin de faciliter leur entretien. Il faut donc envisager un compromis susceptible de satisfaire simultanément les exigences de confort et de maintenance.

Comme le plafond ne reçoit la lumière naturelle que de manière indirecte, son influence sur la répartition de la lumière est relativement faible. En revanche, lorsqu’un dispositif de distribution lumineuse dévie la lumière vers le haut, par exemple à l’aide d’un light shelf, le plafond reçoit une grande quantité de lumière qu’il doit répartir dans toute la pièce; le facteur de réflexion de cette surface doit alors être élevé (> 70 %), valeur correspondant à celle du plâtre blanc propre.

Lorsque les matériaux de revêtement présentent une certaine brillance, la lumière arrive plus facilement en fond de pièce.

En contrepartie, les surfaces en question acquièrent une luminance élevée et peuvent donc devenir des sources d’éblouissement.

De manière générale, les surfaces brillantes sont donc à conseiller comme moyen de transmission de la lumière naturelle, mais elles sont à éviter dans les locaux de travail, dans la mesure où les activités (lecture, écriture,…) peuvent être perturbées lorsque l’environnement lumineux est fort contrasté.

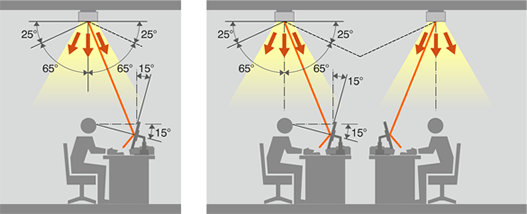

Distribuer l’éclairage dans les locaux

L’inconvénient de la lumière naturelle par rapport à la lumière artificielle réside dans la grande inhomogénéité des éclairements qu’elle induit. La répartition de la lumière représente donc un facteur clef pour assurer un éclairage de qualité.

Un éclairage naturel direct engendre des risques importants d’éblouissement et entraîne une répartition des luminances très irrégulière dans le local.

L’éclairage naturel indirect utilise les réflexions des rayons lumineux sur une paroi pour obtenir une distribution lumineuse plus homogène. Cependant, le niveau d’éclairement assuré dépend fortement du coefficient de réflexion de la paroi et donc de sa maintenance régulière.

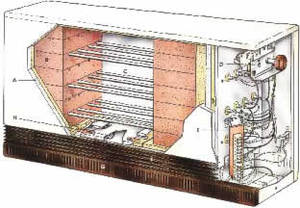

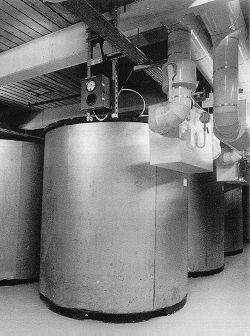

Le Kimbell Art Museum, conçu par L. Kahn, renferme un exemple d’éclairage naturel indirect fabuleux.

De longs plafonds cylindriques laissent pénétrer la lumière naturelle en leur centre grâce à un système filtrant et réfléchissant, qui redirige la lumière solaire éclatante du Texas sur les voûtes du musée.

L’aménagement des parois intérieures

La distribution de l’éclairage dépend aussi de l’organisation des espaces intérieurs. Utiliser des cloisons transparentes ou translucides permet à la lumière de se répandre dans les deux pièces séparées par la surface vitrée. À l’intérieur d’un bâtiment, l’architecte est tributaire des effets de lumière qui se créent : il dote les espaces intérieurs de l’atmosphère désirée par une disposition étudiée des ouvertures et des obstacles à la lumière. Par exemple, un local disposé à l’est peut, par le truchement des baies intérieures, recevoir un peu de lumière de l’ouest.

Dans un long couloir, la présence de fenêtres translucides donne un relief agréable et permet d’éviter l’éclairage artificiel (bandes verticales à côté des portes ou impostes au-dessus des portes).

Les meubles sont parfois de réels obstacles qui empêchent la transmission de la lumière vers certaines parties de la pièce. Il est donc essentiel de réfléchir au type de meubles, ainsi qu’à leur emplacement, de manière à favoriser la pénétration de la lumière naturelle.

Ces deux modes d’éclairage peuvent aussi être combinés pour créer un éclairage direct/indirect, alliant une ouverture directe à la lumière naturelle à un système d’éclairage indirect. Un exemple de ce type d’éclairage est une façade qui unit une fenêtre normale et un light shelf. Ce mode d’éclairage possède, en général, les avantages de l’éclairage indirect, mais la partie directe permet en plus de créer des ombres, qui mettent en valeur le relief des objets. D’autre part, la maintenance des coefficients de réflexion des parois est un peu moins critique vu qu’une partie de l’éclairage entre de manière directe dans l’espace.

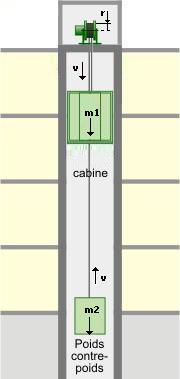

Gérer l’éclairage artificiel en fonction de l’éclairage naturel

Force est de constater que les occupants d’un bâtiment tertiaire sont peu motivés à éteindre leurs luminaires, même si l’éclairage naturel est suffisant. De plus, la modulation ON-OFF n’est pas souple et provoque un choc psychologique lors de l’extinction.

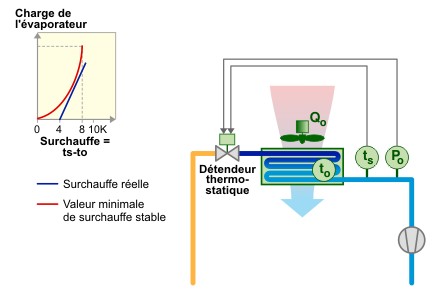

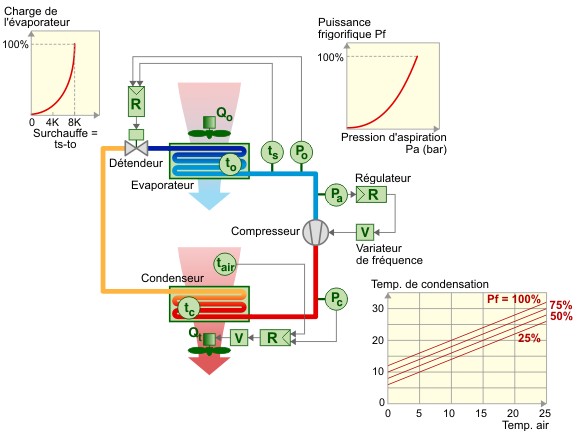

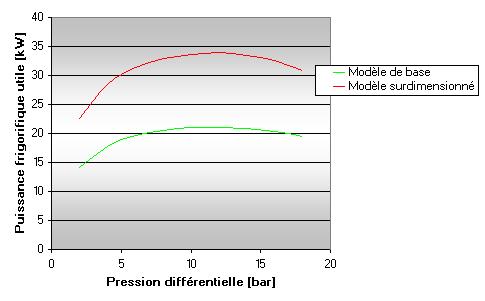

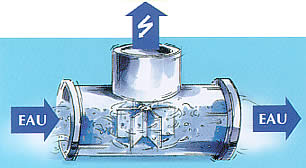

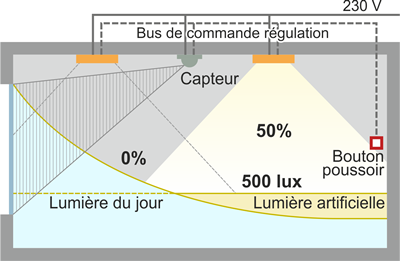

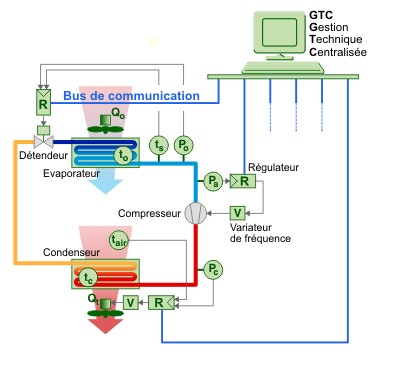

Par exemple, il est possible aujourd’hui de placer une cellule sensible à l’intensité lumineuse en dessous du luminaire. Si, en présence de soleil, celle-ci dépasse les 500 Lux souhaités, l’alimentation électrique du luminaire est automatiquement réduite. Sans que l’occupant ne s’en rende compte, l’éclairage naturel est directement valorisé. C’est « la vanne thermostatique » du luminaire !

| Pour plus d’informations sur la mise en place d’une technique de gestion de l’éclairage artificiel. |

Renforcer l’éclairage naturel à l’intérieur du bâtiment

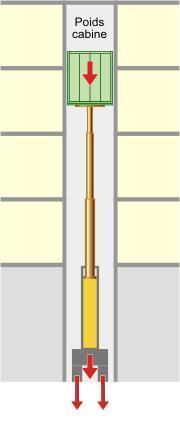

Le puits de lumière

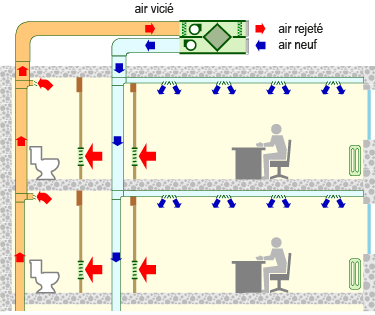

Certaines zones centrales dans un bâtiment n’ont pas d’accès direct à la lumière du jour. Dès lors, un conduit de lumière, passant à travers différentes pièces, permet de répandre la lumière naturelle captée en toiture ou en façade dans ces locaux aveugles.

Signalons toutefois que les puits de lumière risquent d’occuper un assez grand volume dans le bâtiment. Leur surface interne doit être d’autant plus réfléchissante que la lumière naturelle doit être amenée profondément dans le bâtiment. Pour limiter au maximum les pertes par absorption, il faut utiliser des matériaux très performants au niveau photométrique.

Architecte : M. Botta.

Utilisation du verre

dans des éléments de sol ou d’escalier.

Si le puits de lumière prend de plus larges dimensions, on parle d’atrium. Sa gestion thermique est souvent difficile (refroidissement par la surface vitrée en hiver, surchauffe par l’excès d’apports solaires en été). Un équilibre dans le degré d’ouverture doit donc être trouvé pour favoriser l’éclairage des pièces centrales, tout en évitant un déséquilibre thermique … coûteux en climatisation !

Exemple d’un atrium bien dimensionné.

Au Lycée Vinci de Calais, une dynamique est donnée par les 3 ouvertures : bandeau lumineux sur toute la longueur, coupole en toiture, pignons vitrés aux deux extrémités.

Si toute la toiture avait été ouverte, l’énergie incidente aurait entraîné des surchauffes en été.

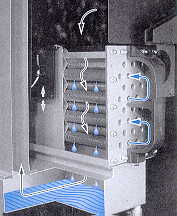

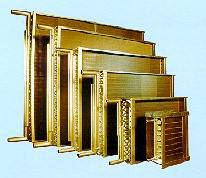

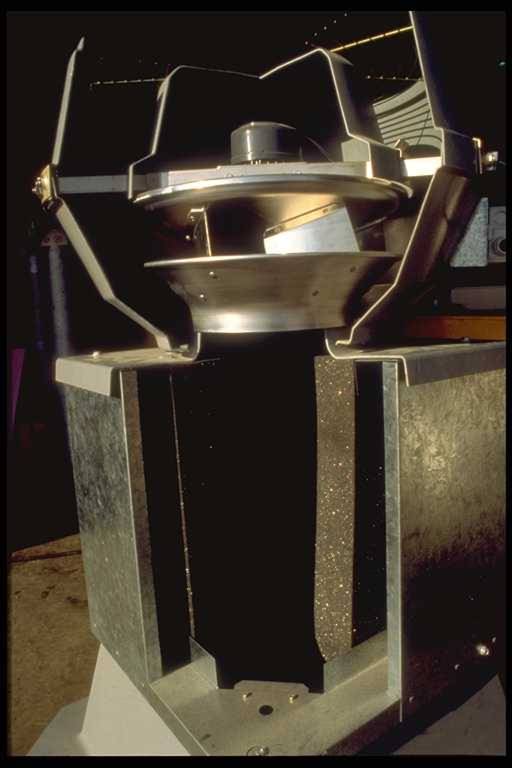

Le conduit solaire

Un conduit solaire transmet la lumière solaire directe au cœur même du bâtiment. Le rayonnement solaire est capté au moyen d’un système de miroirs et de lentilles ou de capteurs paraboliques, éléments qui se meuvent en fonction de la trajectoire du soleil. La transmission du rayonnement solaire se fait par des systèmes de miroirs, de lentilles, de prismes réflecteurs, de fibres optiques, de baguettes acryliques, de fluides de cristaux liquides ou des conduits creux, dont les faces intérieures sont recouvertes de métaux polis. Les faisceaux lumineux ainsi obtenus peuvent alors être dirigés sur une surface précise ou diffusés dans l’espace.

Ce conduit, beaucoup moins volumineux qu’un puits de lumière, peut facilement atteindre une longueur de 15 mètres. Il est parfois associé à un puits de lumière.

Le conduit solaire apporte un flux lumineux nettement plus important et plus concentré que le puits de lumière. Cependant, tous ces systèmes de gestion du rayonnement solaire direct sont relativement chers à installer et s’appliquent donc plus particulièrement aux régions fortement ensoleillées.

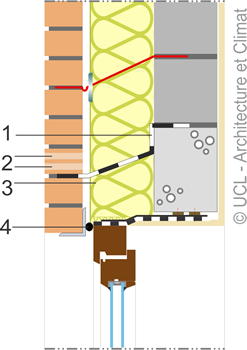

Le « light shelf »

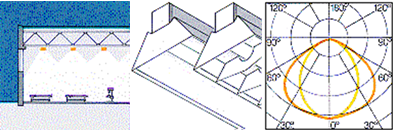

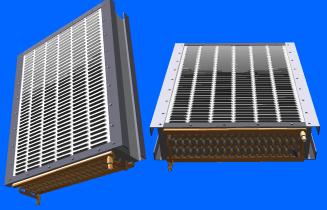

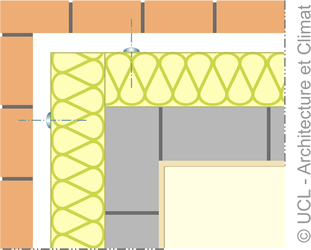

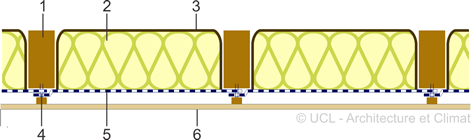

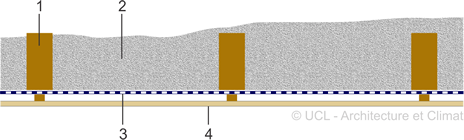

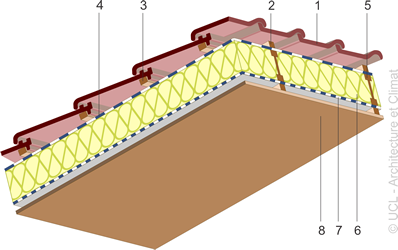

Un light shelf est un auvent, dont la surface supérieure est réfléchissante.

L’objectif est double

- Rediriger la lumière naturelle vers le plafond, ce qui permet de faire pénétrer la lumière profondément dans la pièce.

- Protéger l’occupant des pénétrations directes du soleil (éblouissement et rayonnement direct).

La surface du light shelf doit être aussi réfléchissante que possible, mais peut-être mate, brillante ou spéculaire. Une surface spéculaire renvoie théoriquement plus de lumière, mais il faut pour cela qu’elle soit nettoyée très régulièrement, ce qui n’est pas toujours aisé. En pratique, un light shelf brillant (semi-spéculaire) est sans doute le meilleur choix.

La couleur du plafond doit être aussi claire que possible, car il joue le rôle de distributeur de la lumière naturelle réfléchie par le light shelf. Sa pente a également de l’importance : un plafond incliné vers le fond du local ou de forme arrondie incurvée vers l’intérieur de l’espace augmentera fortement la profondeur de pénétration de la lumière dans le local.

Architecte : Michael Hopkins and Partners.

Dans nos régions, il est surtout applicable pour des locaux profonds d’orientation sud. Ses performances sont fortement réduites pour des orientations est et ouest, pour lesquelles le rayonnement solaire a un angle d’incidence plus faible.

De manière relative, plus le local est sombre, plus l’apport d’un light shelf peut être intéressant. Si la composante réfléchie interne est déjà grande dans un local, le même système sera proportionnellement moins efficace. L’emploi d’un light shelf en rénovation sera particulièrement profitable dans les pièces dont les murs ont des coefficients de réflexion faibles et un mobilier foncé (à noter qu’il sera moins cher de commencer par repeindre les murs !).

Le choix de la meilleure configuration de light shelf résulte d’un équilibre entre les demandes d’éclairage naturel et les besoins d’ombrage d’un local.

Un light shelf est habituellement situé à environ deux mètres de hauteur, divisant la fenêtre de façade en deux parties. Sa position dépend de la configuration de la pièce, du niveau des yeux et de la hauteur sous plafond pour permettre une vue vers l’extérieur et ne pas causer d’éblouissement. Une position basse augmente la quantité de lumière réfléchie vers le plafond … mais accroît les risques d’éblouissement.

L’augmentation de la profondeur du light shelf limite l’éblouissement, mais diminue aussi la pénétration de la lumière et la vue vers l’extérieur. Le light shelf, affectant la conception architecturale et structurelle d’un édifice, est de préférence introduit au début de la phase de conception puisqu’il nécessite un plafond relativement haut pour être efficace.

Les light shelves horizontaux sont un bon compromis entre une inclinaison du système vers le centre de la pièce ou vers l’extérieur. Tournée vers l’extérieur, le light shelf crée un plus grand ombrage, mais tournée vers l’intérieur il éclaire mieux le fond de la pièce.

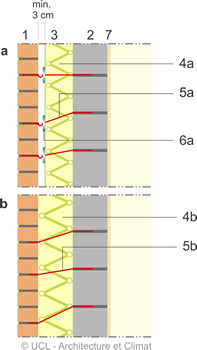

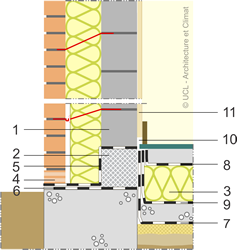

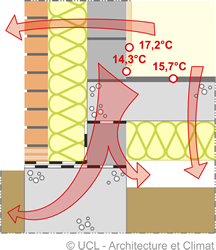

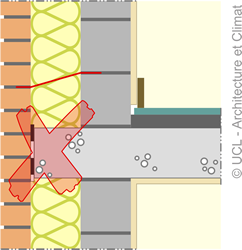

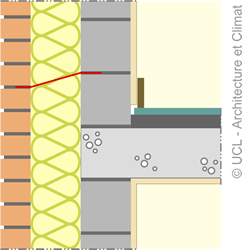

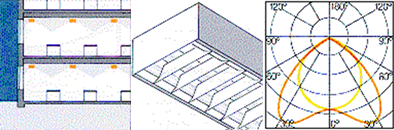

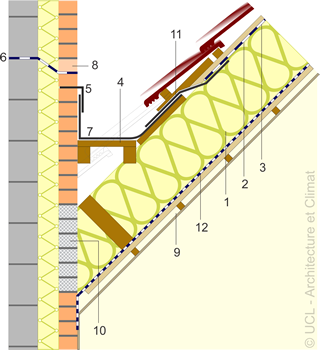

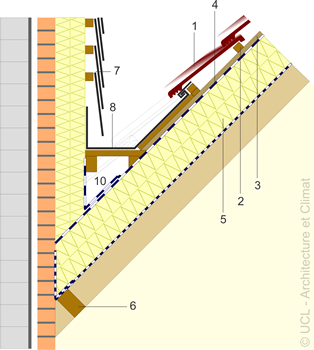

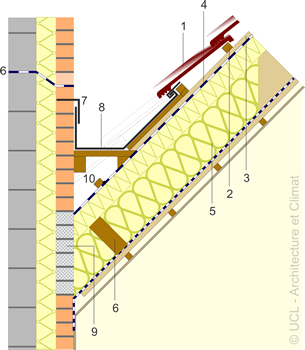

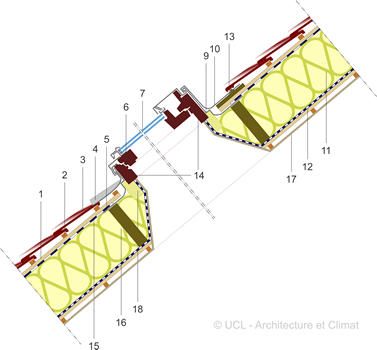

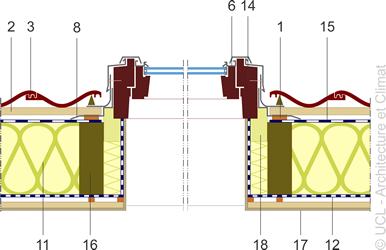

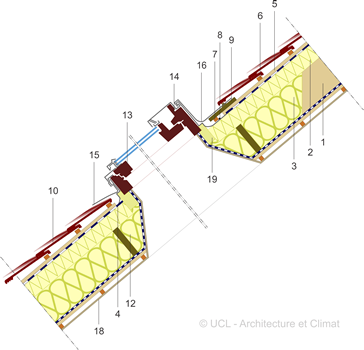

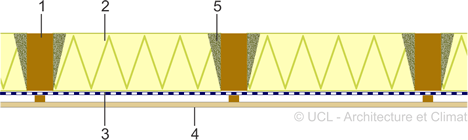

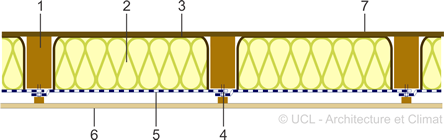

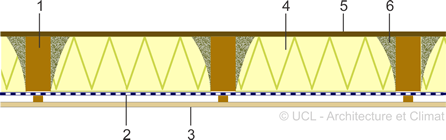

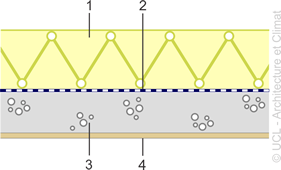

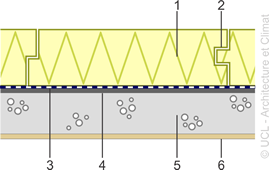

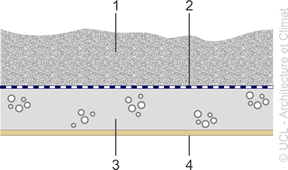

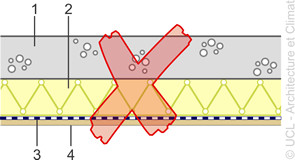

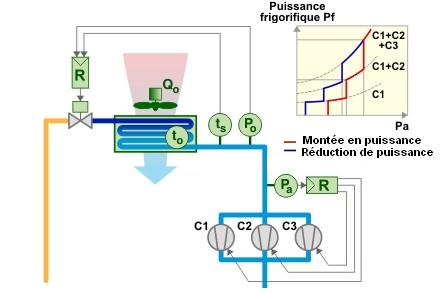

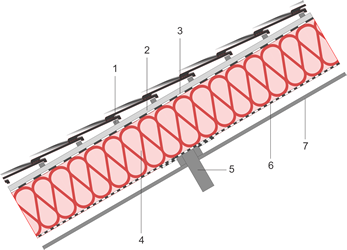

On peut classer un light shelf selon sa position : intérieur, extérieur ou combiné.

Ainsi que le montre les simulations de l’éclairage d’un local, sans et avec light shelf,

- Le light shelf extérieur donne les meilleurs résultats du point de vue du niveau d’éclairement en fond de pièce, tout en ombrant la grande fenêtre.

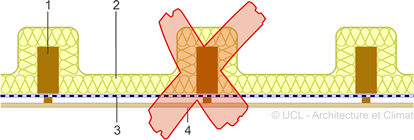

- Placé à l’intérieur, il réduit le niveau d’éclairement moyen du local, mais offre toutefois un ombrage pour la partie supérieure du vitrage.

- Enfin, le light shelf combiné assure la distribution lumineuse la plus uniforme dans le local; il se révèle également la meilleure protection solaire.

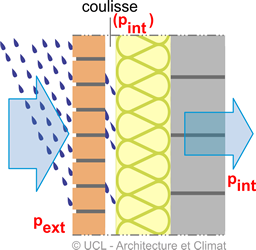

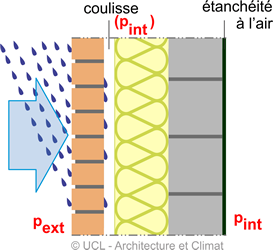

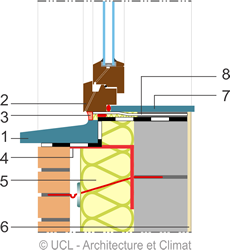

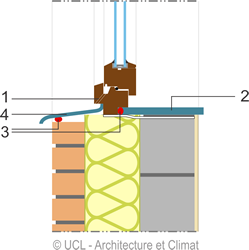

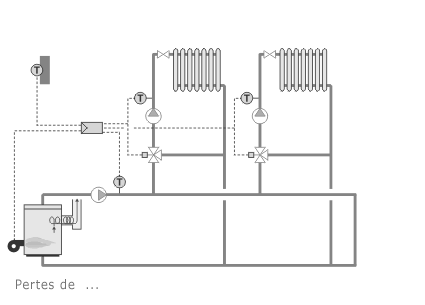

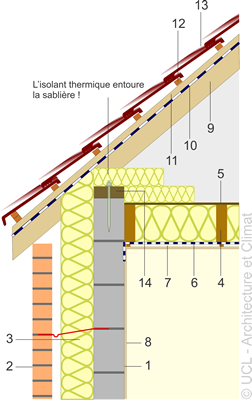

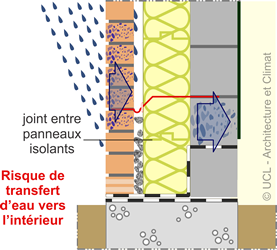

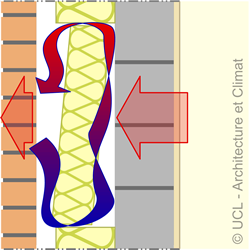

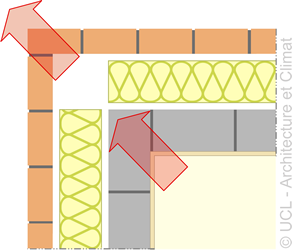

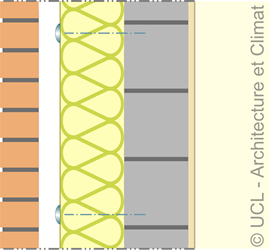

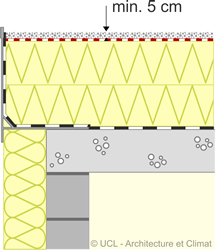

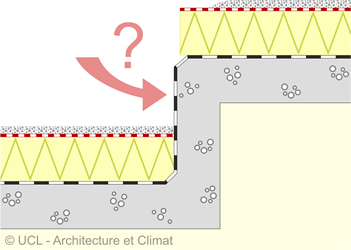

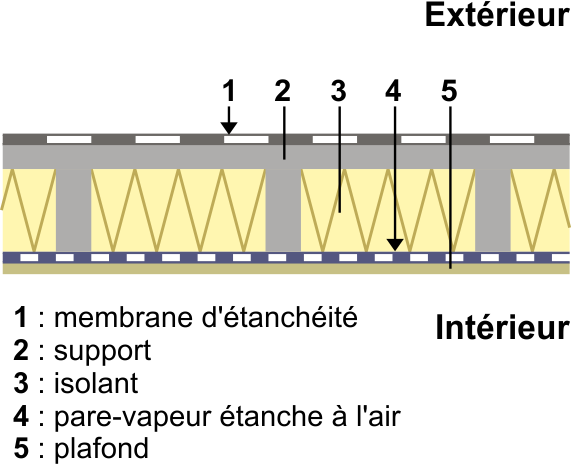

l’étanchéité à l’eau,

l’étanchéité à l’eau,