Impacts environnementaux : focus sur les fenêtres

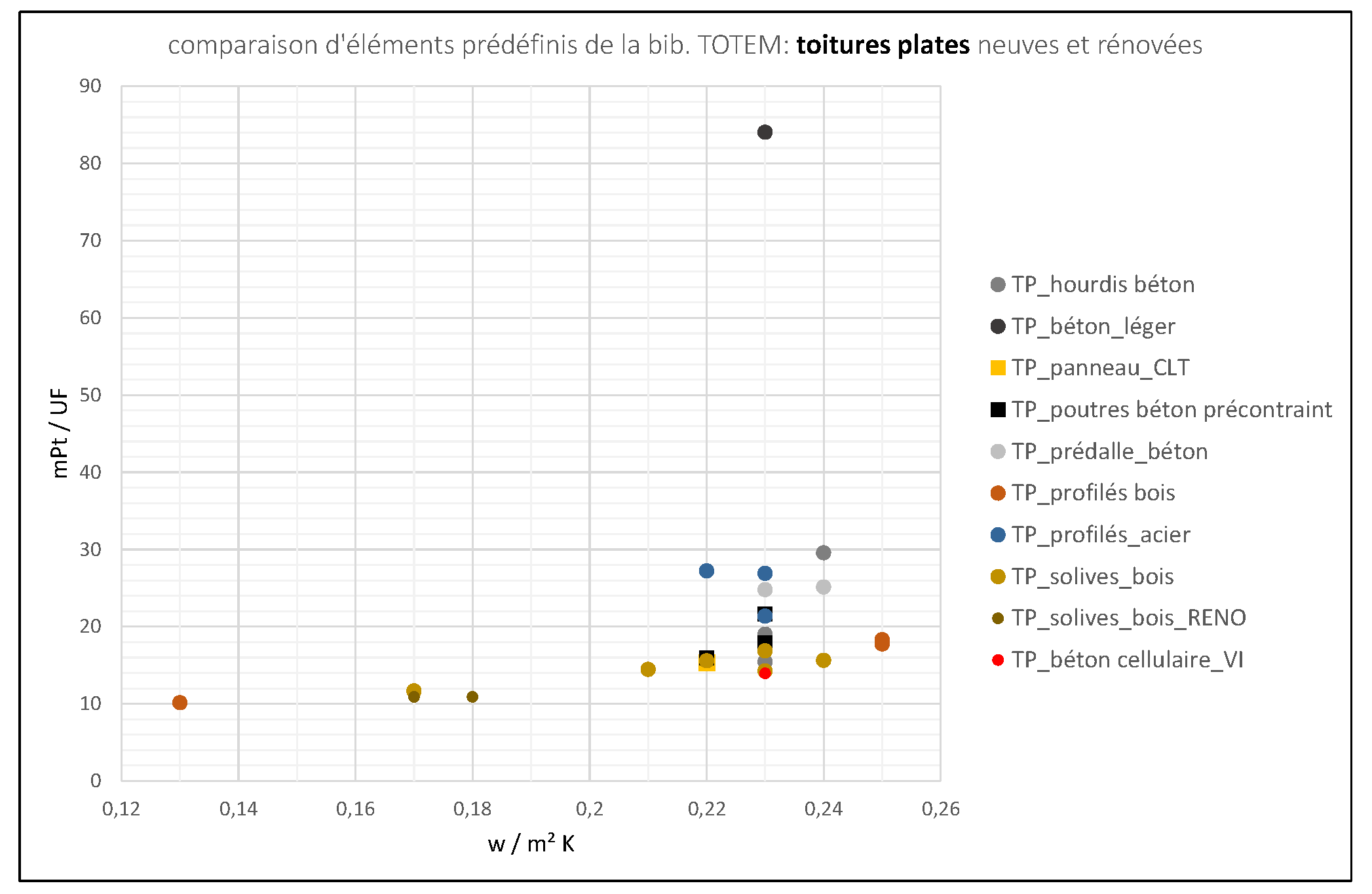

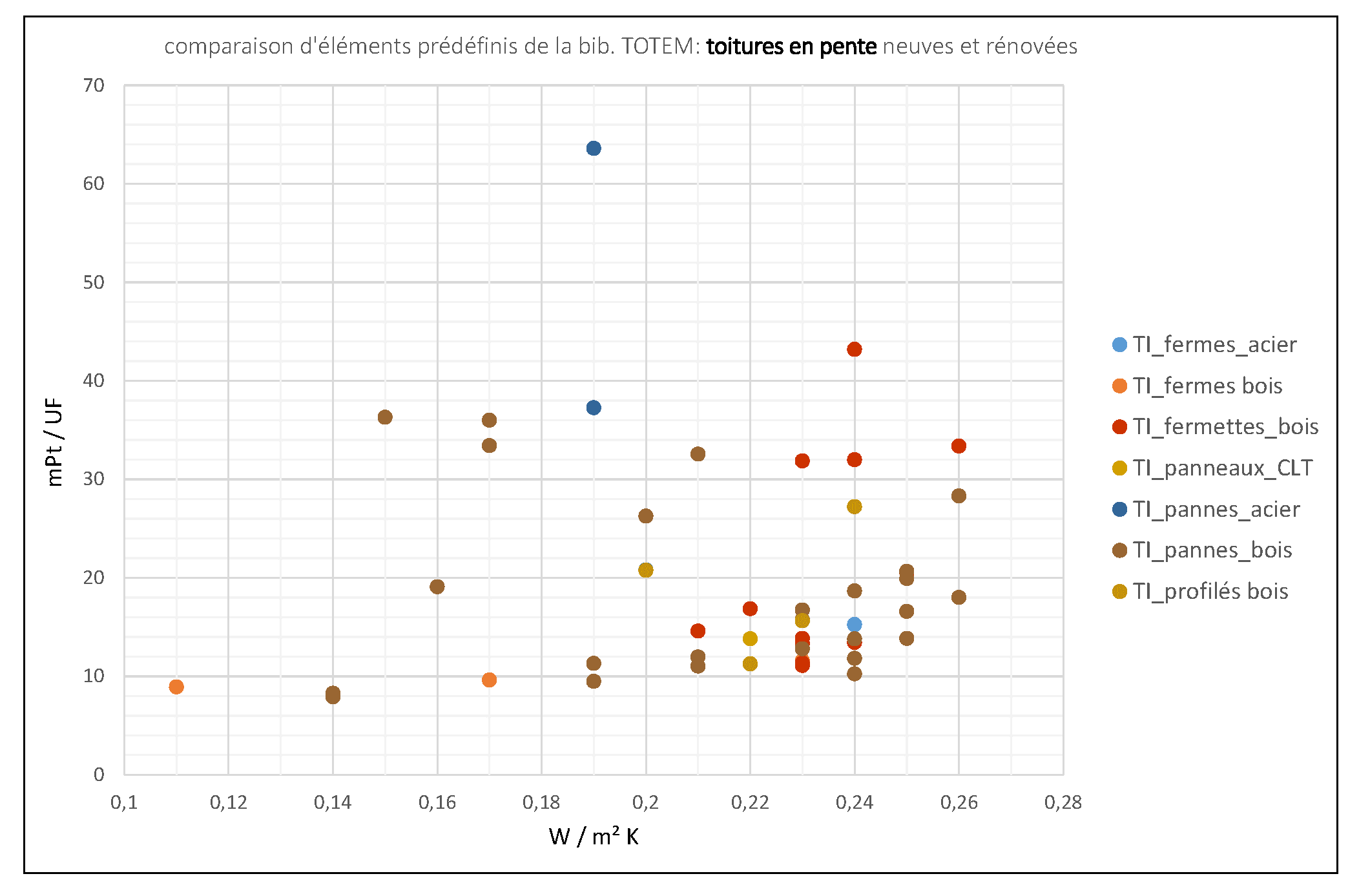

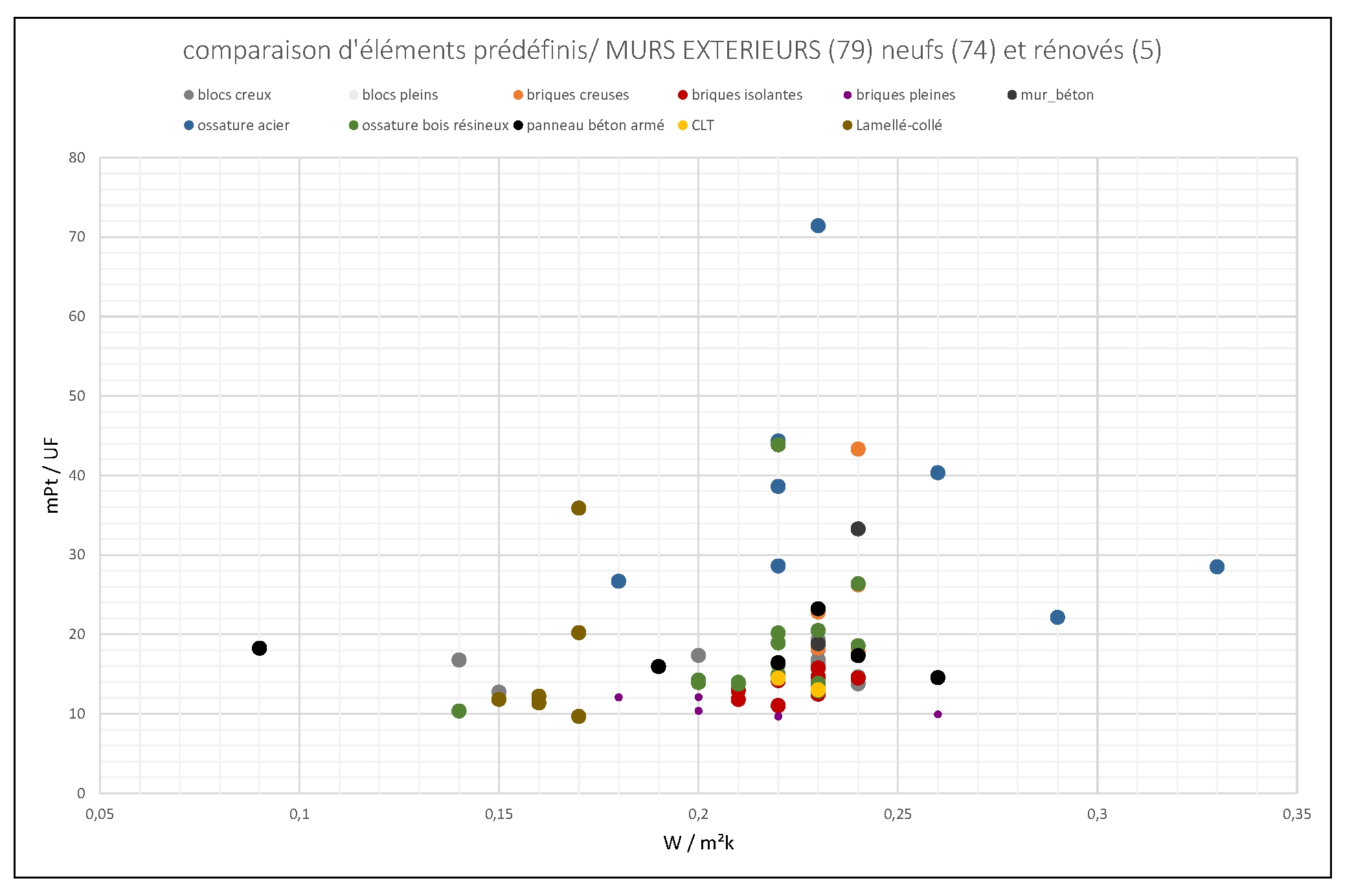

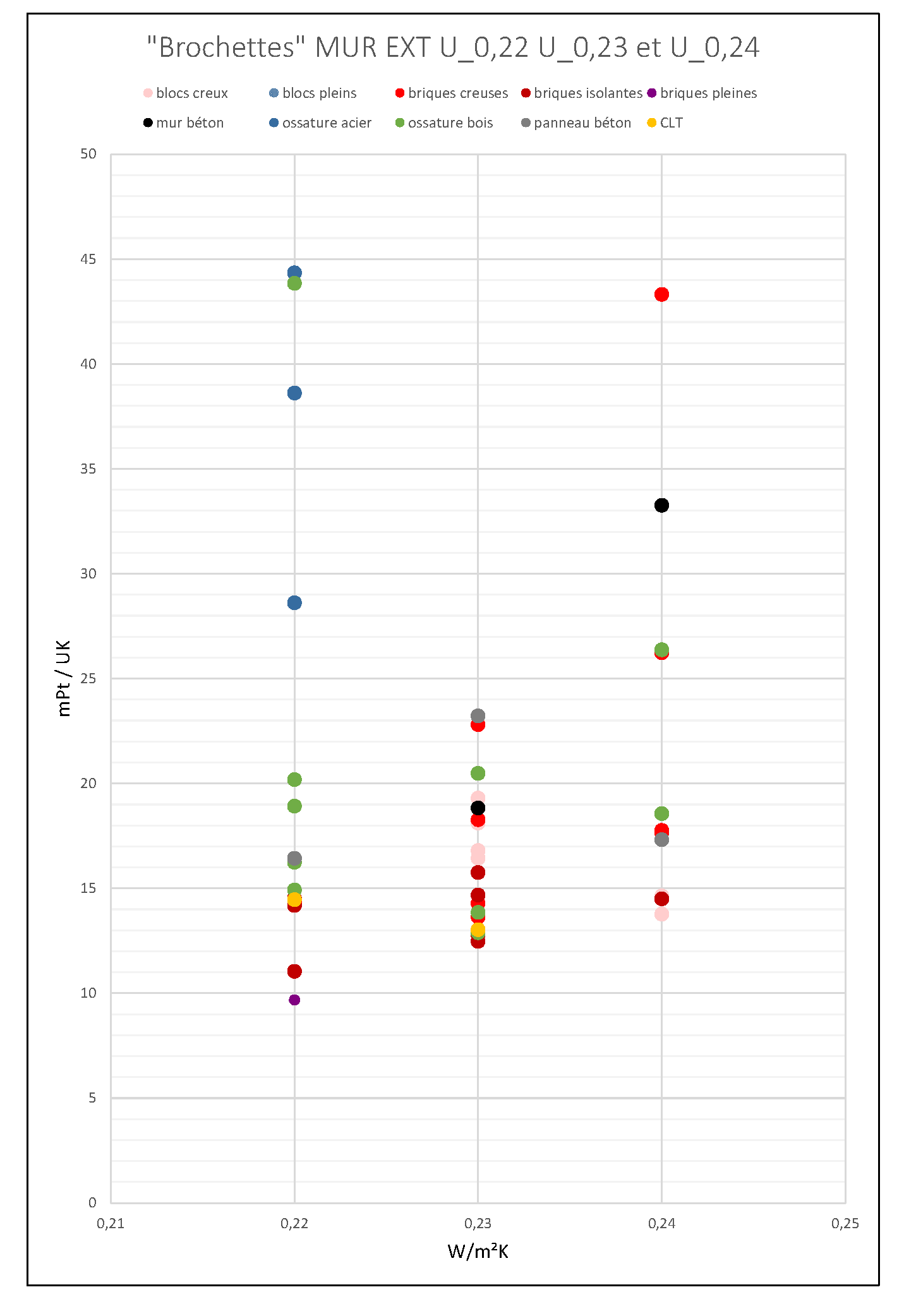

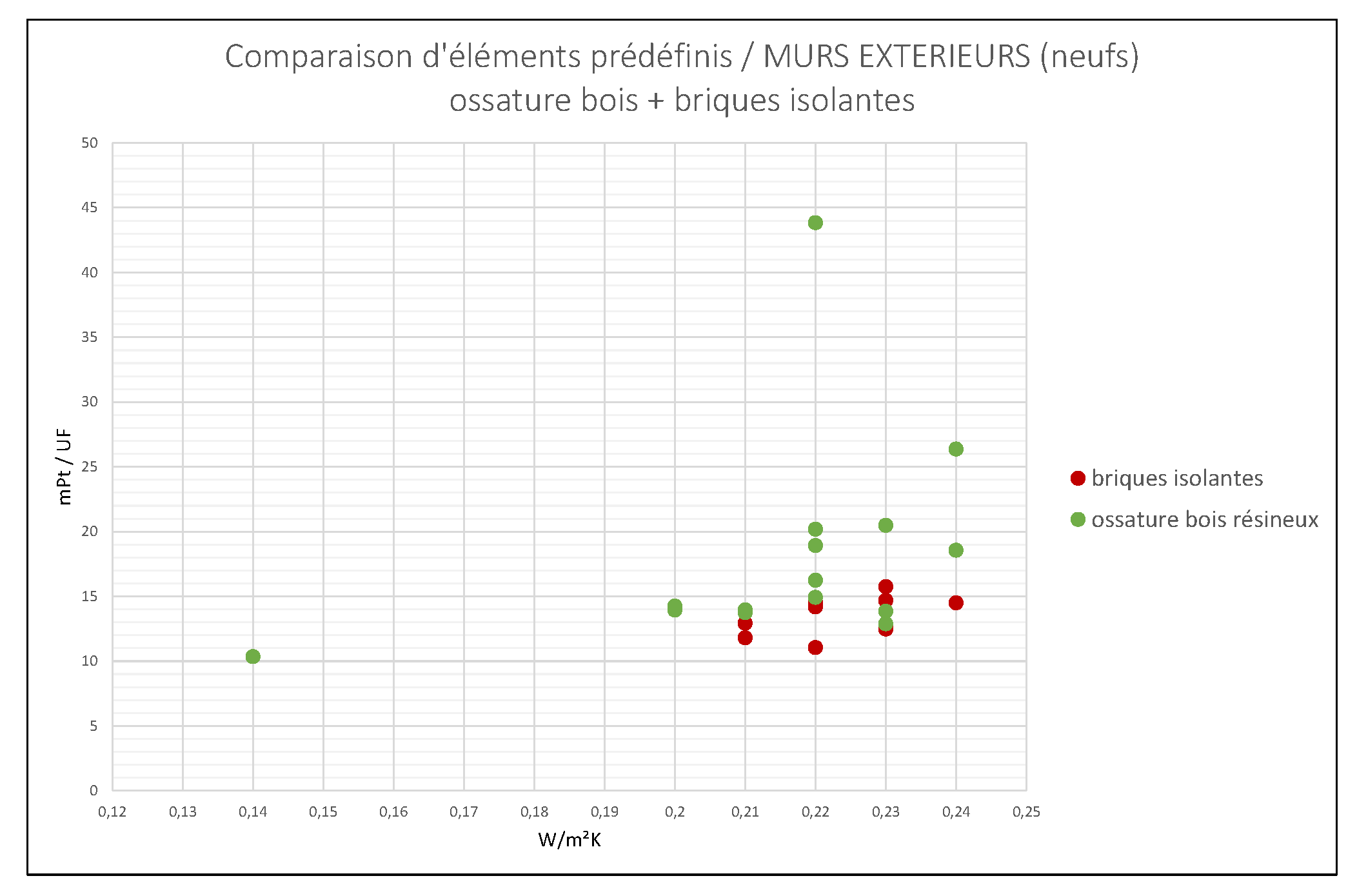

Dans cette page, nous proposons une comparaison des impacts environnementaux des parois reprises dans la bibliothèque de TOTEM durant l’été 2023, afin d’identifier de bonnes pratiques en termes de choix constructifs. En particulier, nous nous intéressons aux toitures.

Recommandations avant comparaison:

Ca change vite

Les bibliothèques TOTEM s’enrichissent régulièrement, les EPD (déclaration environnementale de produit) se multiplient… L’exercice fait ici est donc vrai pour en un temps t, et l’analyse peut changer rapidement. Cependant, puisqu’il ne s’agit pas de trouver un « meilleur élève », mais d’identifier des tendances, l’exercice vaut la peine.

Travailler à l’échelle de l’élément

Totem préconise la comparaison à partir du niveau hiérarchique correspondant aux éléments, de façon à considérer matériaux mis en œuvre ! En effet, si l’on comparait par exemple deux matériaux non mis en œuvre (deux isolants par exemple), on négligerait l’impact des matériaux additionnels nécessaires à celle-ci (fixation, mortier éventuel,…), et l’on pourrait mal estimer la durée de vie des matériaux, qui elle aussi peut dépendre des conditions de mise en œuvre .

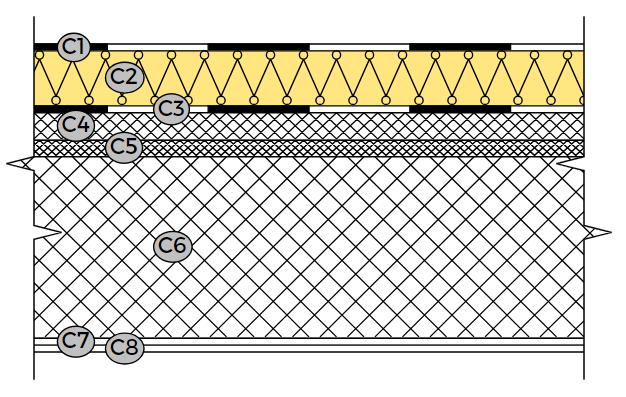

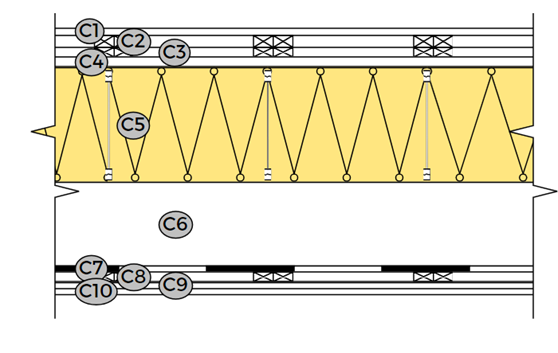

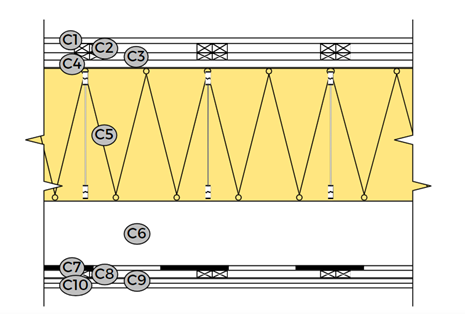

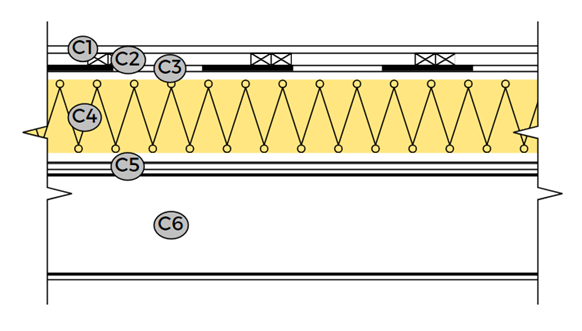

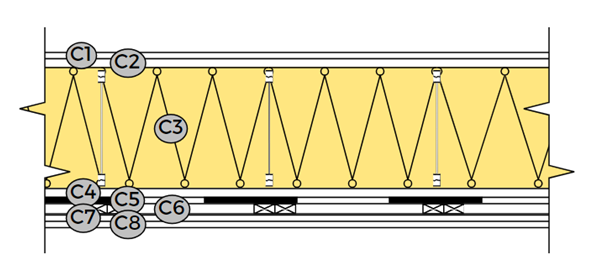

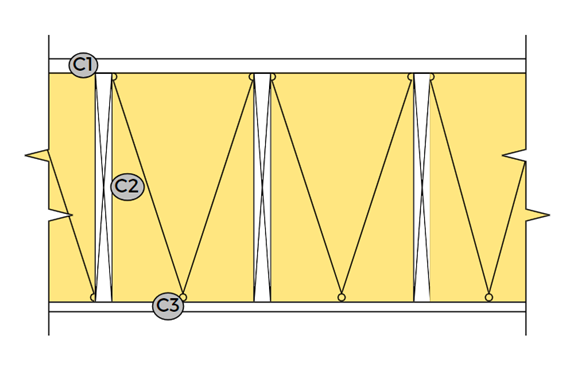

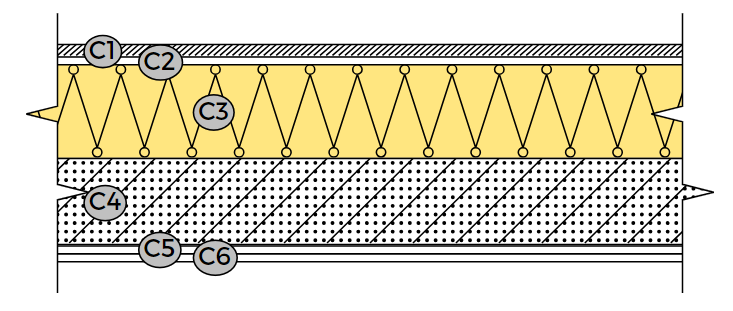

Nous travaillons donc ici sur base des bibliothèques d’éléments prédéfinis dans TOTEM (planchers, murs, toitures,…). Il s’agit donc de bien de discuter de complexes multicouches, et non de matériaux individuellement.

Peut-on comparer des éléments n’ayant pas la même valeur U ?

L’impact environnemental de l’énergie consommée durant la phase d’utilisation de l’élément est pris en compte dans le score environnemental global. Une telle comparaison est donc possible, pour autant que l’on s’en tienne à une comparaison de l’impact sur l’ensemble des étapes du cycle de vie. Cela n’aurait évidemment aucun sens de comparer uniquement la phase de fabrication de parois n’ayant pas la même performance thermique.

Précisons cependant que la méthode de calcul utilisée pour l’évaluation de l’énergie consommée « in use » est discutable car relativement simpliste (méthode des degrés jours), et que l’impact de cette énergie n’est pas le même selon le type de système énergétique considérée (chauffage gaz ? pompe à chaleur ?). Les comparaisons qui sont faite sont donc à nuancer et contextualiser.

Peut-on comparer des éléments n’ayant pas la même durée de vie ?

Si l’on travaille à l’échelle des éléments, TOTEM uniformise les durées de vie à 60 ans, en intégrant un rythme de remplacement des éléments qui ne vivraient pas autant. La comparaison est donc possible.

Si vous voulez en savoir plus sur les hypothèses de calcul de TOTEM, dont la durée de vie, nous vous recommandons la video ci-dessous :

Peut-on comparer des élément n’ayant pas le même statut (Neuf ><Réno) ?

Oui et non. Il est intéressant de regrouper ces deux type d’éléments, pour mettre en évidence l’intérêt relative de la conservation d’éléments ou de composants existants. Mais une fois cela établi, c’est la comparaison d’éléments similaires qui a le plus d’intérêt pratique.

Vue générale sur les fenêtres

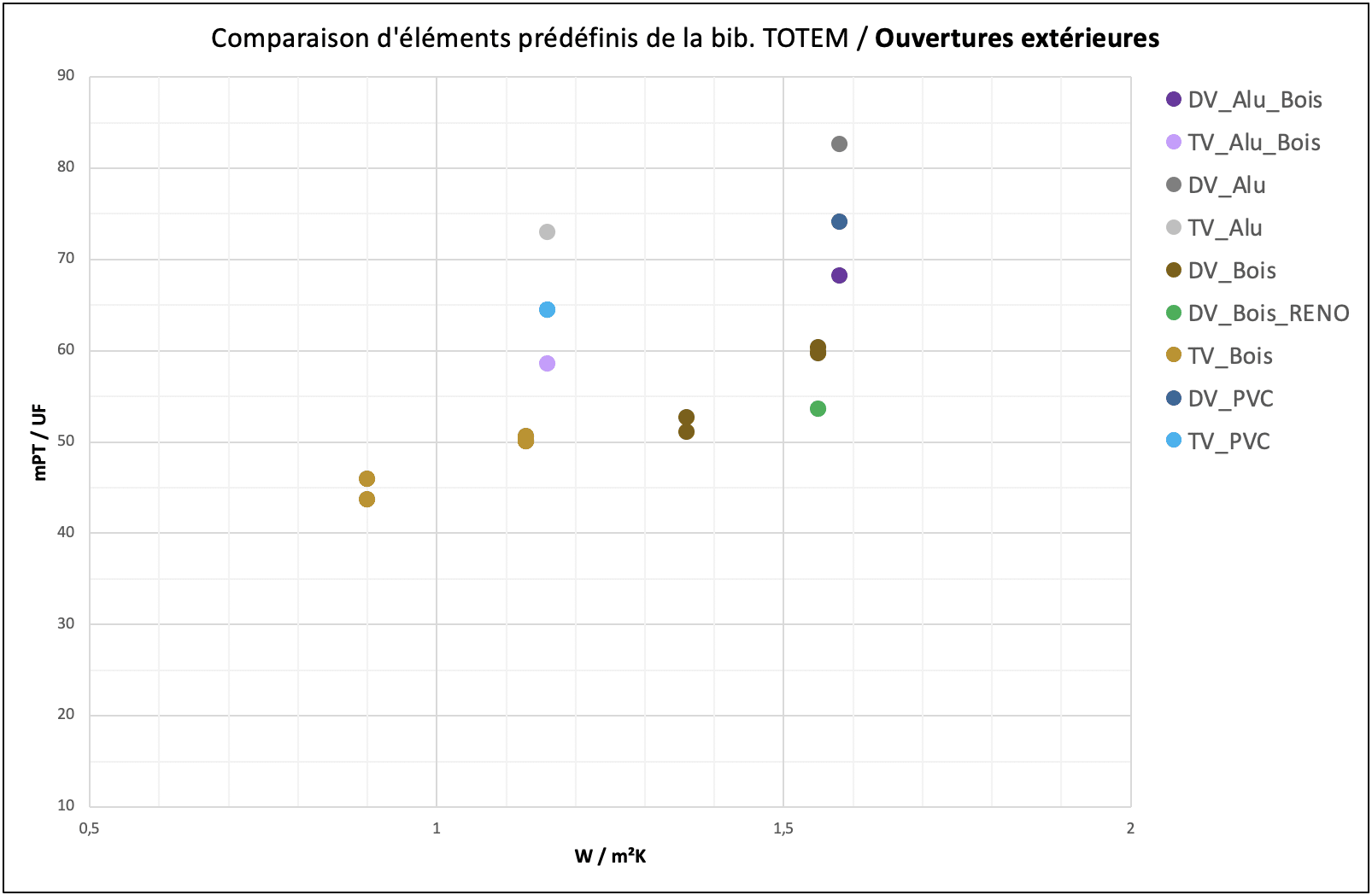

Le graphique ci-dessous représente l’ensemble des fenêtres répertoriés dans la bibliothèque TOTEM. En abscisse sont reprises les valeurs U (W/m2K) et en ordonnée le score agrégé de performance environnementale en millipoints par unité fonctionnelle.

Notons d’abord que plusieurs de ces fenêtres ne respectent pas l’exigence minimale U=< 1.5 W/m²K. Si l’on se concentre sur les autres, on remarque ne assez grande variabilité de score environnemental, puisque celui-ci varie entre 43 et 74 mPt/UF.

Quelles tendances identifier ?

- Premièrement, les fenêtres avec châssis bois présentent le meilleur score environnemental, que ce soit en simple ou, encore mieux, en triple vitrage. Le bois-alu arrive deuxième, et le PVC troisième. Le châssis aluminium ferme la marche.

- Deuxièmement, le passage au triple vitrage permet systématiquement d’améliorer le score environnemental global, à matériau de châssis équivalent. L’ordre de grandeur de ce bénéfice est cependant inférieur à celui d’un changement de matériau de châssis. Par exemple, passer d’un châssis aluminium double vitrage à un aluminium triple vitrage vous fera gagner une dizaine de millipoints, alors que le passage vers un châssis bois double vitrage vous en fait gagner près de 20.

Attention cependant, ce chapitre de la bibliothèque TOTEM ne contient que peu de points. L’analyse sera donc à refaire lorsque cette bibliothèque se sera enrichie.

Vers une trop grande complexité de vitrages ?

Pour compléter l’analyse générale ci-dessous, nous pouvons nous trouver vers les recherche du dr. Jean Souviron((Jean Souviron. Glazing Beyond Energy Efficiency: An Environmental Analysis of the Socio-Technical Trajectory of Architectural Glass. Architecture, space management. Université Libre de Bruxelles (U.L.B.), Belgium, 2022. English.)), dont la thèse de doctorat porte sur l’analyse de cycle de vie des vitrages. En particulier, il analyse la tendance à la complexification des technologies de vitrages ces dernières décennies (doublement puis triplement des feuilles de verre, ajout de couches basses émissivité, remplissages gazeux, etc.) et s’interroge sur le bilan environnemental de ces vitrages dans un scénario de rénovation énergétique de bureaux : est-ce que les bénéfices des ces technologies lors de l’utilisation du bâtiment surpassent le coût environnemental d’une production plus complexe ? Ceci en se basant sur une analyse détaillée des cycles de production et des potentiels de récupérations et recyclage des vitrages.

Pour vous la faire courte, voici ses principales conclusions :

- le meilleur vitrage est … celui qu’on ne produit pas. avant de se questionner sur quel vitrage pour remplacer ceux en fin de vie, il convient de se pencher sur la nécessité de ces vitrages, dnas une logique de réduction globale des quantités de matières utilisées. A noter cependant qu’il centre sont travail sur la rénovation des murs rideaux, pour lesquels effectivement la quantité de verre peut être mise en question. La situation est différente pour une architecture de fenêtres.

The most significant (impact) would be to minimise the production of flat glass due to the energy-intensive nature of float plants and their dependence on fossil fuels.

- l’impact environnemental des vitrages est grevé par une grande difficulté à recycler les produits développés aujourd’hui, principalement du fait des difficultés à dissocier les composants des complexes de vitrage.

This means that the design of insulating glass units itself should be revised so that they provide sufficient acoustic and thermal insulation, while the materials from which they are made can be easily separated.

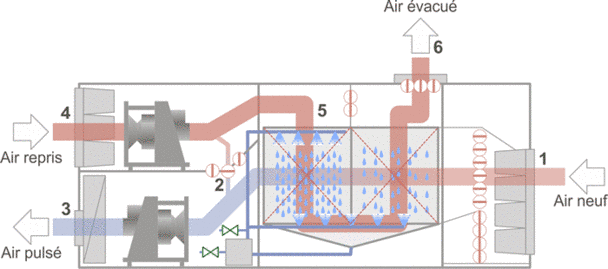

- Sur la valeur ajoutée des vitrages « complexes », il pointe l’énorme incertitude qui entoure les analyses de cycle de vie actuelles, dans un contexte climatique changeant, un mix énergétique en transition, une variété d’hypothèses d’utilisation et de gains internes ou de systèmes HVAC et, potentiellement, une remise en question des ambiances intérieures à maintenir dans les bâtiments à l’avenir.

If the hypotheses and the definition of the life cycle scenarios can significantly change the conclusions of an LCA, how can the uncertainties related to the socio-technical trajectory of buildings be better taken into account?

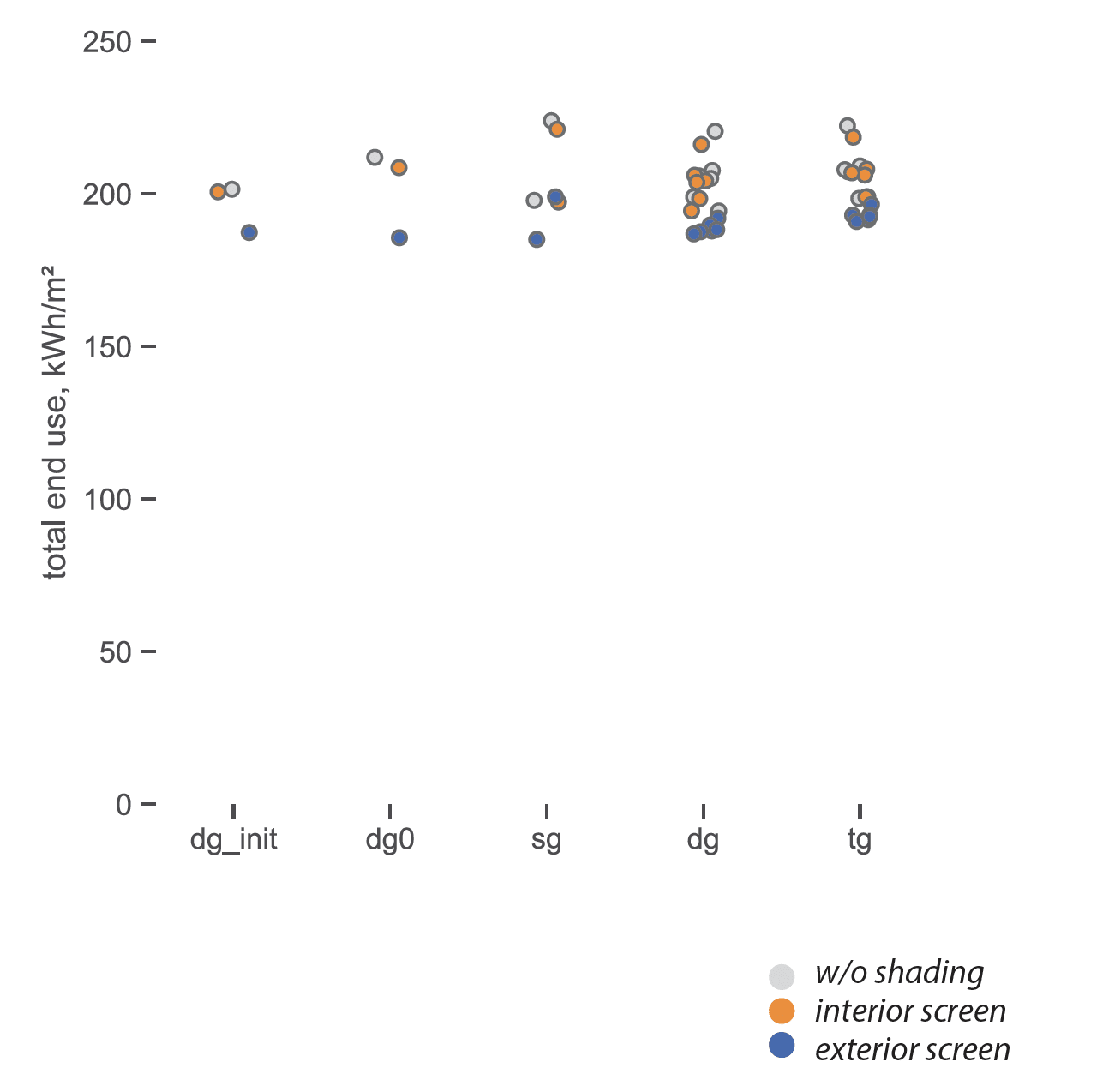

- Pour en venir au choix des complexes de vitrage dans une situation donnée, ses résultats indiquent une … équivalence de consommations énergétique globale pour les simples (sg), double (dg) et triples vitrages (tg). Signe que les vraies pistes de réduction d’impact ne sont peut-être pas dans un choix de technologie.

Incohérent avec ce qui précède ? Non, nous ne le pensons pas. L’incertitude des analyses de cycle de vie est aujourd’hui encore grande, tout le monde le reconnais. Des résultats non convergents sont donc « attendus ». A ce stade des connaissances, les ACV peuvent donner des indications, pas des certitudes. Et dans le cas présent, concluons qu’aucune tendance claire en fonction de l’une ou l’autre technologie ne se dégage au niveau des vitrages « classiques » (résultats du dr. Souviron) et qu’au niveau des châssis, le bois semble tirer son épingle du jeu (résultats TOTEM).

Cet article a été révisé pour la dernière fois en été 2023. Les données et analyses présentées reflètent l’état des connaissances et des ressources disponibles à ce moment-là. Le domaine de la construction et de l’évaluation environnementale évoluant rapidement, nous encourageons nos lecteurs à vérifier si des mises à jour ou des compléments d’information ont été publiés depuis.